Digitale Bildforensik

Digitale Bildforensik ist eine Teildisziplin der digitalen Multimediaforensik und widmet sich der Untersuchung der Authentizität digitaler Bilder unter anderem zur Gewinnung von Indizien in der Kriminalistik (vgl. Forensik). Bei den meisten in der Praxis relevanten bildforensischen Verfahren handelt es sich um „blinde“ Verfahren, d. h., sie benötigen keinerlei Zugriff auf ein möglicherweise vorhandenes Originalbild, sondern gewinnen Indizien allein durch eine Analyse der Bilddaten an sich.

Ziele

[Bearbeiten | Quelltext bearbeiten]Verfahren der digitalen Bildforensik dienen der Bestimmung des Bildursprungs und der Erkennung von Manipulationen digitaler Bilddaten. Ausgangspunkt ist in der Regel ein zu untersuchendes digitales Bild, dessen Eigenschaften mit statistischen Methoden in einem meist (semi-)automatisierten Prozess analysiert werden. Bei den meisten Verfahren wird keine Kenntnis eines möglicherweise vorhandenen (analogen oder digitalen) Originalbildes vorausgesetzt.

Für eine Untersuchung der Authentizität eines Bildes werden die vorliegenden Bilddaten dabei hinsichtlich verschiedener Merkmale überprüft:

- Existenz von Charakteristiken des Bildeingabegerätes

- Nichtexistenz der Spuren von Bildbearbeitungsoperationen

Eine grundsätzliche Diskussion zur Entstehung und Nutzung von derartigen Merkmalen enthält der Artikel über Multimediaforensik.

Bestimmung des Bildursprungs

[Bearbeiten | Quelltext bearbeiten]Ein wichtiger Aspekt bei der Untersuchung der Authentizität digitaler Bilddaten ist die Frage nach der Herkunft eines Bildes. Techniken der digitalen Bildforensik versuchen eine Verbindung zwischen einer vorliegenden Bilddatei und dem verwendeten Bildeingabegerät (Scanner, Digitalkamera etc.) herzustellen.

Generell basieren Methoden zur Bestimmung des Bildursprungs auf Charakteristiken des Bildeingabegerätes. Können für ein Gerät spezifische Merkmale in einem Bild nachgewiesen werden, so kann dies als Indiz für die Herkunft des Bildes dienen. Je nach Anwendung und Art der Merkmale ergeben sich verschiedene Detailgrade bei der Bestimmung des Ursprungs. Typische Szenarien sind die Unterscheidung von computergenerierten und natürlichen Bildern, die Bestimmung der Geräteklasse sowie die Identifikation des Gerätemodells bis hin zur Erkennung des spezifischen Geräts. Grundsätzlich machen alle Methoden zur Bestimmung des Bildursprungs die Annahme, dass Bilder gleicher Herkunft sehr ähnliche Eigenschaften aufweisen und sich somit von Bildern anderen Ursprungs statistisch abgrenzen lassen.

Computergenerierte Bilder vs. natürliche Bilder

[Bearbeiten | Quelltext bearbeiten]Prinzipiell stellt sich zunächst die Frage, ob ein vorliegendes Bild vollständig von einem Computer generiert wurde oder einen mit einem Sensor aufgenommenen Ausschnitt der Realität darstellt. Anders als natürliche Bilder entspringen computergenerierte Bilder gänzlich dem Vorstellungsvermögen des Urhebers und sind deshalb bezüglich ihres Inhaltes unter Umständen anders zu werten. Für eine Unterscheidung wird dabei die Annahme gemacht, dass der Prozess zur Erstellung computergenerierter Bilder den komplexen Aufnahmeablauf im Inneren eines Bildeingabegerätes nicht vollständig nachbilden kann (bzw. dies nicht als primäres Ziel verfolgt). Typische Ansätze gewinnen ihre Indizien aus einer Analyse von Rauscheigenschaften des Bildes oder Zusammenhängen zwischen benachbarten Pixeln.[1][2]

Die Problematik der Unterscheidung zwischen computergenerierten und natürlichen Bildern wird im Zusammenhang mit der Verfolgung von Kinderpornographie insbesondere in den USA diskutiert.[3] Abbildungen mit kinderpornographischem Inhalt, die vollständig computergeneriert sind, werden dort strafrechtlich anders behandelt.

Geräteklasse

[Bearbeiten | Quelltext bearbeiten]Die Zuordnung eines Bildes zu einer Klasse von Eingabegeräten hat eine Unterscheidung grundlegender Aufnahmekonzepte zum Ziel. Ein möglicher Anwendungsfall ist die Unterscheidung zwischen Bildern von Digitalkameras und Flachbettscannern. Dabei macht man sich elementare Unterschiede im Aufbau der verschiedenen Geräte zunutze. Typische Merkmale basieren auf dem Einsatz unterschiedlicher Sensorarchitekturen (Flächensensor bei Kameras vs. Zeilensensor bei Flachbettscannern). Mit einem Zeilensensor aufgenommene Bilder haben im Allgemeinen andere Rauschcharakteristiken als solche, die einem Flächensensor entstammen.[4] Außerdem ist im Flachbettscanner meist keine Farbinterpolation notwendig, die in Digitalkamerabildern zu charakteristischen Abhängigkeiten zwischen benachbarten Pixels führt.[5]

Gerätemodell

[Bearbeiten | Quelltext bearbeiten]Einzelne Gerätearten lassen sich weiter in verschiedene Modelle unterteilen. Da Geräte gleichen Modells aus baugleichen Komponenten bestehen, lassen sich Bilder, die mit einem bestimmten Modell aufgenommen wurden, aufgrund ähnlicher Eigenschaften diesem zuordnen. Neben der Suche nach dem Gerätemodell ist unter Umständen bereits die Identifikation des Geräteherstellers relevant.

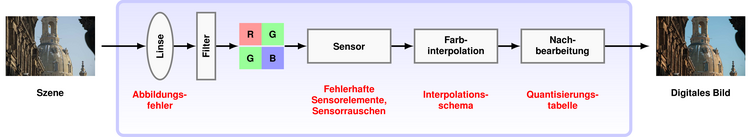

Anhaltspunkte für die Bestimmung des Gerätemodells lassen sich aus nahezu allen Komponenten eines Bildeingabegerätes ableiten, so zum Beispiel:

- Verschiedene Linsensysteme führen zu Abbildungsfehlern unterschiedlicher Ausprägung.

- Mit dem Einsatz unterschiedlicher Sensoren variieren die Rauschcharakteristiken zwischen Bildern verschiedener Modelle systematisch.[6]

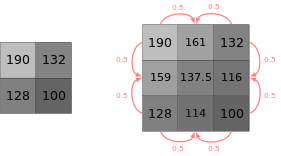

- Der Aufbau des Farbfilterarrays (bspw. Bayer-Sensor) und der verwendete Farbinterpolationsalgorithmus führen zu modellspezifischen Abhängigkeiten zwischen benachbarten Pixeln.[7]

- Die Umsetzung von weiteren geräteinternen Bearbeitungsschritten zur Aufbereitung des Farbbildes (bspw. Weißabgleich) haben systematische Ähnlichkeiten zwischen den einzelnen Farbkanälen zur Folge.[8]

- Der Einsatz vieler verschiedener Quantisierungstabellen führt darüber hinaus zu Unterschieden in den ausgegebenen JPEG-Dateien.[9]

Die Bestimmung des Gerätemodells wird meist als Klassifikationsproblem der Mustererkennung aufgefasst, bei dem einzelne Modelle je einer Klasse entsprechen. Da in der Regel von nicht-linear separierbaren Klassen ausgegangen wird, sind Support Vector Machines häufig das Mittel der Wahl. Die Dimensionalität des Merkmalsraumes ist dabei oftmals sehr hoch, so dass verstärkt Verfahren zur Reduktion der Merkmalsvektoren Anwendung finden.[6]

Spezifisches Gerät

[Bearbeiten | Quelltext bearbeiten]Die Identifikation eines spezifischen Gerätes hat das Ziel, auch baugleiche Bildeingabegeräte (d. h. Geräte vom gleichen Modell) unterscheiden zu können. Bereits eine der ersten Fachpublikation auf dem Gebiet der Bildforensik widmete sich dieser Problematik und schlug vor, defekte Sensorelemente als Identifikationsmerkmal zu nutzen.[10] Ein ähnlicher Ansatz beruht auf Staubpartikelablagerungen auf dem Sensor von digitalen Spiegelreflexkameras, die zu kameraspezifischen Artefakten im Bild führen. Untersuchungen zeigen, dass diese auch trotz automatischer Sensorreinigung ein geeignetes Identifikationsmerkmal darstellen.[11]

Die nach heutigem Wissen zuverlässigste und bestuntersuchte Methode zur Bestimmung des Bildursprungs basiert auf dem CCD/CMOS-Sensorrauschen von typischen Bildeingabegeräten und wurde in der Gruppe um Jessica Fridrich entwickelt. Die Methode basiert auf der Annahme, dass jedes Sensorelement geringfügig anders auf eintreffendes Licht reagiert, was zu einem systematischen Rauschanteil im aufgenommenen Bild führt. Dieser ist vergleichsweise stabil über mehrere Aufnahmen eines Gerätes hinweg, variiert jedoch in Bildern verschiedener Herkunft. Der charakteristische Rauschanteil (die sogenannte photo-response non-uniformity, PRNU) kann mittels eines geeigneten Rauschfilters aus dem Bild abgeschätzt werden. Über einen Korrelations- oder Maximum-Likelihood -Detektor lässt sich dann das zur Aufnahme verwendete Gerät bestimmen, indem das geschätzte Rauschsignal mit bekannten Referenzrauschmustern verglichen wird.[12] Das charakteristische Sensorrauschen lässt sich auch in verlustbehaftet komprimierten Bildern nachweisen und übersteht unter bestimmten Umständen selbst eine Analogwandlung (bspw. Ausdrucken) mit nachfolgender Redigitalisierung.[13]

Leistungsfähigkeit und Erkennungsraten

[Bearbeiten | Quelltext bearbeiten]Grundsätzlich ist bei der Bestimmung des Bildursprungs immer eine möglichst geringe Falschakzeptanzrate erstrebenswert. In praktischen Anwendungen sollte das Risiko minimiert werden, dass ein Bild fälschlicherweise einem Gerät zugeordnet wird, das nicht an dessen Entstehung beteiligt war.

Die mit Abstand zuverlässigste Herkunftszuordnung von digitalen Bildern lässt sich mit dem Sensorrauschen erreichen. In einem groß angelegten Test mit mehr als einer Million Bildern von über 6800 verschiedenen Digitalkameras (insgesamt 150 Modelle) konnten bei einer Falschakzeptanzrate von 2,4×10−5 nahezu 98 % aller Bilder ihrem korrekten Ursprung zugeordnet werden.[14]

Inwiefern derart hohe Erkennungsraten unter praktischen Bedingungen auch für die Bestimmung von Art und Modell des Gerätes erreichbar sind, muss weitestgehend noch als offene Forschungsfrage betrachtet werden. In der Literatur berichtete Ergebnisse basieren meist auf vergleichsweise kleinen Datensätzen, die eine Verallgemeinerung nicht zulassen. Im Allgemeinen liegen die Erkennungsraten für die Bestimmung von Art oder Modell bisher jedoch unter denen der auf Sensorrauschen basierenden Technik zur Bestimmung eines spezifischen Geräts.[6]

Erkennung von Bildmanipulationen

[Bearbeiten | Quelltext bearbeiten]Neben der Bestimmung des Bildursprungs ist die Erkennung von Manipulationen digitaler Bilddaten die zweite zentrale Zielstellung der digitalen Bildforensik. Hierbei kann sowohl das inkonsistente Auftreten (bzw. das Fehlen) von Gerätecharakteristiken als auch das Vorhandensein von Bildbearbeitungsartefakten ausgenutzt werden.

Konsistenz von Gerätecharakteristiken

[Bearbeiten | Quelltext bearbeiten]

Jedes Bildeingabegerät hinterlässt charakteristische Spuren in den von ihm aufgenommenen Bildern. Unter der Annahme, dass typische Bildbearbeitungsoperationen (z. B. in Photoshop, GIMP etc.) die Ausprägung dieser Charakteristiken beeinflussen, kann ein Bild hinsichtlich des (konsistenten) Vorhandenseins geeigneter Gerätecharakteristiken untersucht werden. Lassen sich die zu erwartenden Merkmale nicht (konsistent) im Bild nachweisen, kann dies als Indiz für eine Manipulation aufgefasst werden.

Für die Erkennung von Bildmanipulationen anhand von fehlenden oder inkonsistenten Gerätecharakteristiken existiert eine Vielzahl verschiedener Ansätze, die je nach Situation besser oder schlechter geeignet sind:

- Die Ausprägung von Abbildungsfehlern ist im Allgemeinen abhängig von der Position im Bild und nimmt mit zunehmendem Abstand vom optischen Mittelpunkt an Stärke zu. Wird ein Bildausschnitt unter Nichtbeachtung dieser Charakteristik innerhalb eines Bildes kopiert oder aus einem anderen Bild eingefügt, führt das zu nachweisbaren Inkonsistenzen.[15]

- Da jedes Sensorelement eine eigene Rauschcharakteristik aufweist, ist das Sensorrauschen ebenso abhängig von der Bildposition. Wenn bekannt ist, mit welchem Gerät ein Bild aufgenommen wurde, kann auf eine lokale Konsistenz des Sensorrauschens geprüft werden. In Bildbereichen, die (zu stark) bearbeitet wurden oder aus gänzlich anderen Bildern stammen, fehlt das gerätespezifische Rauschen.[12]

- Unter der Annahme, dass ein Bild mit einem One-Shot-Sensor aufgenommen wurde, kann auf das (konsistente) Vorhandensein von Farbinterpolationsspuren geprüft werden. Interpolierte Bilder weisen charakteristische Abhängigkeiten zwischen benachbarten Pixeln auf, die durch Nachbearbeitung abgeschwächt oder entfernt werden.[16]

- Die durch JPEG-Kompression verursachten Blockartefakte können ebenso nützliche Hinweise auf Bildmanipulationen geben. Wird ein Ausschnitt aus einem unkomprimierten Bild in ein JPEG-Bild eingefügt (oder andersherum), fehlen die zu erwartenden 8×8 Blöcke, die selbst bei sehr hoher JPEG-Qualität noch statistisch nachweisbar sind.[17] Auffällige Spuren entstehen außerdem, wenn beim Einfügen von JPEG-komprimierten Bildausschnitten in ein bereits komprimiertes Bild die vorhandene Blockstruktur nicht beachtet wird, d. h., eine Verschiebung der Blockgrenzen auftritt.[18] Selbst bei Beachtung der Blockstruktur kann bereits das Einfügen von Bildausschnitten, die mit einer abweichenden Quantisierungstabelle komprimiert wurden, zu nachweisbaren Spuren führen.[19]

Artefakte durch Bildbearbeitung

[Bearbeiten | Quelltext bearbeiten]

Neben fehlenden bzw. inkonsistenten Gerätecharakteristiken können auch Spuren der Bildbearbeitungsoperation an sich für forensische Analysen genutzt werden. In diesem Fall dient explizit das Vorhandensein bestimmter Merkmale als Indiz für eine mögliche Manipulation.

Eine Erkennung von Bildmanipulationen anhand von Bearbeitungsartefakten hat gegenüber auf Gerätecharakteristiken basierten Verfahren den Vorteil, dass keinerlei Annahmen über das Aufnahmegerät gemacht werden müssen. Typische nachweisbare Artefakte entstehen beispielsweise durch:

- Geometrische Transformationen zur Anpassung von Größe und Form von Bildern oder Teilen davon und der damit verbundenen Interpolation. Wird ein Bild geometrisch transformiert, müssen fehlende Informationen an entstehenden Lücken im Bildgitter durch Interpolation aus den vorhandenen Pixeln im Ausgangsbild berechnet werden. Dies führt zu räumlicher Periodizität[20] in den Abhängigkeiten zwischen benachbarten Pixeln,[21] die mit statistischen Methoden nachgewiesen werden können.

- Copy & Paste Operationen zur Retusche von Bildausschnitten. Wurde ein Ausschnitt innerhalb des Bildes kopiert (bspw. mit einem Kopierpinsel), lässt sich dies durch eine Suche nach doppelten Bildteilen feststellen. Um geringfügige Abweichungen zwischen den kopierten Bereichen nachweisen zu können, werden nicht die Pixelwerte an sich, sondern eine transformierte Repräsentation (DCT, PCA, …) verglichen.[22]

- Rekompression beim wiederholten Abspeichern eines verlustbehaftet komprimierten Bildes. Wird ein JPEG-Bild nochmals im JPEG-Format gespeichert (etwa nach einer Bearbeitung), kann dies zu nachweisbaren Spuren in den DCT-Koeffizienten führen, wenn die zweite Kompression eine abweichende Quantisierungstabelle verwendet.[23]

Wann ist eine Fälschung eine Fälschung?

[Bearbeiten | Quelltext bearbeiten]Methoden der Bildforensik können nicht die semantische Frage beantworten, ob es sich bei einem Bild um eine Fälschung handelt. Sie können höchstens objektiv feststellen, ob ein Bild in irgendeiner Form bearbeitet wurde. Um Fälschungen als solche erkennen zu können, muss zunächst klar sein, was unter einer Fälschung zu verstehen ist. In der Praxis gestaltet sich eine solche Abgrenzung jedoch häufig als nicht trivial. Eine zentrale Frage ist dabei, ob (und welche) inhaltsverändernden Operationen erlaubt sind. Im Allgemeinen ist außerdem davon auszugehen, dass nahezu jedes publizierte Bild in irgendeiner Form nachbearbeitet wurde (Farbkorrektur, …). Für klarere Verhältnisse haben viele Zeitungen und Zeitschriften daher eigene Richtlinien zur Bildbearbeitung für Bildredakteure formuliert.[24]

Grenzen

[Bearbeiten | Quelltext bearbeiten]Obwohl bildforensische Verfahren einen vielversprechenden Ansatz zur Überprüfung der Authentizität digitaler Bilder darstellen, sind für einen breiten Einsatz in der Praxis noch einige Hindernisse zu überwinden.

Eine große Herausforderung stellt für den Großteil aller Methoden die Analyse verlustbehaftet komprimierter Bilddaten dar (abgesehen von den Verfahren, die direkt auf Kompressionsartefakte aufbauen). Häufig werden subtile Gerätecharakteristiken oder Manipulationsspuren durch eine zu starke Kompression verwischt. Dies ist umso mehr ein Problem, da das JPEG-Format vermutlich das am weitesten verbreitete Dateiformat zur Speicherung von digitalen Bildern darstellt.

Ein allgemeines Problem besteht in dem vergleichsweise hohem Testaufwand in der Bewertung bildforensischer Verfahren. Aufgrund der hohen Komplexität und schlechten Modellierbarkeit typischer Bilddaten kann eine Einschätzung der Zuverlässigkeit nur empirisch erfolgen. Eine Erstellung umfassender und repräsentativer Testdatensätze ist jedoch sehr aufwändig, so dass momentan in der Literatur berichtete Fehlerraten oft wenig aussagekräftig sind.

Zudem ist der Beweiswert von mit bildforensischen Verfahren gewonnenen Indizien vor Gericht derzeit schwer einschätzbar, da Berichte über die Rechtspraxis wenn überhaupt nur in anekdotischer Form vorliegen. In jedem Fall ist derzeit davon auszugehen, dass bildforensische Analysen in Form von Expertengutachten in die Beweiswürdigung eingehen und daher relativ zeitaufwändig und teuer sind.[25]

Siehe auch

[Bearbeiten | Quelltext bearbeiten]Literatur

[Bearbeiten | Quelltext bearbeiten]- Oliver Deussen: Bildmanipulationen: Wie Computer unsere Wirklichkeit verzerren. Spektrum Akademischer Verlag, Berlin/Heidelberg 2007, ISBN 978-3-8274-1900-2, Kapitel 7 (Bildmanipulationen technisch erkennen: Digitale Forensik).

- Hany Farid: Image forgery detection. In: IEEE Signal Processing Magazine. Vol. 26, Nr. 2, März 2009, ISSN 1053-5888, S. 16–25, doi:10.1109/MSP.2008.931079.

- Judith A. Redi, Wiem Taktak, Jean-Luc Dugelay: Digital image forensics: a booklet for beginners. In: Multimedia Tools and Applications. Vol. 51, Nr. 1, Januar 2011, ISSN 1380-7501, S. 133–162, doi:10.1007/s11042-010-0620-1.

- Andrea Trinkwalder: Digitale Bildforensik: Algorithmen jagen Fälscher. In: c’t – magazin für computertechnik. 18. August 2008, ISSN 0724-8679, S. 152–156.

Weblinks

[Bearbeiten | Quelltext bearbeiten]- Literaturdatenbank zum Thema Digitale Bildforensik

- Digitale Bildforensik: Dem Bildfälscher auf der Spur. (PDF; 2,5 MB) Vortrag zur Langen Nacht der Wissenschaft 2010 in Dresden

- Hany Farid: Digital Forensic Database

- Andrew Lewis: Multimedia Forensics Bibliography

Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Siwei Lyu, Hany Farid: How realistic is photorealistic? In: IEEE Transactions on Signal Processing. Vol. 53, Nr. 2, Februar 2005, ISSN 1053-587X, S. 845–850, doi:10.1109/TSP.2004.839896.

- ↑ A. Emir Dirik, Sevinç Bayram, Husrev T. Sencar, Nasir Memon: New features to identify computer generated images. In: ICIP 2007. Vol. 4, Oktober 2007, S. 433–436 (isis.poly.edu [PDF; 279 kB]).

- ↑ Hany Farid: Creating and detecting doctored and virtual images: Implications to the child pornography prevention act. September 2004 (cs.dartmouth.edu [PDF; 4,7 MB]).

- ↑ Nitin Khanna, George T.-C. Chiu, Jan P. Allebach, Edward J. Delp III: Forensic techniques for classifying scanner, computer generated and digital camera images. In: ICASSP 2008. März/April, 2008, S. 1653–1656, doi:10.1109/ICASSP.2008.4517944.

- ↑ Christine McKay, Ashwin Swaminathan, Hongmei Gou, Min Wu: Image acquisition forensics: Forensic analysis to identify imaging source. In: ICASSP 2008. März/April, 2008, S. 1657–1660, doi:10.1109/ICASSP.2008.4517945.

- ↑ a b c Tomáš Filler, Jessica Fridrich, Miroslav Goljan: Using sensor pattern noise for camera model identification. In: ICIP 2008. Oktober 2008, S. 1296–1299, doi:10.1109/ICIP.2008.4712000.

- ↑ Sevinç Bayram, Husrev T. Sencar, Nasir Memon: Classification of digital camera-models based on demosaicing artifacts. In: Digital Investigation. Vol. 5, Nr. 1–2, September 2008, ISSN 1742-2876, S. 49–59, doi:10.1016/j.diin.2008.06.004.

- ↑ Mehdi Kharrazi, Husrev T. Sencar, Nasir Memon: Blind source camera identification. In: ICIP 2004. Oktober 2004, S. 709–712, doi:10.1109/ICIP.2004.1418853.

- ↑ Hany Farid: Digital image ballistics from JPEG quantization: A followup study. Dezember 2008 (cs.dartmouth.edu [PDF; 264 kB]).

- ↑ Kenji Kurosawa, Kenro Kuroki, Naoki Saitoh: CCD fingerprint method – identification of a video camera from videotaped images. In: ICIP 1999. Oktober 1999, S. 537–540, doi:10.1109/ICIP.1999.817172.

- ↑ A. Emir Dirik, Husrev T. Sencar, Nasir Memon: Digital single lens reflex camera identification from traces of sensor dust. In: IEEE Transactions on Information Forensics and Security. Vol. 3, Nr. 3, September 2008, ISSN 1556-6013, S. 539–552 (isis.poly.edu [PDF; 1,6 MB]).

- ↑ a b Jessica Fridrich: Digital Image Forensics. In: IEEE Signal Processing Magazine. Vol. 26, Nr. 2, März 2009, ISSN 1053-5888, S. 26–37, doi:10.1109/MSP.2008.931078.

- ↑ Miroslav Goljan, Jessica Fridrich, Jan Lukáš: Camera identification from printed images. In: Edward J. Delp III u. a. (Hrsg.): Security, Forensics, Steganography, and Watermarking of Multimedia Contents X. SPIE Vol. 6819, Januar 2008, 68190I, doi:10.1117/12.766824.

- ↑ Miroslav Goljan, Jessica Fridrich, Tomáš Filler: Large scale test of sensor fingerprint camera identification. In: Edward J. Delp III u. a. (Hrsg.): Media Forensics and Security XI. SPIE Vol. 7254, Januar 2009, 72540I, doi:10.1117/12.805701.

- ↑ Micah K. Johnson, Hany Farid: Exposing digital forgeries through chromatic aberration. In: MM&Sec’06. ACM Press, New York September 2006, S. 48–55, doi:10.1145/1161366.1161376.

- ↑ Alin C. Popescu, Hany Farid: Exposing digital forgeries in color filter array interpolated images. In: IEEE Transactions on Signal Processing. Vol. 53, Nr. 10, Oktober 2005, ISSN 1053-587X, S. 3948–3959, doi:10.1109/TSP.2005.855406.

- ↑ Ramesh Neelamani, Ricardo de Queiroz, Zhigang Fan, Sanjeeb Dash, Richard G. Baraniuk: JPEG compression history estimation for color images. In: IEEE Transactions on Image Processing. Vol. 15, Nr. 6, Juni 2006, ISSN 1057-7149, S. 1365–1378, doi:10.1109/TIP.2005.864171.

- ↑ Weihai Li, Yuan Yuan, Nenghai Yu: Passive detection of doctored JPEG image via block artifact grid extraction. In: Signal Processing. Vol. 89, Nr. 9, September 2009, ISSN 0165-1684, S. 1821–1829, doi:10.1016/j.sigpro.2009.03.025.

- ↑ Hany Farid: Exposing digital forgeries from JPEG ghosts. In: IEEE Transactions on Information Forensics and Security. Vol. 4, Nr. 1, Januar 2009, ISSN 1556-6013, S. 154–160, doi:10.1109/TIFS.2008.2012215.

- ↑ Jan Lukáš, Jessica Fridrich, Miroslav Goljan: Digital Camera Identification from Sensor Pattern Noise

- ↑ Matthias Kirchner: Fast and reliable resampling detection by spectral analysis of fixed linear predictor residue. In: MM&Sec'08. ACM Press, New York September 2008, S. 11–20, doi:10.1145/1411328.1411333.

- ↑ Sevinç Bayram, Husrev T. Sencar, Nasir Memon: A survey of copy-move forgery detection techniques. 2008 (isis.poly.edu [PDF; 528 kB]).

- ↑ Alin C. Popescu, Hany Farid: Statistical tools for digital forensics. In: Information Hiding 2004. LNCS 3200. Springer Verlag, Berlin/Heidelberg 2004, ISBN 978-3-540-24207-9, S. 128–147, doi:10.1007/b104759.

- ↑ Alfred Büllesbach: Digitale Bildmanipulation und Ethik. Aktuelle Tendenzen im Fotojournalismus. In: Elke Grittmann u. a. (Hrsg.): Global, lokal, digital – Fotojournalismus heute. Herbert Von Halem Verlag, Köln 2008, ISBN 978-3-938258-64-4, S. 128–147 (lmz-bw.de [PDF; 198 kB]).

- ↑ Michael Knopp: Digitalfotos als Beweismittel. In: Zeitschrift für Rechtspolitik. Band 41, Nr. 5, 2008, ISSN 0514-6496, S. 156–158.