Konsistente Schätzfolge

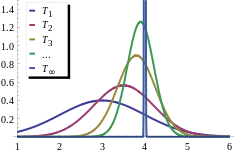

Als eine konsistente Schätzfolge bezeichnet man in der Schätztheorie, einem Teilgebiet der mathematischen Statistik, eine Folge von Punktschätzern, die sich dadurch auszeichnet, dass sie bei größer werdender Stichprobe den zu schätzenden Wert immer genauer schätzt.

Je nach Konvergenzart unterscheidet man schwache Konsistenz (Konvergenz in Wahrscheinlichkeit), starke Konsistenz (fast sichere Konvergenz) sowie -Konsistenz (Konvergenz im p-ten Mittel) mit dem Spezialfall Konsistenz im quadratischen Mittel (Konvergenz im quadratischen Mittel, Sonderfall der Konvergenz im p-ten Mittel für ). Wird von Konsistenz ohne einen Zusatz gesprochen, so ist meist die schwache Konsistenz gemeint. Alternativ finden sich auch die Bezeichnungen konsistente Folge von Schätzern und konsistenter Schätzer, wobei Letzteres fachlich nicht korrekt ist. Allerdings ist die Konstruktion als Folge meist nur dadurch bedingt, dass die größer werdende Stichprobe formalisiert werden muss. Die der Folge zugrundeliegende Idee bleibt meist unverändert.

Das Konzept der Konsistenz lässt sich auch für statistische Tests formulieren, man spricht dann von konsistenten Testfolgen.

Definition[Bearbeiten | Quelltext bearbeiten]

Rahmenbedingungen[Bearbeiten | Quelltext bearbeiten]

Gegeben sei ein statistisches Modell

und eine Folge von Punktschätzern in einen Ereignisraum

- ,

die nur von den ersten Beobachtungen abhängen. Sei

eine zu schätzende Funktion.

Konsistenz oder schwache Konsistenz[Bearbeiten | Quelltext bearbeiten]

Die Folge heißt eine schwach konsistente Schätzfolge oder einfach eine konsistente Schätzfolge, wenn sie für jedes in Wahrscheinlichkeit gegen konvergiert. Es gilt also

für alle und alle . Unabhängig davon, welches der Wahrscheinlichkeitsmaße wirklich vorliegt, ist also für beliebig groß werdende Stichproben die Wahrscheinlichkeit, dass der geschätzte Wert sehr nah an dem zu schätzenden Wert liegt, gleich 1.

Weitere Konsistenzbegriffe[Bearbeiten | Quelltext bearbeiten]

Die weiteren Konsistenzbegriffe unterscheiden sich nur bezüglich der verwendeten Konvergenzart von dem obigen schwachen Konsistenzbegriff. So heißt die Folge

- stark konsistent, wenn sie für alle fast sicher gegen konvergiert;

- im p-ten Mittel konsistent, wenn sie für alle im p-ten Mittel gegen konvergiert;

- im quadratischen Mittel konsistent, wenn sie für im p-ten Mittel konsistent ist.

Detaillierte Beschreibungen der Konvergenzarten sind in den entsprechenden Hauptartikeln zu finden.

Eigenschaften[Bearbeiten | Quelltext bearbeiten]

Aufgrund der Eigenschaften der Konvergenzarten gilt: Sowohl aus der starken Konsistenz als auch aus der Konsistenz im p-ten Mittel folgt die schwache Konsistenz; alle anderen Implikationen sind im Allgemeinen falsch.

Wichtige Hilfsmittel, um starke und schwache Konsistenz zu zeigen, sind das starke Gesetz der großen Zahlen und das schwache Gesetz der großen Zahlen.

Beispiel[Bearbeiten | Quelltext bearbeiten]

Es lässt sich zeigen, dass der Kleinste-Quadrate-Schätzer , der durch die Methode der kleinsten Quadrate gewonnen wird, konsistent für ist, d. h., für ihn gilt

- bzw. .

Die grundlegende Annahme, um die Konsistenz des KQ-Schätzers sicherzustellen, ist die Konvergenz

- ,

gegen eine invertierbare Matrix , d. h. man geht insbesondere also davon aus, dass das durchschnittliche Quadrat der beobachteten Werte der erklärenden Variablen auch bei einem ins Unendliche gehendem Stichprobenumfang endlich bleibt (siehe Produktsummenmatrix#Asymptotische Resultate). Außerdem nimmt man an, dass

- .

Die Konsistenz kann wie folgt gezeigt werden:[1]

- .

Hierbei wurde das Slutsky-Theorem und die Eigenschaft verwendet, dass, wenn deterministisch bzw. nichtstochastisch ist, gilt.

Weblinks[Bearbeiten | Quelltext bearbeiten]

- M. S. Nikulin: Consistent estimator. In: Michiel Hazewinkel (Hrsg.): Encyclopedia of Mathematics. Springer-Verlag und EMS Press, Berlin 2002, ISBN 1-55608-010-7 (englisch, encyclopediaofmath.org).

Literatur[Bearbeiten | Quelltext bearbeiten]

- Hans-Otto Georgii: Stochastik. Einführung in die Wahrscheinlichkeitstheorie und Statistik. 4. Auflage. Walter de Gruyter, Berlin 2009, ISBN 978-3-11-021526-7, doi:10.1515/9783110215274.

- Ludger Rüschendorf: Mathematische Statistik. Springer Verlag, Berlin/Heidelberg 2014, ISBN 978-3-642-41996-6, doi:10.1007/978-3-642-41997-3.

- Claudia Czado, Thorsten Schmidt: Mathematische Statistik. Springer-Verlag, Berlin/Heidelberg 2011, ISBN 978-3-642-17260-1, doi:10.1007/978-3-642-17261-8.

Einzelnachweise[Bearbeiten | Quelltext bearbeiten]

- ↑ George G. Judge, R. Carter Hill, W. Griffiths, Helmut Lütkepohl, T.C. Lee. Introduction to the Theory and Practice of Econometrics. John Wiley & Sons, New York, Chichester, Brisbane, Toronto, Singapore, ISBN 978-0471624141, second edition 1988, S. 266.

![{\displaystyle {\begin{aligned}\operatorname {plim} (\mathbf {b} )&=\operatorname {plim} ((\mathbf {X} _{n}^{\top }\mathbf {X} _{n})^{-1}\mathbf {X} _{n}^{\top }\mathbf {y} )\\&=\operatorname {plim} ({\boldsymbol {\beta }}+(\mathbf {X} _{n}^{\top }\mathbf {X} _{n})^{-1}\mathbf {X} _{n}^{\top }{\boldsymbol {\varepsilon }}))\\&={\boldsymbol {\beta }}+\operatorname {plim} ((\mathbf {X} _{n}^{\top }\mathbf {X} _{n})^{-1}\mathbf {X} _{n}^{\top }{\boldsymbol {\varepsilon }})\\&={\boldsymbol {\beta }}+\operatorname {plim} \left(((\mathbf {X} _{n}^{\top }\mathbf {X} _{n})^{-1}n)\right)\cdot \operatorname {plim} \left(((\mathbf {X} _{n}^{\top }{\boldsymbol {\varepsilon }})/n)\right)\\&={\boldsymbol {\beta }}+[\operatorname {plim} \left(((\mathbf {X} _{n}^{\top }\mathbf {X} _{n})/n)\right)]^{-1}\cdot \underbrace {\operatorname {plim} \left(((\mathbf {X} _{n}^{\top }{\boldsymbol {\varepsilon }})/n)\right)} _{=0}={\boldsymbol {\beta }}+\mathbf {Q} ^{-1}\cdot 0={\boldsymbol {\beta }}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c7844f73cbbc1455495c5dc37b2c0a1bc5825d4f)