Benutzer:Rbb/Bayesianische Statistik

Unter Bayesscher Statistik versteht man einen Zweig der modernen Statistik der mit dem Bayesschen Wahrscheinlichkeitsbegriff und dem Bayesschen Satz Fragestellungen der Stochastik untersucht. Der Fokus auf diese beiden Grundpfeiler begründet die "bayesianische" Statistik als eigene "Stilrichtung". Klassische und bayesianische Statistik führen teilweise zu den gleichen Ergebnissen[1], sind aber nicht vollständig äquivalent. Charakteristisch für bayesianische Statistik ist die konsequente Verwendung von Wahrscheinlichkeitsverteilungen bzw. Randverteilungen, deren Form die Genauigkeit der Verfahren bzw. Verlässlichkeit der Daten und des Verfahrens transportiert.

Der Bayessche Wahrscheinlichkeitsbegriff setzt keine unendlich oft wiederholbaren Zufallsexperimente vorraus und bayesschen Methoden sind daher auch oft bei kleiner Datengrundlage verwendbar, bei wenigen Daten bleibt die Wahrscheinlichkeitsverteilung einfach "breit" und ist nicht stark lokalisiert.

Aufgrund der strengen Betrachtung von Wahrscheinlichkeitsverteilungen sind bayesianische Verfahren oft rechnerisch aufwändig. Dies gilt als ein Grund, weshalb sich im 20. Jahrhundert frequentistische und ad hoc Methoden in der Statistik als prägende Techniken gegenüber bayesianischen durchsetzten. Mit der wachsenden Verbreitung von Computern und Monte Carlo Sampling Verfahren sind nun auch komplizierte bayesianische Verfahren möglich.

Die Auffassung von Wahrscheinlichkeiten als "Grad vernünftiger Glaubwürdigkeit" eröffnet in der bayesianischen Statistik einen anderen Blick auf das Schlussfolgern mit Statistik (im Vergleich zum frequentistischen Ansatz von Wahrscheinlichkeiten als Ergebnisse unendlich oft wiederholbarer Zufallsexperimente). Im Satz von Bayes wird eine bestehende Erkenntnis über die zu untersuchende Variable (die a priori Verteilung) mit den neuen Erkenntnis aus den Daten kombiniert (Modellwahrscheinlichkeit oder Likelihood), sodass man eine neue, verbesserte Erkenntnis (a posteriori Wahrscheinlichkeitsverteilung) erreicht. Die a posteriori Wahrscheinlichkeitsverteilung eignet sich als neuer Prior, wenn neue Daten zur Verfügung stehen.

Struktur Bayesianischer Verfahren[Bearbeiten | Quelltext bearbeiten]

Die Verwendung des Satz von Bayes führt zu einer charakteristischen Struktur bayesianischer Verfahren. Ein Model soll mit einem Datensatz untersucht werden. Die Ausgangsfragestellung ist, wie die Wahrscheinlichkeiten für die Modellparameter veteilt sind, sofern die Daten gegeben sind (und Vorwissen ). Es soll also ein Ausdruck für gefunden werden.

Die einzelnen Wahrscheinlichkeiten eine feste Bezeichnung.

- A-priori-Wahrscheinlichkeit, also die Wahrscheinlichkeitsverteilung für gegeben unserem Vorwissen (ohne die Messdaten aus dem Versuch einzubeziehen)

- A-posteriori-Wahrscheinlichkeit, die Wahrscheinlichkeitsverteilung für gegeben das Vorwissen und die Messdaten

- inverse oder Modell-Wahrscheinlichkeit, bzw. Likelihood, also die Wahrscheinlichkeitsverteilung für die Messdaten , wenn der Modellparameter gegeben ist.

- Evidenz, kann als Normierungsfaktor bestimmt werden.

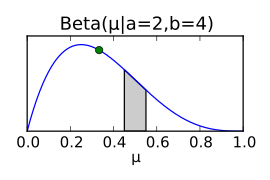

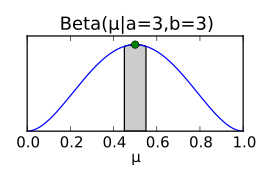

Der Satz von Bayes führt direkt auf einen wichtigen Aspekt der Bayesschen Statistik. Nach der Bayesschen Statistik kann man sein Vorwissen in die statistische Auswertung mit einbringen, bzw. explizit machen (der Prior). Mit Messdaten kann man nun neue Erkenntnisse einbringen und erhält eine Posteriorverteilung die für Vorwissen und Daten gilt. Man kann den Posterior nun als neuen Prior auffassen, der ein erweitertes Vorwissen hat, also . Die folgende Abbildung zeigt, wie aus einem Prior mit Vorwissen ( ist um 0.5 verteilt, jedoch ist die Verteilung sehr breit) mit binomialverteilten Messdaten wird nun die Verteilung um genauer bestimmt, sodass eine schmalere, spitzere Verteilung abgeleitet werden kann. Bei weiteren Beobachtungen kann dieser Posterior wieder als Prior dienen. Entsprechen die Messdaten den bisherigen Erwartungen kann die Breite der Wahrscheinlichkeitsdichtefunktion weiter abnehmen, bei vom Vorwissen abweichenden Messdaten wuerde die Varianz der Verteilung wieder groesser werden und der Erwartungswert wuerde sich gegebenenfalls verschieben.

Der Bayessche Wahrscheinlichkeitsbegriff[Bearbeiten | Quelltext bearbeiten]

Der Bayessche Wahrscheinlichkeitsbegriff definiert Wahrscheinlichkeiten als „Grad vernünftiger Erwartung“ [2]), also als Maß für die Glaubwürdigkeit einer Aussage, der von 0 (falsch, unglaubwürdig) bis 1 (glaubwürdig, wahr) reicht. Diese Interpretation von Wahrscheinlichkeiten und Statistik unterscheidet sich fundamental von der Betrachtung in der konventionellen Statistik in der unendlich oft wiederholbare Zufallsexperimente unter dem Gesichtspunkt betrachtet werden, ob eine Hypothese wahr oder falsch ist.

Bayessche Wahrscheinlichkeiten beziehen sich auf eine Aussage . In der Logik können Aussagen entweder WAHR (oft mit Wert 1 wiedergegeben) oder FALSCH (Wert 0) sein. Der Bayessche Wahrscheinlichkeitsbegriff erlaubt nun Zwischenstufen zwischen den Extremen, eine Wahrscheinlichkeit von 0,25 gibt z. B. wieder, dass eine Tendenz besteht, dass die Aussage falsch sein könnte, aber keine Gewissheit besteht. Zudem ist es möglich, ähnlich der klassischen Aussagenlogik, aus elementaren Wahrscheinlichkeiten und Aussagen komplexere Wahrscheinlichkeiten zu bestimmen. Damit ermöglicht die Bayessche Statistik Schlussfolgerungen und die Behandlung von komplexen Fragestellungen.

- gemeinsame Wahrscheinlichkeiten , also: Wie wahrscheinlich ist es, dass sowohl als auch wahr ist? Wie wahrscheinlich ist es beispielsweise, dass meine Schuhe auf einem Spaziergang trocken sind und dass es zeitgleich regnet.

- bedingte Wahrscheinlichkeiten , also: Wie wahrscheinlich ist es, dass wahr ist, wenn gegeben ist, dass B wahr ist. Wie wahrscheinlich ist es beispielsweise, dass meine Schuhe nach einem Spaziergang im Freien nass sind, wenn es momentan regnet.

Bayesianische Inferenz am Beispiel des Münzwurfes[Bearbeiten | Quelltext bearbeiten]

Der Münzwurf ist ein klassisches Beispiel der Wahrscheinlichkeitsrechnung und eignet sich sehr gut die Eigenschaften der Bayesianischen Statistik zu erläutern. Betrachtet wird, ob beim Wurf einer Münze "Kopf" (1) oder Nicht-Kopf (0, also "Zahl") eintrifft. Typischerweise nehmen wir im Alltag oft an, dass wir eine fünfzigprozentige Wahrscheinlichkeit haben, die eine, oder die andere Seite oben auf zu finden: . Damit könnten wir jedoch keine Münzen beschreiben, die eine große Unebenheit aufweisen, vielleicht sogar manipuliert sind. Sodass wir die Wahrscheinlichkeit von 50% durch einen Parameter ersetzen.

Die Frage, die wir nun mit einem Bayesianischen Ansatz untersuchen wollen ist, wie Wahrscheinlich beliebige Werte für sind, also wie ausgewogen die Münze ist. Das bedeutet, dass wir eine Wahrscheinlichkeitsverteilung für suchen, unter der Bedingung dass wir Beobachtungen (Anzahl von Kopfwürfen und Zahlwürfen in einem Experiment mit Münzwürfen) gemacht haben: . Mit dem Bayesschen Satz können wir diese Wahrscheinlichkeitsfunktion durch Likelihood und a priori Verteilung ausdrücken:

Die Likelihood ist hier eine Wahrscheinlichkeitsverteilung über die Anzahl der Kopfwürfe bei einer gegeben Balance der Münze und einer gegebenen Anzahl an Würfen insgesamt . Diese Wahrscheinlichkeitsverteilung ist bekannt als Binomialverteilung

- .

Im Gegensatz zur a posteriori-Verteilung ist in der Likelihood-Verteilung nur ein Parameter, der die Form der Verteilung bestimmt.

Zur Bestimmung der a posteriori-Verteilung fehlt nun noch die a priori - Verteilung. Auch hier muss — wie bei der Likelihood — eine geeignete Verteilungsfunktion für das Problem gefunden werden. Bei einer Binomialverteilung als Likelihood eignet sich eine Betaverteilung als a priori - Verteilung (wegen der Binomial-Terme ).

- .

Die Parameter der Betaverteilung werden am Ende der Herleitung des Posteriors anschaulich verständlich werden. Fasst man das Produkt aus Likelihood-Verteilung und Beta-Prior zusammen, so ergibt sich eine (neue) Betaverteilung als Posterior!

Somit ergibt sich aus dem Bayesianischen Ansatz, dass wir die a posteriori -Verteilung des Parameters als Beta-Verteilung ausdrücken können, deren Parameter wir direkt aus den Parametern der a priori - Verteilung und den gewonnenen Messdaten (Anzahl der Kopf-Würfe) gewinnen können. Diese a posteriori - Verteilung kann wieder als Prior für ein Update der Wahrscheinlichkeitsverteilung verwendet werden, wenn etwa durch weitere Münzwürfe mehr Daten zur Verfügung stehen. In der folgenden Abbildung werden die Posteriorverteilungen für simulierte Münzwurf-Daten für jeden Münzwurf neu geplottet. Aus der Grafik geht hervor, wie sich die Posterior-Verteilung dem Simulationsparameter µ=0.35 (repräsentiert durch den grünen Punkt) mit steigender Anzahl der Würfe immer weiter annähert, interessant ist hier insbesondere das Verhalten des Erwartungswerts der Posterior-Verteilung (blauer Punkt), da der Erwartungswert der Beta-Verteilung nicht notwendigerweise dem höchsten Punkt der Betaverteilung entspricht.

Da wir eine Wahrscheinlichkeitsverteilung über haben können wir - ganz im Baysianischen Sinne - abschätzen wie genau mit gegebenen Daten bestimmbar ist.

Wahl des Priors[Bearbeiten | Quelltext bearbeiten]

Die Wahl der a priori - Verteilung ist keineswegs beliebig. Im oberen Fall haben wir eine a priori - Verteilung, den konjugierten Prior, gewählt, welche mathematisch praktisch ist. Die Verteilung ist eine Verteilung, bei der jedes gleich Wahrscheinlich ist. Diese Betaverteilung entspricht also dem Fall, dass wir kein nennenswertes Vorwissen über haben. Nach wenigen Beobachtungen kann aus dem gleichförmigen Prior schon eine Wahrscheinlichkeitsverteilung werden, die die Lage von wesentlich genauer beschreibt, etwa .

Im Prior kann man jedoch auch direkt "Expertenwissen" unterbringen. Etwa kann man bei einer Münze davon ausgehen, dass sie in der Nähe von 50% liegt, und eher nicht in der Nähe von 100% oder von 0%. Mit diesem Wissen kann man etwa die Wahl eines Priors mit dem Erwartungswert 0.5 rechtfertigen. Diese Wahl wäre in einem anderen Fall, etwa der Verteilung von roten und schwarzen Kugeln in einer Urne vielleicht nicht angebracht, weil evtl. nicht bekannt ist, ob überhaupt beide Farben sich in einer solchen Urne befinden oder ob ein grundsätzliches Mischverhältnis bekannt ist.

Auch andere Prior-Verteilungen sind denkbar und können angesetzt werden. Teilweise wird dann jedoch die Bestimmung der Posteriorverteilung schwierig bzw. ist nur mit Algorithmen lösbar.

Konjugierte Prioren[Bearbeiten | Quelltext bearbeiten]

Konjugierte Prioren existieren für alle Mitglieder der Exponentialfamilie.

Beispiele[Bearbeiten | Quelltext bearbeiten]

Beispiel von Laplace[Bearbeiten | Quelltext bearbeiten]

Laplace hat das Theorem von Thomas Bayes erneut abgeleitet und eingesetzt, um die Masse des Saturn und anderer Planeten einzugrenzen:

- A: Masse von Saturn liegt in bestimmtem Intervall,

- B: Daten von Observatorien über gegenseitige Störungen von Jupiter und Saturn und

- C: die Masse des Saturns darf nicht so klein sein, dass er seine Ringe verliert, noch so groß, dass er das Sonnensystem zerstört.

| Laplace (1814) | 3512,0 |

| NASA (2004) | 3499,1 |

„Pour en donner quelques applications intéressantes, j’ai profité de l’immense travail que M. Bouvard vient de terminer sur les mouvemens de Jupiter et de Saturne, dont il a construit des tables très précises. Il a discuté avec le plus grand soin les oppositions et les quadratures de ces deux planètes, observées par Bradley et par les astronomes qui l’ont suivi jusqu’à ces dernières années ; il en a conclu les corrections des élémens de leur mouvement et leurs masses comparées à celle du Soleil, prise pour unité. Ses calculs lui donnent la masse de Saturne égale à la 3512e partie de celle du Soleil. En leur appliquant mes formules de probabilité, je trouve qu’il y a onze mille à parier contre un, que l’erreur de ce résultat n’est pas un centième de sa valeur, ou, ce qui revient à très peu près au même, qu’après un siècle de nouvelles observations ajoutées aux précédentes, et discutées de la même manière, le nouveau résultat ne différera pas d’un centième de celui de M. Bouvard.“

Übersetzung: „Um einige interessante Anwendungen davon zu nennen, habe ich von der gewaltigen Arbeit profitiert, die M. Bouvard gerade über die Bewegungen von Jupiter und Saturn beendet und von denen er sehr präzise Tabellen erstellt hat. Er hat mit größter Sorgfalt die Oppositionen und Quadraturen dieser beiden Planeten diskutiert, die von Bradley und den Astronomen, die ihn in den letzten Jahre begleitet haben, beobachtet wurden; er schloss auf die Korrekturen der Elemente ihrer Bewegung und ihrer Massen im Vergleich zur Sonne, die als Referenz verwendet wurde. Seinen Berechnungen zufolge beträgt die Saturnmasse den 3512ten Teil der Sonnenmasse. Meine Formeln der Wahrscheinlichkeitsrechnung auf diese angewandt, komme ich zu dem Schluss, dass die Chancen 11000 zu 1 stehen, dass der Fehler dieses Ergebnisses nicht ein Hundertstel seines Wertes ist, oder, was das Gleiche bedeutet, dass auch nach einem Jahrhundert mit neuen Beobachtungen, zusätzlich zu den bereits existierenden, das neue Ergebnis nicht mehr als ein Hundertstel von dem von M. Bouvard abweichen wird, sofern sie auf die gleiche Weise durchgeführt werden.“

Einzelnachweise[Bearbeiten | Quelltext bearbeiten]

- ↑ Christopher M. Bishop: Pattern Recognition And Machine Learning. 2. Auflage. Springer, New York 2006, ISBN 978-0387310732.

- ↑ R.T. Cox: "Probability, Frequency and Reasonable Expectation", Am. J. Phys. 14, 1 (1946); http://dx.doi.org/10.1119/1.1990764

- ↑ Pierre-Simon De Laplace: Essai philosophique sur les probabilités. Dover, 1840, S. 91–134 (französisch, Wikisource).

Literatur[Bearbeiten | Quelltext bearbeiten]

- Leonhard Held: Methoden der statistischen Inferenz. Likelihood und Bayes. Spektrum Akademischer Verlag, Heidelberg 2008, ISBN 978-3-8274-1939-2.

- Rudolf Koch: Einführung in die Bayes-Statistik. Springer, Berlin/Heidelberg 2000, ISBN 3-540-66670-2.

- Peter M. Lee: Bayesian Statistics. An Introduction. 4. Auflage. Wiley, New York 2012, ISBN 978-1-118-33257-3.

- David J.C. MacKay: Information Theory, Inference and Learning Algorithms. Cambridge University Press, Cambridge 2003, ISBN 978-0-521-64298-9.

- Christopher M. Bishop: Pattern Recognition And Machine Learning. 2. Auflage. Springer, New York 2006, ISBN 978-0-387-31073-2.