Adaptive Resonanztheorie

Adaptive Resonance Theory (ART) bedeutet übersetzt anpassungsfähige Resonanz-Theorie. ART ist ein Architekturkonzept für neuronale Netze und wurde von Stephen Grossberg und Gail A. Carpenter entwickelt.

Grundlegende Struktur[Bearbeiten | Quelltext bearbeiten]

Das einfache ART-System gehört zur Klasse der nicht überwacht lernenden Algorithmen.

Typischerweise besteht es aus einem Vergleichs-Feld F1 und einem Erkennungs-Feld F2, einem Wachsamkeits-Parameter P und einem Reset-Modul R. Neuronen in F1 repräsentieren Attribute, Neuronen in F2 Kategorien. Daher bestehen beide Felder meist aus einer unterschiedlichen Anzahl von Neuronen. F1 und F2 sind bidirektional voll vernetzt. Jede Verbindung wird mit einem spezifischen Gewicht bewertet. Diese Gewichte sind der Langzeit-Speicher von ART. Alle Gewichte von F1 nach F2 sind in einer Gewichtsmatrix W zusammengefasst, die anderen gehören zur Gewichtsmatrix Z. Der Wachsamkeits-Parameter hat beträchtlichen Einfluss auf das System: ein hoher Wert verursacht feingranulare Erinnerungen (viele, kleine Kategorien), ein niedriger Wert sorgt für mehr Abstraktion (weniger, gröbere Kategorien).

Klassifizierung[Bearbeiten | Quelltext bearbeiten]

Beim Klassifizieren wird an die F1-Neuronen ein Attribute-Vektor I angelegt. Dieser wird mit den Gewichten in W bewertet und an die F2-Neuronen weitergeleitet. Das F2-Neuron, welches das maximale Signal erhält, bestimmt die Kategorie, zu der I gehört. Die Ausgabe aller anderen F2-Neuronen wird auf Null gesetzt.

Das Ergebnis wird mit Z bewertet und an die F1-Schicht zurückgeleitet. Liegt der Unterschied zwischen I und dem zurückkommenden Signal innerhalb der von P festgelegten Grenze, befindet sich das System in Resonanz und die Gewichte können trainiert werden. Ansonsten wird per Reset-Signal das aktive F2-Neuron deaktiviert, bis ein neuer Eingabe-Vektor anliegt. Es folgt ein neuer Durchlauf, der zu einem anderen F2-Neuron (einer anderen Kategorie) führt. Somit werden während der Suche nach und nach solange Kategorien probiert, bis entweder eine Kategorie gefunden wurde, die ähnlich genug ist oder alle Kategorien verglichen wurden.

Sollte I in keine der gespeicherten Kategorien passen, so wird ein bisher ungenutztes F2-Neuron verwendet und die Gewichte zu diesem mit den Werten von I initialisiert. Ist kein freies F2-Neuron verfügbar (Speicherkapazität erschöpft), so kann das neue Muster nicht erlernt werden.

Im Zustand der Resonanz werden die Gewichte der ausgewählten Kategorie den Attributen von I angepasst. Daher hat das System seinen Namen: Es lernt im Zustand der Resonanz, indem es gespeicherte Kategorien an neue Fälle anpasst, sofern der neue Fall nicht zu sehr von der gespeicherten Kategorie abweicht.

Training[Bearbeiten | Quelltext bearbeiten]

Es gibt zwei verschiedene Arten, ART-Netze zu trainieren: langsam und schnell.

Langsames Lernen passiert dann, wenn eine zufriedenstellende Kategorie gefunden wurde (in Anlehnung an schwingende Systeme wird dieser Zustand Resonanz genannt). Die Gewichte dieser Kategorie werden mit Differentialgleichungen an die Attribute von I angepasst. Der Grad der Anpassung ist abhängig davon, wie lange I präsentiert wird.

Beim schnellen Lernen wird die Anpassung der Gewichte mithilfe algebraischer Gleichungen bestimmt.

Während schnelles Lernen effektiv und effizient für viele Anwendungen ist, ist langsames Lernen biologisch plausibler.

ART Typen[Bearbeiten | Quelltext bearbeiten]

ART 1[Bearbeiten | Quelltext bearbeiten]

ART 1[1][2][3] ist die einfachste und ursprüngliche Variante. ART-1 kann nur binäre Attribute verarbeiten.

ART 2[Bearbeiten | Quelltext bearbeiten]

ART 2[4] erweitert ART-1 und ermöglicht die Verarbeitung von kontinuierlichen Attributen.

ART 2-A[Bearbeiten | Quelltext bearbeiten]

ART 2-A[5] ist eine rationalisierte Form von ART-2 mit drastisch verbesserter Laufzeit und nur selten schlechteren Resultaten.

ART 3[Bearbeiten | Quelltext bearbeiten]

ART 3[6] basiert auf ART-2 und ahmt chemische Vorgänge biologischer neuronaler Netze nach.

Fuzzy ART[Bearbeiten | Quelltext bearbeiten]

Fuzzy ART[7] erweitert ART 1 um die Nutzung von Fuzzy-Logik. Dies ermöglicht graduelle Zuordnung zu verschiedenen Kategorien gleichzeitig. Durch komplementäres Kodieren der Attribute kann die Abwesenheit von Attributen verarbeitet werden, was unnötiges Wuchern von Kategorien reduziert.

Distributed ART[Bearbeiten | Quelltext bearbeiten]

Distributed ART[8]

ARTMAP[Bearbeiten | Quelltext bearbeiten]

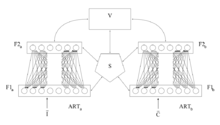

ARTMAP,[9] Wird auch Predictive ART (vorhersagendes ART) genannt. Dabei werden zwei ART-Module mit einem Verbindungsnetz V zu einem überwacht lernenden System kombiniert. Das Erste Modul verarbeitet den Attributvektor I und das zweite den Ergebnisvektor C. Das Steuerungssystem S steuert den Wachsamkeits-Parameter des Attribute-Systems in Abhängigkeit von den Ergebniskategorien. Somit können unterschiedlich grobe Kategorien der Attribute erzeugt werden.

Wird nur ein einfaches (überwacht lernendes) Klassifikations-System benötigt, so kann das zweite Modul vereinfacht werden.

Fuzzy ARTMAP[Bearbeiten | Quelltext bearbeiten]

Fuzzy ARTMAP[10] ist einfach ein ARTMAP aus zwei Fuzzy ART Modulen.

Distributed ARTMAP[Bearbeiten | Quelltext bearbeiten]

Distributed ARTMAP[11]

ARTMAP-IC[Bearbeiten | Quelltext bearbeiten]

ARTMAP-IC[12]

Default ARTMAP[Bearbeiten | Quelltext bearbeiten]

Default ARTMAP[13] ist eine Kombination aus Fuzzy ARTMAP und teilweise Distributed ARTMAP.

ARTMAP Übersicht[Bearbeiten | Quelltext bearbeiten]

| Trainieren | Klassifizieren | Instanzenzählung | |

|---|---|---|---|

| Fuzzy | WTA | WTA | Nein |

| Default | WTA | verteilt | Nein |

| IC | WTA | verteilt | Ja |

| Distributed | verteilt | verteilt | Ja |

WTA = „the winner takes it all“ Nur das F2-Neuron mit der größten Ausgabe ist aktiv, die Ausgabe aller anderen ist Null.

Verteilt = Alle F2-Neuronen sind aktiv.

Instanzenzählung = Die Ausgaben der F2-Neuronen werden durch die F3-Neuronen gewichtet. Kategorien, die in den Trainingsfällen häufiger vorkamen, bekommen eine größere Bewertung.

Literatur[Bearbeiten | Quelltext bearbeiten]

- Philip D. Wasserman: Neural computing: theory and practice. Van Nostrand Reinhold, New York 1989, ISBN 0-442-20743-3.

Weblinks[Bearbeiten | Quelltext bearbeiten]

- cns-web.bu.edu – Offizielle Webseite von Stephen Grossberg

- profusion.bu.edu (Memento vom 7. Mai 2006 im Internet Archive) – Beispielcode in den Programmiersprachen C und Java

- cs.uni-muenster.de/... – Erklärung von ART und ARTMAP samt Beispielen

- informatik.uni-ulm.de (PDF; 103 kB) – Eine deutschsprachige Einführung zu ART

Einzelnachweise[Bearbeiten | Quelltext bearbeiten]

- ↑ G.A. Carpenter, S. Grossberg: Adaptive Resonance Theory. (Memento des vom 19. Mai 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 59 kB), In M.A. Arbib (Ed.): The Handbook of Brain Theory and Neural Networks. Second Edition. MIT Press, Cambridge MA 2003, S. 87–90.

- ↑ S. Grossberg: Competitive learning: From interactive activation to adaptive resonance. (Memento des vom 7. September 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 8,1 MB) In: Cognitive Science (Zeitschrift), 1987, 11, S. 23–63

- ↑ G.A. Carpenter, S. Grossberg: A massively parallel architecture for a self-organizing neural pattern recognition machine. (Memento des vom 6. September 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 8,9 MB) In: Computer Vision, Graphics And Image Processing (Zeitschrift), 1987, S. 54–115.

- ↑ G.A. Carpenter, S. Grossberg: ART 2: Self-organization of stable category recognition codes for analog input patterns. (Memento des vom 4. September 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 3,8 MB) In: Applied Optics, 26(23), (1987), S. 4919–4930

- ↑ G.A. Carpenter, S. Grossberg, D.B. Rosen: ART 2-A: An adaptive resonance algorithm for rapid category learning and recognition. (Memento des vom 19. Mai 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 1,4 MB) In: Neural Networks (Zeitschrift), 1991, 4, S. 493–504

- ↑ G.A. Carpenter, S. Grossberg: ART 3: Hierarchical search using chemical transmitters in self-organizing pattern recognition architectures. (Memento des vom 6. September 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 2,0 MB) In: Neural Networks (Zeitschrift), 1990, 3, S. 129–152

- ↑ G.A. Carpenter, S. Grossberg, D.B. Rosen: Fuzzy ART: Fast stable learning and categorization of analog patterns by an adaptive resonance system. (Memento des vom 19. Mai 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 1,2 MB) In: Neural Networks (Zeitschrift), 1991, 4, S. 759–771

- ↑ G.A. Carpenter: Distributed Learning, Recognition and Prediction by ART and ARTMAP Neural Networks. (Memento des vom 22. März 2005 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 1,6 MB) In: Neural Networks (Zeitschrift), vol. 10, 1997, no. 8, S. 1473–1494 (englisch); abgerufen am 12. Mai 2015.

- ↑ G.A. Carpenter, S. Grossberg, J.H. Reynolds: ARTMAP: Supervised real-time learning and classification of nonstationary data by a self-organizing neural network (Memento des vom 19. Mai 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 2,2 MB) In: Neural Networks (Zeitschrift), 1991, 4, S. 565–588

- ↑ G.A. Carpenter, S. Grossberg, N. Markuzon, J.H. Reynolds, D.B. Rosen: Fuzzy ARTMAP: A neural network architecture for incremental supervised learning of analog multidimensional maps. (Memento des vom 19. Mai 2006 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (PDF; 1,6 MB) In: IEEE Transactions on Neural Networks, 1992, 3, S. 698–713

- ↑ Gail A. Carpenter, Boriana L. Milenova, Benjamin W. Noeske: Distributed ARTMAP: a neural network for fast distributed supervised learning. (Memento vom 1. September 2006 im Internet Archive) (PDF; 1,4 MB) In: Neural Networks (Zeitschrift), 1998, 11, S. 793–813 (englisch); abgerufen am 12. Mai 2015.

- ↑ Gail A. Carpenter, Natalya Markuzon: ARTMAP-IC and medical diagnosis: Instance counting and inconsistent cases. (Memento vom 4. September 2006 im Internet Archive) (PDF; 227 kB) In: Neural Networks (Zeitschrift), 1998, 11, S. 323–336 (englisch); abgerufen am 12. Mai 2015.

- ↑ Gail A. Carpenter: Default ARTMAP. (Memento vom 3. September 2006 im Internet Archive) (PDF; 1,8 MB) CAS-CNS Technical Report TR-2003-008, 2003 (englisch); abgerufen am 12. Mai 2015.