„Optische Notenerkennung“ – Versionsunterschied

| [gesichtete Version] | [ungesichtete Version] |

K OMR wird nicht nur für gedruckte Noten verwendet. |

Vollständige Überarbeitung des Artikels - Analog zu der englischen Version |

||

| Zeile 1: | Zeile 1: | ||

'''Optische Notenerkennung''' (engl.: ''Optical Music Recognition,'' Abkürzung: ''OMR'') ist das Forschungsfeld, dass das computergestützte Lesen von Musiknotation in Dokumenten untersucht.<ref>{{Literatur|Autor=Alexander Pacha|Jahr=2019|Titel=Self-Learning Optical Music Recognition (Doktorarbeit)|Hrsg=TU Wien, Austria|Online=[https://alexanderpacha.files.wordpress.com/2019/07/dissertation-self-learning-optical-music-recognition-alexander-pacha.pdf Direkter Download]|DOI=10.13140/RG.2.2.18467.40484}}</ref> Das Ziel ist es, dem Computer das Lesen und Interpretieren von [[Musiknoten]] beizubringen, damit dieser eine maschinenlesbare Version erzeugen kann. Sobald diese Version erstellt wurde, kann sie in verschiedene Formate exportiert werden um die Musik wiederzugeben (z.B. mittels [[MIDI]]) oder erneut zu [[Notensatz|setzen]] (z.B. mittels [[MusicXML]]). |

|||

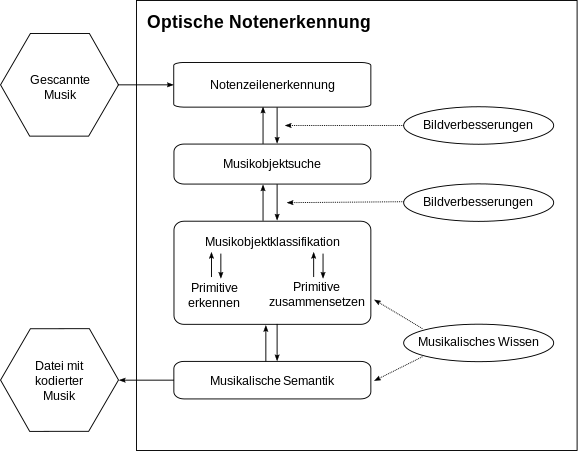

[[Datei:Optische Notenerkennung.png|miniatur|500px|Schematischer Aufbau des Erkennungsprozesses bei Notenscansoftware]] |

|||

'''Optische Notenerkennung''' (engl.: ''Optical Music Recognition,'' Abkürzung: ''OMR'') ist eine Form der [[Texterkennung|optischen Zeichenerkennung]], bei der gedruckte oder auch handschriftliche [[Note (Musik)|Noten]] [[Digitalisierung|digitalisiert]] werden, um sie nachträglich mit einem [[Notensatzprogramm]] zu bearbeiten oder abzuspielen ([[Musical Instrument Digital Interface|MIDI]]). |

|||

In der Vergangenheit wurde OMR auch als Form der [[Texterkennung|optischen Zeichenerkennung]] angesehen und ''Music OCR'' genannt. Aufgrund von zahlreichen signifikanten Unterschieden, sollten diese Begriffe jedoch nicht vermischt und der Begriff ''Music OCR'' vermieden werden. |

|||

== Geschichte == |

== Geschichte == |

||

[[File:FirstPublishedDigitalScanOfMusic-Prerau1971.png|thumb|Der erste publizierte digitale Scan von Musiknoten von David Prerau in 1971]] |

|||

Ende der 1960er Jahre wurde zum ersten Mal am [[Massachusetts Institute of Technology|MIT]] und anderen Forschungseinrichtungen die Erkennung von gedruckten Notensätzen erforscht<ref>{{Internetquelle | autor=Dennis Howard Pruslin | url=http://www.jstor.org/pss/832471 | sprache=englisch | titel=Automatic Recognition of Sheet Music | datum=1966 | zugriff=2011-05-04}}</ref>. Es wurde versucht, Notenlinien zu erfassen, um die darauf liegenden Symbole zu erkennen und zu übersetzen. Das erste kommerzielle Notenerkennungsprogramm ''Midiscan'' wurde 1991 von der Firma Musitek veröffentlicht (Das Programm wurde später in ''SmartScore'' umbenannt). |

|||

Forschung im Bereich der optischen Notenerkennung begann in den späten 1960ern am [[Massachusetts Institute of Technology|MIT]] als die ersten [[Scanner|Scanner]] für Forschungszwecke leistbar wurden.<ref>{{YouTube|id=Mr7simdf0eA|title=Fujinaga, Ichiro (2018). Die Geschichte von OMR (Englisch)|z=2019-07-30}}</ref><ref>{{Literatur|Autor=Dennis Howard Pruslin |Jahr=1966|Titel=Automatic Recognition of Sheet Music (Doktorarbeit)|Hrsg=Massachusetts Institute of Technology, Cambridge, Massachusetts, USA}}</ref><ref name=prerau1971>{{cite conference |last=Prerau |first=David S. |date=1971 |title=Computer pattern recognition of printed music |conference=Fall Joint Computer Conference|pages=153–162}}</ref> Da der [[Arbeitsspeicher]] der verwendeten Computer ein limitierender Faktor war, beschränkten sich die ersten Versuche auf wenige Takte (siehe den ersten publizierten Scan). In 1984 entwickelte eine japanische Forschungsgruppe von der [[Waseda-Universität|Waseda Universität]] einen spezialisierten Roboter namens WABOT (WAseda roBOT), welcher die gedruckten Noten vor sich lesen und einen Sänger auf einer elektrischen Orgel begleiten konnte.<ref>{{Internetquelle | url=http://www.humanoid.waseda.ac.jp/booklet/kato_2.html | titel=WABOT – WAseda roBOT | hrsg=Waseda University Humanoid | zugriff=2019-07-30}}</ref><ref>{{Internetquelle | url=https://robots.ieee.org/robots/wabot/ | titel=Wabot’s entry in the IEEE collection of Robots | hrsg=IEEE | zugriff=2019-07-30}}</ref> |

|||

Entscheidene Forschungsfortschritte in der Anfangszeit wurden von Ichiro Fujinaga, Nicholas Carter, Kia Ng, David Bainbridge und Tim Bell erbracht, die eine Reihe von Ansätzen entwickelt haben, die heute noch in einigen Systemen verwendet werden. |

|||

Durch die Verfügbarkeit von kostengünstigen [[Scanner (Datenerfassung)|Scannern]], konnten mehr Forscher sich der optischen Notenerkennung widmen und die Anzahl der Projekte nahm zu. In 1991 wurde die erste kommerzielle Lösung MIDISCAN (inzwischen [[Finale_(Software)#Erweiterungen|SmartScore]]) von der Musitek Corporation entwickelt. |

|||

Mit der Verbreitung von [[Smartphone|Smartphones]], die mit ausreichend guten Kameras und genügend Rechenkapazität ausgestattet sind, wurden einige mobile Lösungen möglich, bei denen mit dem Smartphone aufgenommenen Fotos direkt am Gerät verarbeitet werden. |

|||

== Beziehung zu anderen Forschungsgebieten == |

|||

Die optische Notenerkennung steht in Beziehung zu einigen anderen Forschungsgebieten, insbesondere zum [[Maschinelles Sehen|maschinellem Sehen]], [[Dokumentenanalyse]] und [[Music Information Retrieval]]. Aus Sicht der musikalischen Praxis kann OMR als Eingabemethode von Noten in den Computer gesehen werden, wodurch das Bearbeiten und Transkribieren von Musiknoten sowie das Komponieren erleichtert werden kann. In Bibliotheken kann OMR genutzt werden um Notenarchive durchsuchbar zu machen<ref>{{cite conference |last=Laplante |first=Audrey |last2=Fujinaga |first2=Ichiro |date=2016 |title=Digitizing Musical Scores: Challenges and Opportunities for Libraries |conference=3rd International Workshop on Digital Libraries for Musicology|pages=45–48}}</ref> und musikwissenschaftliche Studien können dank OMR kostengünstig im großen Rahmen durchgeführt werden.<ref>{{cite conference |last=Hajič |first=Jan jr. |last2=Kolárová |first2=Marta |first3=Alexander |last3=Pacha |first4=Jorge |last4=Calvo-Zaragoza |date=2018 |title=How Current Optical Music Recognition Systems Are Becoming Useful for Digital Libraries |conference=5th International Conference on Digital Libraries for Musicology|pages=57–61|location=Paris, France}}</ref> |

|||

[[File:Beziehung_zwischen_Optischer_Notenerkennung_zu_anderen_Forschungsgebieten.svg|thumb|Beziehung von optischer Notenerkennung zu anderen Forschungsgebieten]] |

|||

=== OMR vs. OCR === |

|||

Optische Notenerkennung wird häufig mit [[Texterkennung|optischer Zeichenerkennung]] (engl. Optical Character Recognition, kurz OCR) verglichen. Obwohl es viele Gemeinsamkeiten gibt, ist die Bezeichnung “Music OCR” aufgrund von entscheidenden Unterschieden irreführend. Der erste Unterschied ist, dass Musiknotation ein konfiguratives Schreibsystem ist. Das bedeutet, dass die Semantik nicht von den verwendeten Symbolen abhängig ist (z.B. Notenköpfe, Notenhälse, Fähnchen), sondern von der Art wie diese auf den Notenzeilen platziert werden. Zwei-dimensionale Beziehungen und der Kontext sind entscheidend um die korrekte Interpretation von Noten zu bestimmen. Im Gegensatz dazu, ist bei Text üblicherweise nur die Textlinie entscheidend --- geringfügige Abweichungen davon verändern nicht die Bedeutung des Textes. Er kann also entlang der Textlinie als eindimensionaler Fluss von Informationen angesehen werden. |

|||

Der zweite große Unterschied liegt an den Erwartungen. Ein OCR System endet üblicherweise bei der Erkennung von Buchstaben und Wörtern, hingegen von einem OMR System wird erwartet, dass es auch die Semantik rekonstruiert (z.B. aus einem gefüllten Notenkopf und einem angehängten Notenhals darauf schließt, dass es sich um eine Note mit einer bestimmten Dauer handelt). Die graphischen Konzepte (Position, Art des Symbols) müssen also in musikalische Konzepte (Tonhöhe, Notendauer, ...) durch Anwenden der Regeln von Musiknotation übersetzt werden. In der Texterkennung gibt es kein passendes Äquivalent für diesen Schritt. Folgender Vergleich kann hilfreich sein: Die Anforderungen an ein OMR System sind ähnlich komplex wie wenn man von einem OCR System erwartet, dass es aus dem [[Screenshot]] einer Website den [[HTML]] [[Quellcode]] rekonstruiert. |

|||

Der dritte große Unterschied ist der Zeichensatz. Während es auch in anderen Schriftsystemen wie der [[Chinesische_Schrift|chinesischen Schrift]] ausgesprochen komplexe Symbole und umfangreiche Zeichensätze gibt, ist der Zeichensatz von Musiknotation dadurch geprägt, dass die Symbole enorme Größenunterschiede haben können - von kleinen Punkten bis hin zu Klammern, die eine ganze Seite umspannen. Manche Symbole haben sogar eine nahezu unbeschränkte Darstellungsart wie Bindebögen, die lediglich als mehr oder weniger glatte Kurven definiert werden, die beliebig unterbrochen werden können. |

|||

Heute gibt es eine Vielzahl von Notenscanprogrammen. Sie sind vielfach in [[Notensatzprogramm]]e per Schnittstelle eingebunden und können aus diesen direkt aufgerufen werden. |

|||

Die [[Vollversion]]en müssen zwar meist getrennt erworben werden, jedoch beinhaltet Notensoftware bei Kauf oft schon eine Light-Version des entsprechenden Programms zur optischen Notenerkennung. |

|||

== Verfahren == |

== Verfahren == |

||

Die Erkennung von Noten erfolgt üblicherweise in mehreren Teilschritten, die mittels spezieller Algorithmen aus dem Bereich der [[Mustererkennung]] gelöst werden. |

|||

Im Gegensatz zur optischen Erkennung von Text, in der die Buchstaben der Reihe nach erfasst werden können, müssen bei Notensätzen parallel fortlaufende Elemente und ungebundene Dynamiksymbole erkannt werden. Daher ist die Erkennung der räumlichen Anordnung von Noten, der Dynamik, der Fingersätze, der Betonungen und anderer zusätzlicher Notierungselemente ein wichtiger Punkt in der optischen Notenerkennung. |

|||

Eine Reihe von konkurrierender Ansätze existiert, wobei die meisten eine Art Pipeline vorsehen, wo jeder Schritt eine spezielle Funktion erfüllt, z.B. das Erkennen und Entfernen von Notenlinien, bevor der nächste Schritt ausgeführt wird. Ein häufiges Problem dieser Methoden ist dass sich Fehler durch das System fortpflanzen und vermehren. Zum Beispiel führt das Übersehen von Notenzeilen in den ersten Schritten dazu, dass die folgenden Schritte diesen Bereich des Bildes vermutlich ignorieren werden, wodurch die Ausgabe unvollständig ist. |

|||

Eingelesen wird entweder direkt über einen an den PC angeschlossenen Scanner oder von einer Bilddatei ([[Windows Bitmap|BMP]] und [[Tagged Image File Format|TIFF]]). Manche Programme sind auch in der Lage, [[PDF]]-Dateien mit Noten einzulesen. Ausgabeformate zum Austausch sind in der Regel [[MusicXML]], [[NIFF]] oder [[MIDI]]. |

|||

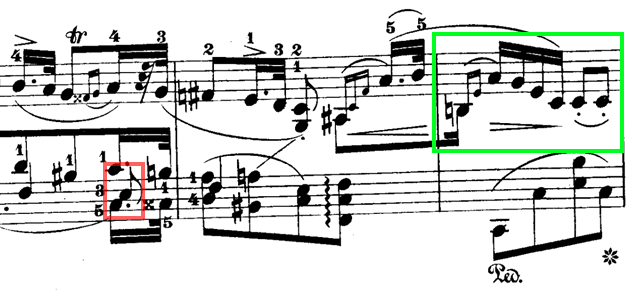

Die optische Notenerkennung wird häufig unterschätzt, da es sich um ein scheinbar einfaches Problem handelt: Arbeitet man mit einem perfekten Scan von gedruckten Noten, kann die visuelle Erkennung mit einer Reihe von relativ einfachen Algorithmen wie [[Zentralprojektion|Projektionen]] oder [[Pattern Matching]] gelöst werden. Der Prozess wird jedoch signifikant schwieriger, wenn der Scan eine niedrige Qualität aufweist oder wenn handschriftliche Notizen erkannt werden sollen - eine Herausforderung an der fast alle Systeme scheitern. Selbst bei einer perfekten visuellen Erkennung, stellt die Rekonstruktion der musikalischen Semantik aufgrund von Mehrdeutigkeiten und häufigen Verletzungen der Regeln der Musiknotation (siehe Chopin’s Nocturne unten) noch immer eine große Herausforderung dar. Donald Byrd und Jakob Simonsen behaupten, dass OMR deshalb so schwierig ist, weil moderne Musiknotation enorm komplex ist.<ref>{{cite journal |last=Byrd |first=Donald |last2=Simonsen |first2=Jakob Grue |date=2015 |title=Towards a Standard Testbed for Optical Music Recognition: Definitions, Metrics, and Page Images |journal=Journal of New Music Research |volume=44 |issue=3 |pages=169–195 |doi=10.1080/09298215.2015.1045424}}</ref> |

|||

Die Rate der Erkennung ist begrenzt, je nach Qualität der eingescannten Vorlage ist mit Auftreten von Fehlern zu rechnen, die dann manuell korrigiert werden müssen. Moderne optische Notenerkennungsprogramme haben jedoch bei einem gewöhnlichen, gedruckten Notensatz eine hohe Genauigkeit von bis zu 99 Prozent<!-- der folgende Artikel der "c't Deutschland" ist kostenpflichtig, es gibt jedoch auch eine kostenlose Übersicht dessen in Englisch, siehe zweiter Beleg.--><ref>{{Internetquelle | autor=Christoph Laue | url=https://shop.heise.de/katalog/tonsetzer | sprache=deutsch | titel=Notenscan-Software für Windows und Mac OS | datum=2001 | zugriff=2011-05-07}}</ref><ref>{{Internetquelle | autor=Graham Jones (Visiv Ltd) | url=http://www.visiv.co.uk/quote.htm | sprache=englisch | titel=User comments, reviews, etc. | datum=2006 | zugriff=2011-05-07}}</ref>. Die wohl häufigsten Fehler ergeben sich aus [[Artefakt (Fotografie)|Artefakten]] in der [[Scanner (Datenerfassung)|eingescannten]] Bilddatei oder kleinen, punktartige Schmutzpartikeln auf der Scanvorlage, welche das Notenerkennungsprogramm als [[Staccato]]-Punkte oder [[Punktierung (Musik)|Punktierung]] einer Note interpretiert. |

|||

[[File:Excerpt from Nocturne Op. 15, no. 2 by Frédéric Chopin.png|Exzerpt aus Frédéric Chopin’s Nocturne Op. 15, no. 2, welches die Beispiele für Herausforderungen in der optischen Notenerkennung darstellt]] |

|||

Scans von handgeschriebenen Noten werden – wenn überhaupt – nur stark fehlerbehaftet erkannt. |

|||

Donald Byrd hat eine Reihe von interessanten Beispielen auf seiner Website gesammelt<ref>{{Internetquelle | url=http://homes.sice.indiana.edu/donbyrd/InterestingMusicNotation.html | titel=Gallery of Interesting Music Notation | autor=Donald Byrd | zugriff=2019-07-30}}</ref> sowie einige extreme Beispiele, welche demonstrieren wie weit die Regeln der Musiknotation gebogen werden können<ref>{{Internetquelle | url=http://homes.sice.indiana.edu/donbyrd/CMNExtremes.htm | titel=Extremes of Conventional Music Notation | autor=Donald Byrd | zugriff=2019-07-30}}</ref>. |

|||

== Liste und Vergleich von Notenscansoftware == |

|||

Marktführend sind in Deutschland die kommerziellen Programme ''PhotoScore'', ''SmartScore'', ''[[capella (Software)|Capella-Scan]]'' und ''SharpEye''. Mit ''Audiveris'' existiert auch ein in [[Java (Programmiersprache)|Java]] geschriebenes [[Open Source|Open-Source]]-Programm (für Windows und Linux).<ref>{{internetquelle|url=http://audiveris.kenai.com/ |titel=audiveris: Audiveris Home Page|zugriff=2011-02-07|zitat=Audiveris is a complete music scanner going all the way from the scanned music sheet input to the MusicXML output. […]|sprache=en}}</ref> |

|||

== Ausgaben von OMR Systemen == |

|||

=== Vergleich marktbeherrschender Notenscanprogramme === |

|||

OMR System erzeugen typischerweise eine Version der Noten, die akustisch wiedergegeben werden kann (Wiedergabefähigkeit, engl. Replayability). Die häufigste Art wie so eine Version erzeugt werden kann ist über die Generierung einer [[MIDI]] Datei, die mithilfe von einem [[Synthesizer]] in eine Audiodatei umgewandelt werden kann. MIDI Dateien sind jedoch eingeschränkt in der Information die sich speichern können. So können diese beispielsweise keinerlei Information über den visuellen Notensatz (wie die Noten konkret angeordnet waren) speichern. |

|||

{| class="wikitable" style="font-size: 90%; text-align: center; width: auto;" |

|||

|- |

|||

! rowspan="2" | Name |

|||

! rowspan="2" | Jüngster Release |

|||

! rowspan="2" | Entwickler |

|||

! rowspan="2" | Vertrieb und Übersetzung |

|||

! colspan="2" | Unterstützte Formate |

|||

! rowspan="2" | Preis ([[Euro|€]]) |

|||

! rowspan="2" | Betriebssystem |

|||

! rowspan="2" | kooperierendes [[Notensatzprogramm]] |

|||

! rowspan="2" | Besonderheiten/Anmerkungen |

|||

|- |

|||

! Input |

|||

! Output |

|||

|- |

|||

! PhotoScore |

|||

| 7.0 |

|||

| Neuratron |

|||

| Sibelius Österreich |

|||

| Bmp, TIFF, PDF, Scanner |

|||

| MIDI, MusicXML, NIFF |

|||

| ~240€ |

|||

| Windows, Mac OS |

|||

| [[Sibelius (Software)|Sibelius]] |

|||

| liest auch handgeschriebene Noten |

|||

|- |

|||

! SmartScore |

|||

| 10.3.3 |

|||

| Musitek |

|||

| Klemm Music Technology |

|||

| TIFF, PDF, Scanner |

|||

| Finale, MusicXML, MIDI, NIFF |

|||

| ~330€ |

|||

| Windows, Mac OS |

|||

| [[Finale (Software)|Finale]] |

|||

| |

|||

|- |

|||

! SharpEye |

|||

| 2.6.8 |

|||

| Visiv |

|||

| Columbus Soft |

|||

| Bmp, TIFF, Scanner |

|||

| MIDI, MusicXML, NIFF |

|||

| ~160€ |

|||

| Windows |

|||

| [[PriMus]] |

|||

| auch über Lugert Verlag vertrieben |

|||

|- |

|||

! Capella-Scan |

|||

| 7.0.0 |

|||

| WHC |

|||

| WHC |

|||

| Bmp, Gif, PDF, Png, PS, TIFF, Scanner |

|||

| Capella, MIDI, MusicXML |

|||

| ~190€ |

|||

| Windows |

|||

| [[capella (Software)|Capella]] |

|||

| verspricht, auch Texte in Fraktur erkennen zu können ([[ABBYY]] OCR engine) |

|||

|} |

|||

Ist das Ziel der Software die Rekonstruktion einer Version die von Menschen gut gelesen werden kann (Druckbarkeit, engl. Reprintability), muss die vollständige Information wiederhergestellt werden, inklusive präziser Layoutinformationen des Notensatzes. Geeignete Formate für diese Aufgaben sind [[Music Encoding Initiative|MEI]] und [[MusicXML]]. |

|||

=== Weitere Notenscanprogramme === |

|||

* Audiveris Music Scanner (Quellcode, Freie Software) |

|||

Neben den beiden genannten Anwendungen, kann es auch interessant sein lediglich Metainformation über ein Bild zu extrahieren oder dieses nur Durchsuchbar zu machen. Für diese beiden Fälle kann ein geringeres Verständnis der Noten ausreichend sein. |

|||

* Forte 9 Premium |

|||

* Gamera (Programmbibliothek, Freie Software) |

|||

== Generelles Modell (2001) == |

|||

* MIDI-Connections Scan |

|||

Im Jahr 2001 veröffentlichen David Bainbridge und Tim Bell einen Überblick über die Forschungsaktivitäten die bis dahin stattgefunden haben. Sie extrahierten daraus ein generelles Modell für OMR, welches als Vorlage für zahlreiche System diente, welche nach 2001 entwickelt wurden.<ref name=Bainbridge2001/> Das Problem wird in vier Schritte unterteilt, die sich hauptsächlich mit der visuellen Erkennung befassen. Die Autoren erkannten, dass die Beschreibung wie die musikalischen Semantik rekonstruiert wird, häufig in wissenschaftlichen Arbeiten weggelassen wird, da diese Operationen abhängig davon sind welches Ausgabeformat gewählt wird. |

|||

* Vivaldi Scan (Vertrieb eingestellt) |

|||

* Music Publisher 9 – Scanning Edition (untergegangen<ref>{{Internetquelle |url=https://lauriso.com/ |titel=Music Publisher |zugriff=2019-03-01 |sprache=en-GB}}</ref>) |

|||

[[File:OMR Architektur nach Bainbridge.svg|Reproduktion des generellen Aufbaus von System zur optischen Notenerkennung, vorgeschlagen von David Bainbridge und Tim Bell im Jahr 2001.]] |

|||

* OMeR (Optical Music easy Reader) (Shareware) |

|||

* PDFtoMusic Pro Music Scanner |

|||

== Verfeinertes Modell (2012) == |

|||

* Scoremaker (japanisch) |

|||

Im Jahr 2012 verfassten Ana Rebelo et al. eine weitere Untersuchung über die verwendeten Techniken in optischer Notenerkennung.<ref>{{cite journal |last1=Rebelo |first1=Ana |last2=Fujinaga |first2=Ichiro |last3=Paszkiewicz |first3=Filipe |last4=Marcal |first4=Andre R.S. |last5=Guedes |first5=Carlos |last6=Cardoso |first6=Jamie dos Santos |date=2012 |title=Optical music recognition: state-of-the-art and open issues |journal=International Journal of Multimedia Information Retrieval |volume=1 |issue=3 |pages=173–190 |doi=10.1007/s13735-012-0004-6 |url=https://link.springer.com/content/pdf/10.1007%2Fs13735-012-0004-6.pdf}}</ref> Die gefundenen Arbeiten wurden kategorisiert und ein verfeinertes Modell wurde vorgeschlagen mit vier Hauptbestandteilen: Vorverarbeitung, Musiksymbolerkennung, Rekonstruktion der Musiknotation und Konstruktion der finalen Repräsentation. Dieses Modell wurde der de-facto Standard für OMR und wir noch heute so verwendet (wenn auch manchmal mit leicht abweichenden Namen). Für jeden dieser vier Blöcke gibt die Arbeit einen Überblick über die verwendeten Techniken um dieses Problem zu lösen. Die Arbeit ist die am häufigsten zitierte Publikation mit Stand 2019. |

|||

* ScoreScan (32-Bit-Programm für Windows 95/98) |

|||

[[File:OMR Architektur nach Rebelo.svg|Reproduktion des generellen Aufbaus von System zur optischen Notenerkennung, vorgeschlagen von Ana Rebelo et al. im Jahr 2012.]] |

|||

== Deep Learning (seit 2016) == |

|||

Mit dem Aufkommen von [[Deep Learning]] haben viele Probleme aus dem Bereich des maschinellem Sehen einen Wandel gesehen. An die Stelle von händisch erstellen Heuristiken und dem Entwickeln von geeigneten Merkmalen, tritt das maschinelle Lernen. Die Notenzeilenverarbeitung,<ref>{{cite conference |last=Castellanos |first=Fancisco J. |last2=Calvo-Zaragoza |first2=Jorge |first3=Gabriel |last3=Vigliensoni |first4=Ichiro |last4=Fujinaga |date=2018 |title=Document Analysis of Music Score Images with Selectional Auto-Encoders |conference=19th International Society for Music Information Retrieval Conference|pages=256–263|location=Paris, France |url=http://ismir2018.ircam.fr/doc/pdfs/93_Paper.pdf}}</ref> die Musiksymbolerkennung <ref>{{cite conference |last=Tuggener |first=Lukas |last2=Elezi |first2=Ismail |first3=Jürgen |last3=Schmidhuber |first4=Thilo |last4=Stadelmann |date=2018 |title=Deep Watershed Detector for Music Object Recognition |conference=19th International Society for Music Information Retrieval Conference|pages=271–278|location=Paris, France |url=http://ismir2018.ircam.fr/doc/pdfs/225_Paper.pdf}}</ref><ref>{{cite conference |last=Hajič |first=Jan jr. |last2=Dorfer |first2=Matthias |first3=Gerhard |last3=Widmer |first4=Pavel |last4=Pecina |date=2018 |title=Towards Full-Pipeline Handwritten OMR with Musical Symbol Detection by U-Nets |conference=19th International Society for Music Information Retrieval Conference|pages=225–232|location=Paris, France |url=http://ismir2018.ircam.fr/doc/pdfs/175_Paper.pdf}}</ref><ref>{{cite journal |last1=Pacha |first1=Alexander |last2=Hajič |first2=Jan jr. |last3=Calvo-Zaragoza |first3=Jorge |date=2018 |title=A Baseline for General Music Object Detection with Deep Learning |journal=Applied Sciences |volume=8 |issue=9 |pages=1488–1508 |doi=10.3390/app8091488 |url=https://www.mdpi.com/2076-3417/8/9/1488}}</ref><ref>{{cite conference |last=Pacha |first=Alexander |last2=Choi |first2=Kwon-Young |last3=Coüasnon |first3=Bertrand |last4=Ricquebourg |first4=Yann |last5=Zanibbi |first5=Richard |last6=Eidenberger |first6=Horst |date=2018 |title=Handwritten Music Object Detection: Open Issues and Baseline Results |conference=13th International Workshop on Document Analysis Systems |pages=163–168 |doi=10.1109/DAS.2018.51}}</ref> sowie die Rekonstruktion der Musiknotation<ref>{{cite conference |last=Pacha |first=Alexander |last2=Calvo-Zaragoza |first2=Jorge |last3=Hajič |first3=Jan jr. |date=2019 |title=Learning Notation Graph Construction for Full-Pipeline Optical Music Recognition |conference=20th International Society for Music Information Retrieval Conference (in press)}}</ref> haben signifikante Fortschritte durch Deep Learning erfahren. |

|||

Teilweise entstanden sogar völlig neue Methoden, die versuchen OMR direkt durch Verwendung von Sequenz-zu-Sequenz Modellen zu lösen. Diese Verfahren wandeln ein Bild von Musiknoten direkt in eine vereinfachte Sequenz von erkannten Noten um.<ref>{{cite conference |last=van der Wel |first=Eelco |last2=Ullrich |first2=Karen |date=2017 |title=Optical Music Recognition with Convolutional Sequence-to-Sequence Models |conference=18th International Society for Music Information Retrieval Conference |location=Suzhou, China |url=https://archives.ismir.net/ismir2017/paper/000069.pdf}}</ref><ref>{{cite journal |last1=Calvo-Zaragoza |first1=Jorge |last2=Rizo |first2=David |date=2018 |title=End-to-End Neural Optical Music Recognition of Monophonic Scores |journal=Applied Sciences |volume=8 |issue=4 |doi=10.3390/app8040606 |url=https://www.mdpi.com/2076-3417/8/4/606}}</ref><ref>{{cite conference |last=Baró |first=Arnau |last2=Riba |first2=Pau |last3=Calvo-Zaragoza |first3=Jorge |last4=Fornés |first4=Alicia |date=2017 |title=Optical Music Recognition by Recurrent Neural Networks |conference=14th International Conference on Document Analysis and Recognition |pages=25–26 |doi=10.1109/ICDAR.2017.260}}</ref> |

|||

== Bedeutsame wissenschaftliche Projekte == |

|||

=== Wettbewerb zur Notenzeilenerkennung === |

|||

Für Systeme die vor 2016 entwickelt wurden, stellte die Erkennung und das Entfernen der Notenlinien eine signifikante Herausforderung dar. Ein wissenschaftlicher Wettbewerb wurde organisiert, um den Stand der Technik für dieses Problem zu verbessern.<ref>{{cite journal |last1=Fornés |first1=Alicia |last2=Dutta |first2=Anjan |last3=Gordo |first3=Albert |last4=Lladós |first4=Josep |date=2013 |title=The 2012 Music Scores Competitions: Staff Removal and Writer Identification |journal=Graphics Recognition. New Trends and Challenges |publisher=Springer |pages=173–186 |doi=10.1007/978-3-642-36824-0_17}}</ref> Nachdem bereits sehr gute Ergebnisse erzielt werden konnten und viele moderne Ansätze keine explizite Notenzeilenerkennung mehr benötigen, wurde dieser Wettbewerb nicht weitergeführt. |

|||

Ein wichtiger Beitrag dieses Wettbewerbes die Entwicklung und Veröffentlichung des frei verfügbare CVC-MUSCIMA Datensatzes. Dieser besteht aus 1000 hochqualitative Bilder handgeschriebener Noten. 50 verschiedene Musiker transkribierten jeweils eine Seite aus 20 musikalischen Werken unterschiedlichster Art. Eine Weiterentwicklung von CVC-MUSCIMA ist der MUSCIMA++ Datensatz, welcher für 140 ausgewählte Seiten noch weitere detaillierte Annotation enthält. |

|||

=== SIMSSA === |

|||

Das Single Interface for Music Score Searching and Analysis (SIMSSA) Projekt<ref>{{Internetquelle | url=https://simssa.ca/ | titel=Website des SIMSSA Projektes | hrsg=McGill University | zugriff=2019-07-30}}</ref> ist das vermutlich größte Forschungsprojekt, welches die optische Notenerkennung untersucht. Das Ziel ist die effiziente Bereitstellung von großen Mengen an durchsuchbaren Noten in elektronischer Form. Einige Unterprojekte wurden bereits erfolgreich abgeschlossen, zum Beispiel das Liber Usualis Projekt<ref>{{Internetquelle | url=http://liber.simssa.ca/ | titel=The Liber Usualis project website | hrsg=McGill University | zugriff=2019-07-30}}</ref> und das Cantus Ultimus Projekt.<ref>{{Internetquelle | url=https://cantus.simssa.ca/ | titel=The Cantus Ultimus project website | hrsg=McGill University | zugriff=2019-07-30}}</ref> |

|||

=== TROMPA === |

|||

Towards Richer Online Music Public-domain Archives (TROMPA) ist ein weiteres internationales Forschungsprojekt mit dem Ziel gemeinfreie, digitale Musikressourcen zugänglicher zu machen.<ref>{{Internetquelle | url=https://trompamusic.eu/ | titel=The TROMPA project website | hrsg=Trompa Konsortium | zugriff=2019-07-30}}</ref> |

|||

== Datensätze == |

|||

Die Entwicklung von OMR Systemen wird maßgeblich davon beeinflusst, welche Datensätze zur Entwicklung herangezogen werden. Ein ausreichend großer und diverser Datensatz trägt dazu bei dass das entwickelte System robust in verschiedenen Situationen arbeiten kann und mit unterschiedlichsten Eingaben zurecht kommt. Da Musiknoten durch das Urheberrecht geschützt sind, kann es kompliziert sein, einen entsprechenden Datensatz zu erstellen und zu veröffentlichen. Dennoch gibt es eine Reihe an Datensätzen, die das OMR Dataset Projekt<ref>{{Internetquelle | url=https://apacha.github.io/OMR-Datasets/ | titel=The OMR Datasets Project (Github Repository) | autor=Pacha, Alexander | zugriff=2019-07-30}}</ref> gesammelt und zusammengefasst hat. Die bedeutendsten sind CVC-MUSCIMA,<ref>{{cite journal |last1=Fornés |first1=Alicia |last2=Dutta |first2=Anjan |last3=Gordo |first3=Albert |last4=Lladós |first4=Josep |date=2012 |title=CVC-MUSCIMA: A Ground-truth of Handwritten Music Score Images for Writer Identification and Staff Removal |journal=International Journal on Document Analysis and Recognition |volume=15 |issue=3 |pages=243–251 |doi=10.1007/s10032-011-0168-2}}</ref> MUSCIMA++,<ref>{{cite conference |last=Hajič |first=Jan jr. |last2=Pecina |first2=Pavel |date=2017 |title=The MUSCIMA++ Dataset for Handwritten Optical Music Recognition |conference=14th International Conference on Document Analysis and Recognition |pages=39–46 |doi=10.1109/ICDAR.2017.16 |location=Kyoto, Japan}}</ref> DeepScores,<ref>{{cite conference |last=Tuggener |first=Lukas |last2=Elezi |first2=Ismail |last3=Schmidhuber |first3=Jürgen |last4=Pelillo |first4=Marcello |last5=Stadelmann |first5=Thilo |date=2018 |title=DeepScores – A Dataset for Segmentation, Detection and Classification of Tiny Objects |conference=24th International Conference on Pattern Recognition |doi=10.21256/zhaw-4255 |location=Beijing, China}}</ref> PrIMuS,<ref>{{cite conference |last=Calvo-Zaragoza |first=Jorge |last2=Rizo |first2=David |date=2018 |title=Camera-PrIMuS: Neural End-to-End Optical Music Recognition on Realistic Monophonic Scores |conference=19th International Society for Music Information Retrieval Conference |pages=248–255 |url=http://ismir2018.ircam.fr/doc/pdfs/33_Paper.pdf |location=Paris, France}}</ref> HOMUS,<ref>{{cite conference |last=Calvo-Zaragoza |first=Jorge |last2=Oncina |first2=Jose |date=2014 |title=Recognition of Pen-Based Music Notation: The HOMUS Dataset |conference=22nd International Conference on Pattern Recognition |pages=3038–3043 |doi=10.1109/ICPR.2014.524}}</ref> und der SEILS Datensatz,<ref>{{cite conference |last=Parada-Cabaleiro |first=Emilia |last2=Batliner |first2=Anton |last3=Baird |first3=Alice |last4=Schuller |first4=Björn |date=2017 |title=The SEILS Dataset: Symbolically Encoded Scores in Modern-Early Notation for Computational Musicology |conference=18th International Society for Music Information Retrieval Conference |pages=575–581 |url=https://ismir2017.smcnus.org/wp-content/uploads/2017/10/14_Paper.pdf |location=Suzhou, China}}</ref> sowie die Universal Music Symbol Sammlung.<ref>{{cite conference |last=Pacha |first=Alexander |last2=Eidenberger |first2=Horst |date=2017 |title=Towards a Universal Music Symbol Classifier |conference=14th International Conference on Document Analysis and Recognition |pages=35–36 |doi=10.1109/ICDAR.2017.265 |location=Kyoto, Japan}}</ref> |

|||

== Software == |

|||

=== Akademische und quelloffene Software === |

|||

Eine große Anzahl an wissenschaftlichen OMR Projekten wurden durchgeführt, allerdings erreichten nur wenige einen derart ausgereiften Zustand, dass diese veröffentlicht und an Anwender verteilt wurden. Diese Systeme sind: |

|||

* Aruspix<ref>[http://www.aruspix.net/ Aruspix]</ref> |

|||

* Audiveris<ref>[https://github.com/audiveris Audiveris]</ref> |

|||

* CANTOR<ref>[https://www.cs.waikato.ac.nz/~davidb/home.html CANTOR]</ref> |

|||

* Gamera<ref>[https://gamera.informatik.hsnr.de/addons/musicstaves/ Gamera]</ref> |

|||

* DMOS<ref>{{cite conference |last=Coüasnon |first=Bertrand |date=2001 |title=DMOS: a generic document recognition method, application to an automatic generator of musical scores, mathematical formulae and table structures recognition systems |conference=Sixth International Conference on Document Analysis and Recognition |pages=215-220 |doi=10.1109/ICDAR.2001.953786}}</ref> |

|||

* OpenOMR<ref>[https://sourceforge.net/projects/openomr/files/ OpenOMR]</ref> |

|||

* Rodan<ref>[https://github.com/DDMAL/Rodan/wiki Rodan]</ref> |

|||

=== Kommerzielle Software === |

|||

Die meisten kommerziellen Desktopanwendungen die in den letzten 20 Jahren veröffentlicht wurden sind aufgrund von mangelndem kommerziellen Erfolg wieder vom Markt verschwunden. Nur ein paar wenige Anbieter entwickelt, warten und verkaufen derzeit noch OMR Produkte. |

|||

Manche dieser Produkte behaupten Erkennungsraten von nahezu 100% zu haben <ref>[https://www.capella-software.com/de/index.cfm/produkte/capella-scan/grenzen-der-erkennung/ Informationen über die Genauigkeit von capella-scan]</ref><ref name=photoscore/>, aber nachdem keinerlei Informationen darüber angegeben sind, wie diese Zahlen berechnet wurden und auf welchen Daten sie basieren, sind diese nicht verifizierbar und machen es nahezu unmöglich verschiedene Produkte miteinander zu vergleichen. |

|||

Neben den Desktopanwendungen wurde auch eine Reihe von mobilen Anwendungen entwickelt. Nachdem die Bewertungen dieser allerdings durchwachsen war, wurden diese Projekte wieder eingestellt (oder haben zumindest keine Aktualisierungen seit 2017 mehr erhalten).<ref>[https://play.google.com/store/apps/details?id=uk.co.dolphin_com.camrascore PlayScore Pro]</ref><ref>[https://play.google.com/store/apps/details?id=com.gearup.iseenotes iSeeNotes]</ref><ref>[https://play.google.com/store/apps/details?id=com.neuratron.notatemenow NotateMe Now]</ref> |

|||

* [[Capella (Software)#Sonstiges|capella-scan]]<ref name="capella-scan">[http://www.capella-software.com/capscan.htm Info capella-scan]</ref> |

|||

* ForteScan Light von Fortenotation<ref>[http://www.fortenotation.com/en/products/sheet-music-scanning/forte-scan-light/ FORTE Scan Light] {{Webarchiv|url=http://www.fortenotation.com/en/products/sheet-music-scanning/forte-scan-light|wayback=20130922202552 |datum=2013-09-22 }}</ref> now Scan Score<ref>[https://scan-score.com Scan Score]</ref> |

|||

* MIDI-Connections Scan von MIDI-Connections<ref>[http://www.midi-connections.com/Product_Scan.htm MIDI-Connections SCAN 2.0] {{Webarchiv|url=http://www.midi-connections.com/Product_Scan.htm | wayback=20131220015015 |datum=2013-12-20 }}</ref> |

|||

* MP Scan von Braeburn<ref>[http://www.braeburn.co.uk/mpsinfo.htm Music Publisher Scanning Edition] {{Webarchiv|url=http://www.braeburn.co.uk/mpsinfo.htm |wayback=20130413045521 |datum=2013-04-13 }}</ref> Uses SharpEye SDK. |

|||

* NoteScan gebündelt mit Nightingale<ref>[http://www.ngale.com NoteScan]</ref> |

|||

* OMeR (Optical Music easy Reader) Add-on for Harmony Assistant and Melody Assistant: Myriad Software<ref>[http://www.myriad-online.com/en/products/omer.htm OMeR]</ref> (ShareWare) |

|||

* PDFtoMusic<ref>[http://www.myriad-online.com/en/products/pdftomusicpro.htm PDFtoMusic]</ref> |

|||

* PhotoScore von Neuratron.<ref name=photoscore>[http://www.neuratron.com/photoscore.htm PhotoScore Ultimate 7]</ref> The Light version of PhotoScore is used in [[Sibelius (Software)|Sibelius]]. PhotoScore uses the SharpEye SDK. |

|||

* Scorscan von npcImaging.<ref>[http://www.npcimaging.com/scscinfo/scscinfo.html ScorScan]</ref> Based on SightReader(?) |

|||

* SharpEye von Visiv<ref>[http://www.visiv.co.uk/ SharpEye]</ref> |

|||

** VivaldiScan (genauso wie SharpEye)<ref>[http://www.vivaldistudio.com/ENG/VivaldiScan.asp VivaldiScan] {{Webarchiv|url=http://www.vivaldistudio.com/Eng/VivaldiScan.asp|wayback=20051224185409 |datum=2005-12-24 }}</ref> |

|||

* [[Finale_(Software)#Erweiterungen|SmartScore]] von Musitek.<ref>[http://www.musitek.com/smartscre.html SmartScore] {{Webarchiv|url=http://www.musitek.com/smartscre.html|wayback=20120417140717 |datum=2012-04-17 }}</ref> Früher als "MIDISCAN" verkauft. (SmartScore Lite wird in [[Finale (Software)|Finale]] verwendet). |

|||

== Siehe auch == |

== Siehe auch == |

||

* [[Mustererkennung]] |

* [[Mustererkennung]] |

||

* [[Musteranalyse]] |

* [[Musteranalyse]] |

||

* [[Texterkennung]] befasst sich mit der Erkennung von geschriebenem Text, welches dazu verwendet werden kann um Dokumente durchsuchbar zu machen. OMR kann eine ähnliche Funktion in Music Information Retrieval übernehmen, allerdings muss ein vollständiges OMR System auch den Text der in Musiknoten enthalten ist erkennen, weshalb OCR als ein Teilproblem von OMR angesehen werden kann.<ref name=Bainbridge2001>{{cite journal|last=Bainbridge|first=David|last2=Bell|first2=Tim|year=2001|title=The challenge of optical music recognition|url=https://www.researchgate.net/publication/220147775|journal=Computers and the Humanities|volume=35|issue=2|pages=95–121|doi=10.1023/A:1002485918032}}</ref> |

|||

* [[Texterkennung]] |

|||

* [[Music Information Retrieval]] |

* [[Music Information Retrieval]] |

||

* [[Notensatzprogramm]] |

* [[Notensatzprogramm]] |

||

== References == |

|||

<references /> |

|||

== Weblinks == |

== Weblinks == |

||

* [https://omr-research.net/ Website über Forschungsaktivitäten im Bereich der optischen Notenerkennung] |

|||

* [https://github.com/omr-research Github page for open-source projects on optical music recognition] |

|||

* [https://omr-research.github.io/ Bibliography on OMR-Research] |

|||

* [https://www.youtube.com/playlist?list=PL1jvwDVNwQke-04UxzlzY4FM33bo1CGS0 Recording of the ISMIR 2018 tutorial "Optical Music Recognition for Dummies"] |

|||

* [http://www.music-notation.info/en/compmus/omr.html Optical Music Recognition (OMR): Programs and scientific papers] |

|||

* [http://www.informatics.indiana.edu/donbyrd/OMRSystemsTable.html OMR (Optical Music Recognition) Systems]: Ausführlicher Überblick über OMR Systeme (Zuletzt aktualisiert am: 30 January 2007). |

|||

* [http://www.music-notation.info/de/compmus/omr.html Deutsche Notenscan-Übersichtsseite von Gerd Castan] |

* [http://www.music-notation.info/de/compmus/omr.html Deutsche Notenscan-Übersichtsseite von Gerd Castan] |

||

* [http://journal.code4lib.org/articles/84 Bringing Sheet Music to Life: My Experiences with OMR (Andrew H. Bullen)] |

* [http://journal.code4lib.org/articles/84 Bringing Sheet Music to Life: My Experiences with OMR (Andrew H. Bullen)] |

||

* [http://www.informatics.indiana.edu/donbyrd/OMRSystemsTable.html OMR (Optical Music Recognition) Systems (Donald Byrd)] |

|||

* [http://www.cs.waikato.ac.nz/~davidb/omr/ Overview by David Bainbridge about surveys of Optical Music Recognition (OMR) work] |

|||

* [http://www.music.mcgill.ca/~ich/research/omr/omrbib.html Optical Music Recognition Bibliography] |

|||

* [http://www.informatics.indiana.edu/donbyrd/N560Site-Fall06/B+B_ChallengeOfOMR.pdf The Challenge of Optical Music Recognition (David Bainbridge and Tim Bell)] (PDF; 198 kB) |

|||

* [http://ismir2008.ismir.net/papers/ISMIR2008_247.pdf GAMERA versus ARUSPIX (Laurent Pugin, Jason Hockman, John Ashley Burgoyne e.a.)] (PDF; 441 kB) |

|||

== Einzelnachweise == |

|||

<references /> |

|||

[[Kategorie:Optische Zeichenerkennung]] |

[[Kategorie:Optische Zeichenerkennung]] |

||

Version vom 30. Juli 2019, 14:11 Uhr

Optische Notenerkennung (engl.: Optical Music Recognition, Abkürzung: OMR) ist das Forschungsfeld, dass das computergestützte Lesen von Musiknotation in Dokumenten untersucht.[1] Das Ziel ist es, dem Computer das Lesen und Interpretieren von Musiknoten beizubringen, damit dieser eine maschinenlesbare Version erzeugen kann. Sobald diese Version erstellt wurde, kann sie in verschiedene Formate exportiert werden um die Musik wiederzugeben (z.B. mittels MIDI) oder erneut zu setzen (z.B. mittels MusicXML).

In der Vergangenheit wurde OMR auch als Form der optischen Zeichenerkennung angesehen und Music OCR genannt. Aufgrund von zahlreichen signifikanten Unterschieden, sollten diese Begriffe jedoch nicht vermischt und der Begriff Music OCR vermieden werden.

Geschichte

Forschung im Bereich der optischen Notenerkennung begann in den späten 1960ern am MIT als die ersten Scanner für Forschungszwecke leistbar wurden.[2][3][4] Da der Arbeitsspeicher der verwendeten Computer ein limitierender Faktor war, beschränkten sich die ersten Versuche auf wenige Takte (siehe den ersten publizierten Scan). In 1984 entwickelte eine japanische Forschungsgruppe von der Waseda Universität einen spezialisierten Roboter namens WABOT (WAseda roBOT), welcher die gedruckten Noten vor sich lesen und einen Sänger auf einer elektrischen Orgel begleiten konnte.[5][6]

Entscheidene Forschungsfortschritte in der Anfangszeit wurden von Ichiro Fujinaga, Nicholas Carter, Kia Ng, David Bainbridge und Tim Bell erbracht, die eine Reihe von Ansätzen entwickelt haben, die heute noch in einigen Systemen verwendet werden.

Durch die Verfügbarkeit von kostengünstigen Scannern, konnten mehr Forscher sich der optischen Notenerkennung widmen und die Anzahl der Projekte nahm zu. In 1991 wurde die erste kommerzielle Lösung MIDISCAN (inzwischen SmartScore) von der Musitek Corporation entwickelt.

Mit der Verbreitung von Smartphones, die mit ausreichend guten Kameras und genügend Rechenkapazität ausgestattet sind, wurden einige mobile Lösungen möglich, bei denen mit dem Smartphone aufgenommenen Fotos direkt am Gerät verarbeitet werden.

Beziehung zu anderen Forschungsgebieten

Die optische Notenerkennung steht in Beziehung zu einigen anderen Forschungsgebieten, insbesondere zum maschinellem Sehen, Dokumentenanalyse und Music Information Retrieval. Aus Sicht der musikalischen Praxis kann OMR als Eingabemethode von Noten in den Computer gesehen werden, wodurch das Bearbeiten und Transkribieren von Musiknoten sowie das Komponieren erleichtert werden kann. In Bibliotheken kann OMR genutzt werden um Notenarchive durchsuchbar zu machen[7] und musikwissenschaftliche Studien können dank OMR kostengünstig im großen Rahmen durchgeführt werden.[8]

OMR vs. OCR

Optische Notenerkennung wird häufig mit optischer Zeichenerkennung (engl. Optical Character Recognition, kurz OCR) verglichen. Obwohl es viele Gemeinsamkeiten gibt, ist die Bezeichnung “Music OCR” aufgrund von entscheidenden Unterschieden irreführend. Der erste Unterschied ist, dass Musiknotation ein konfiguratives Schreibsystem ist. Das bedeutet, dass die Semantik nicht von den verwendeten Symbolen abhängig ist (z.B. Notenköpfe, Notenhälse, Fähnchen), sondern von der Art wie diese auf den Notenzeilen platziert werden. Zwei-dimensionale Beziehungen und der Kontext sind entscheidend um die korrekte Interpretation von Noten zu bestimmen. Im Gegensatz dazu, ist bei Text üblicherweise nur die Textlinie entscheidend --- geringfügige Abweichungen davon verändern nicht die Bedeutung des Textes. Er kann also entlang der Textlinie als eindimensionaler Fluss von Informationen angesehen werden.

Der zweite große Unterschied liegt an den Erwartungen. Ein OCR System endet üblicherweise bei der Erkennung von Buchstaben und Wörtern, hingegen von einem OMR System wird erwartet, dass es auch die Semantik rekonstruiert (z.B. aus einem gefüllten Notenkopf und einem angehängten Notenhals darauf schließt, dass es sich um eine Note mit einer bestimmten Dauer handelt). Die graphischen Konzepte (Position, Art des Symbols) müssen also in musikalische Konzepte (Tonhöhe, Notendauer, ...) durch Anwenden der Regeln von Musiknotation übersetzt werden. In der Texterkennung gibt es kein passendes Äquivalent für diesen Schritt. Folgender Vergleich kann hilfreich sein: Die Anforderungen an ein OMR System sind ähnlich komplex wie wenn man von einem OCR System erwartet, dass es aus dem Screenshot einer Website den HTML Quellcode rekonstruiert.

Der dritte große Unterschied ist der Zeichensatz. Während es auch in anderen Schriftsystemen wie der chinesischen Schrift ausgesprochen komplexe Symbole und umfangreiche Zeichensätze gibt, ist der Zeichensatz von Musiknotation dadurch geprägt, dass die Symbole enorme Größenunterschiede haben können - von kleinen Punkten bis hin zu Klammern, die eine ganze Seite umspannen. Manche Symbole haben sogar eine nahezu unbeschränkte Darstellungsart wie Bindebögen, die lediglich als mehr oder weniger glatte Kurven definiert werden, die beliebig unterbrochen werden können.

Verfahren

Die Erkennung von Noten erfolgt üblicherweise in mehreren Teilschritten, die mittels spezieller Algorithmen aus dem Bereich der Mustererkennung gelöst werden.

Eine Reihe von konkurrierender Ansätze existiert, wobei die meisten eine Art Pipeline vorsehen, wo jeder Schritt eine spezielle Funktion erfüllt, z.B. das Erkennen und Entfernen von Notenlinien, bevor der nächste Schritt ausgeführt wird. Ein häufiges Problem dieser Methoden ist dass sich Fehler durch das System fortpflanzen und vermehren. Zum Beispiel führt das Übersehen von Notenzeilen in den ersten Schritten dazu, dass die folgenden Schritte diesen Bereich des Bildes vermutlich ignorieren werden, wodurch die Ausgabe unvollständig ist.

Die optische Notenerkennung wird häufig unterschätzt, da es sich um ein scheinbar einfaches Problem handelt: Arbeitet man mit einem perfekten Scan von gedruckten Noten, kann die visuelle Erkennung mit einer Reihe von relativ einfachen Algorithmen wie Projektionen oder Pattern Matching gelöst werden. Der Prozess wird jedoch signifikant schwieriger, wenn der Scan eine niedrige Qualität aufweist oder wenn handschriftliche Notizen erkannt werden sollen - eine Herausforderung an der fast alle Systeme scheitern. Selbst bei einer perfekten visuellen Erkennung, stellt die Rekonstruktion der musikalischen Semantik aufgrund von Mehrdeutigkeiten und häufigen Verletzungen der Regeln der Musiknotation (siehe Chopin’s Nocturne unten) noch immer eine große Herausforderung dar. Donald Byrd und Jakob Simonsen behaupten, dass OMR deshalb so schwierig ist, weil moderne Musiknotation enorm komplex ist.[9]

Donald Byrd hat eine Reihe von interessanten Beispielen auf seiner Website gesammelt[10] sowie einige extreme Beispiele, welche demonstrieren wie weit die Regeln der Musiknotation gebogen werden können[11].

Ausgaben von OMR Systemen

OMR System erzeugen typischerweise eine Version der Noten, die akustisch wiedergegeben werden kann (Wiedergabefähigkeit, engl. Replayability). Die häufigste Art wie so eine Version erzeugt werden kann ist über die Generierung einer MIDI Datei, die mithilfe von einem Synthesizer in eine Audiodatei umgewandelt werden kann. MIDI Dateien sind jedoch eingeschränkt in der Information die sich speichern können. So können diese beispielsweise keinerlei Information über den visuellen Notensatz (wie die Noten konkret angeordnet waren) speichern.

Ist das Ziel der Software die Rekonstruktion einer Version die von Menschen gut gelesen werden kann (Druckbarkeit, engl. Reprintability), muss die vollständige Information wiederhergestellt werden, inklusive präziser Layoutinformationen des Notensatzes. Geeignete Formate für diese Aufgaben sind MEI und MusicXML.

Neben den beiden genannten Anwendungen, kann es auch interessant sein lediglich Metainformation über ein Bild zu extrahieren oder dieses nur Durchsuchbar zu machen. Für diese beiden Fälle kann ein geringeres Verständnis der Noten ausreichend sein.

Generelles Modell (2001)

Im Jahr 2001 veröffentlichen David Bainbridge und Tim Bell einen Überblick über die Forschungsaktivitäten die bis dahin stattgefunden haben. Sie extrahierten daraus ein generelles Modell für OMR, welches als Vorlage für zahlreiche System diente, welche nach 2001 entwickelt wurden.[12] Das Problem wird in vier Schritte unterteilt, die sich hauptsächlich mit der visuellen Erkennung befassen. Die Autoren erkannten, dass die Beschreibung wie die musikalischen Semantik rekonstruiert wird, häufig in wissenschaftlichen Arbeiten weggelassen wird, da diese Operationen abhängig davon sind welches Ausgabeformat gewählt wird.

Verfeinertes Modell (2012)

Im Jahr 2012 verfassten Ana Rebelo et al. eine weitere Untersuchung über die verwendeten Techniken in optischer Notenerkennung.[13] Die gefundenen Arbeiten wurden kategorisiert und ein verfeinertes Modell wurde vorgeschlagen mit vier Hauptbestandteilen: Vorverarbeitung, Musiksymbolerkennung, Rekonstruktion der Musiknotation und Konstruktion der finalen Repräsentation. Dieses Modell wurde der de-facto Standard für OMR und wir noch heute so verwendet (wenn auch manchmal mit leicht abweichenden Namen). Für jeden dieser vier Blöcke gibt die Arbeit einen Überblick über die verwendeten Techniken um dieses Problem zu lösen. Die Arbeit ist die am häufigsten zitierte Publikation mit Stand 2019.

Deep Learning (seit 2016)

Mit dem Aufkommen von Deep Learning haben viele Probleme aus dem Bereich des maschinellem Sehen einen Wandel gesehen. An die Stelle von händisch erstellen Heuristiken und dem Entwickeln von geeigneten Merkmalen, tritt das maschinelle Lernen. Die Notenzeilenverarbeitung,[14] die Musiksymbolerkennung [15][16][17][18] sowie die Rekonstruktion der Musiknotation[19] haben signifikante Fortschritte durch Deep Learning erfahren.

Teilweise entstanden sogar völlig neue Methoden, die versuchen OMR direkt durch Verwendung von Sequenz-zu-Sequenz Modellen zu lösen. Diese Verfahren wandeln ein Bild von Musiknoten direkt in eine vereinfachte Sequenz von erkannten Noten um.[20][21][22]

Bedeutsame wissenschaftliche Projekte

Wettbewerb zur Notenzeilenerkennung

Für Systeme die vor 2016 entwickelt wurden, stellte die Erkennung und das Entfernen der Notenlinien eine signifikante Herausforderung dar. Ein wissenschaftlicher Wettbewerb wurde organisiert, um den Stand der Technik für dieses Problem zu verbessern.[23] Nachdem bereits sehr gute Ergebnisse erzielt werden konnten und viele moderne Ansätze keine explizite Notenzeilenerkennung mehr benötigen, wurde dieser Wettbewerb nicht weitergeführt.

Ein wichtiger Beitrag dieses Wettbewerbes die Entwicklung und Veröffentlichung des frei verfügbare CVC-MUSCIMA Datensatzes. Dieser besteht aus 1000 hochqualitative Bilder handgeschriebener Noten. 50 verschiedene Musiker transkribierten jeweils eine Seite aus 20 musikalischen Werken unterschiedlichster Art. Eine Weiterentwicklung von CVC-MUSCIMA ist der MUSCIMA++ Datensatz, welcher für 140 ausgewählte Seiten noch weitere detaillierte Annotation enthält.

SIMSSA

Das Single Interface for Music Score Searching and Analysis (SIMSSA) Projekt[24] ist das vermutlich größte Forschungsprojekt, welches die optische Notenerkennung untersucht. Das Ziel ist die effiziente Bereitstellung von großen Mengen an durchsuchbaren Noten in elektronischer Form. Einige Unterprojekte wurden bereits erfolgreich abgeschlossen, zum Beispiel das Liber Usualis Projekt[25] und das Cantus Ultimus Projekt.[26]

TROMPA

Towards Richer Online Music Public-domain Archives (TROMPA) ist ein weiteres internationales Forschungsprojekt mit dem Ziel gemeinfreie, digitale Musikressourcen zugänglicher zu machen.[27]

Datensätze

Die Entwicklung von OMR Systemen wird maßgeblich davon beeinflusst, welche Datensätze zur Entwicklung herangezogen werden. Ein ausreichend großer und diverser Datensatz trägt dazu bei dass das entwickelte System robust in verschiedenen Situationen arbeiten kann und mit unterschiedlichsten Eingaben zurecht kommt. Da Musiknoten durch das Urheberrecht geschützt sind, kann es kompliziert sein, einen entsprechenden Datensatz zu erstellen und zu veröffentlichen. Dennoch gibt es eine Reihe an Datensätzen, die das OMR Dataset Projekt[28] gesammelt und zusammengefasst hat. Die bedeutendsten sind CVC-MUSCIMA,[29] MUSCIMA++,[30] DeepScores,[31] PrIMuS,[32] HOMUS,[33] und der SEILS Datensatz,[34] sowie die Universal Music Symbol Sammlung.[35]

Software

Akademische und quelloffene Software

Eine große Anzahl an wissenschaftlichen OMR Projekten wurden durchgeführt, allerdings erreichten nur wenige einen derart ausgereiften Zustand, dass diese veröffentlicht und an Anwender verteilt wurden. Diese Systeme sind:

Kommerzielle Software

Die meisten kommerziellen Desktopanwendungen die in den letzten 20 Jahren veröffentlicht wurden sind aufgrund von mangelndem kommerziellen Erfolg wieder vom Markt verschwunden. Nur ein paar wenige Anbieter entwickelt, warten und verkaufen derzeit noch OMR Produkte. Manche dieser Produkte behaupten Erkennungsraten von nahezu 100% zu haben [43][44], aber nachdem keinerlei Informationen darüber angegeben sind, wie diese Zahlen berechnet wurden und auf welchen Daten sie basieren, sind diese nicht verifizierbar und machen es nahezu unmöglich verschiedene Produkte miteinander zu vergleichen. Neben den Desktopanwendungen wurde auch eine Reihe von mobilen Anwendungen entwickelt. Nachdem die Bewertungen dieser allerdings durchwachsen war, wurden diese Projekte wieder eingestellt (oder haben zumindest keine Aktualisierungen seit 2017 mehr erhalten).[45][46][47]

- capella-scan[48]

- ForteScan Light von Fortenotation[49] now Scan Score[50]

- MIDI-Connections Scan von MIDI-Connections[51]

- MP Scan von Braeburn[52] Uses SharpEye SDK.

- NoteScan gebündelt mit Nightingale[53]

- OMeR (Optical Music easy Reader) Add-on for Harmony Assistant and Melody Assistant: Myriad Software[54] (ShareWare)

- PDFtoMusic[55]

- PhotoScore von Neuratron.[44] The Light version of PhotoScore is used in Sibelius. PhotoScore uses the SharpEye SDK.

- Scorscan von npcImaging.[56] Based on SightReader(?)

- SharpEye von Visiv[57]

- VivaldiScan (genauso wie SharpEye)[58]

- SmartScore von Musitek.[59] Früher als "MIDISCAN" verkauft. (SmartScore Lite wird in Finale verwendet).

Siehe auch

- Mustererkennung

- Musteranalyse

- Texterkennung befasst sich mit der Erkennung von geschriebenem Text, welches dazu verwendet werden kann um Dokumente durchsuchbar zu machen. OMR kann eine ähnliche Funktion in Music Information Retrieval übernehmen, allerdings muss ein vollständiges OMR System auch den Text der in Musiknoten enthalten ist erkennen, weshalb OCR als ein Teilproblem von OMR angesehen werden kann.[12]

- Music Information Retrieval

- Notensatzprogramm

References

- ↑ Alexander Pacha: Self-Learning Optical Music Recognition (Doktorarbeit). Hrsg.: TU Wien, Austria. 2019, doi:10.13140/RG.2.2.18467.40484 (Direkter Download [PDF]).

- ↑ Fujinaga, Ichiro (2018). Die Geschichte von OMR (Englisch) auf YouTube, abgerufen am 30. Juli 2019.

- ↑ Dennis Howard Pruslin: Automatic Recognition of Sheet Music (Doktorarbeit). Hrsg.: Massachusetts Institute of Technology, Cambridge, Massachusetts, USA. 1966.

- ↑ David S. Prerau: Computer pattern recognition of printed music. Fall Joint Computer Conference. 1971, S. 153–162.

- ↑ WABOT – WAseda roBOT. Waseda University Humanoid, abgerufen am 30. Juli 2019.

- ↑ Wabot’s entry in the IEEE collection of Robots. IEEE, abgerufen am 30. Juli 2019.

- ↑ Audrey Laplante, Ichiro Fujinaga, Fujinaga: Digitizing Musical Scores: Challenges and Opportunities for Libraries. 3rd International Workshop on Digital Libraries for Musicology. 2016, S. 45–48.

- ↑ Jan jr. Hajič, Marta Kolárová, Alexander Kolárová, Jorge Calvo-Zaragoza: How Current Optical Music Recognition Systems Are Becoming Useful for Digital Libraries. 5th International Conference on Digital Libraries for Musicology. Paris, France 2018, S. 57–61.

- ↑ Donald Byrd, Jakob Grue Simonsen: Towards a Standard Testbed for Optical Music Recognition: Definitions, Metrics, and Page Images. In: Journal of New Music Research. 44. Jahrgang, Nr. 3, 2015, S. 169–195, doi:10.1080/09298215.2015.1045424.

- ↑ Donald Byrd: Gallery of Interesting Music Notation. Abgerufen am 30. Juli 2019.

- ↑ Donald Byrd: Extremes of Conventional Music Notation. Abgerufen am 30. Juli 2019.

- ↑ a b David Bainbridge, Tim Bell: The challenge of optical music recognition. In: Computers and the Humanities. 35. Jahrgang, Nr. 2, 2001, S. 95–121, doi:10.1023/A:1002485918032 (researchgate.net).

- ↑ Ana Rebelo, Ichiro Fujinaga, Filipe Paszkiewicz, Andre R.S. Marcal, Carlos Guedes, Jamie dos Santos Cardoso: Optical music recognition: state-of-the-art and open issues. In: International Journal of Multimedia Information Retrieval. 1. Jahrgang, Nr. 3, 2012, S. 173–190, doi:10.1007/s13735-012-0004-6 (springer.com [PDF]).

- ↑ Fancisco J. Castellanos, Jorge Calvo-Zaragoza, Gabriel Calvo-Zaragoza, Ichiro Fujinaga: Document Analysis of Music Score Images with Selectional Auto-Encoders. 19th International Society for Music Information Retrieval Conference. Paris, France 2018, S. 256–263 (ircam.fr [PDF]).

- ↑ Lukas Tuggener, Ismail Elezi, Jürgen Elezi, Thilo Stadelmann: Deep Watershed Detector for Music Object Recognition. 19th International Society for Music Information Retrieval Conference. Paris, France 2018, S. 271–278 (ircam.fr [PDF]).

- ↑ Jan jr. Hajič, Matthias Dorfer, Gerhard Dorfer, Pavel Pecina: Towards Full-Pipeline Handwritten OMR with Musical Symbol Detection by U-Nets. 19th International Society for Music Information Retrieval Conference. Paris, France 2018, S. 225–232 (ircam.fr [PDF]).

- ↑ Alexander Pacha, Jan jr. Hajič, Jorge Calvo-Zaragoza: A Baseline for General Music Object Detection with Deep Learning. In: Applied Sciences. 8. Jahrgang, Nr. 9, 2018, S. 1488–1508, doi:10.3390/app8091488 (mdpi.com).

- ↑ Alexander Pacha, Kwon-Young Choi, Bertrand Choi, Yann Ricquebourg, Richard Zanibbi, Horst Eidenberger: Handwritten Music Object Detection: Open Issues and Baseline Results. 13th International Workshop on Document Analysis Systems. 2018, S. 163–168, doi:10.1109/DAS.2018.51.

- ↑ Alexander Pacha, Jorge Calvo-Zaragoza, Jan jr. Calvo-Zaragoza: Learning Notation Graph Construction for Full-Pipeline Optical Music Recognition. 20th International Society for Music Information Retrieval Conference (in press). 2019.

- ↑ Eelco van der Wel, Karen Ullrich, Ullrich: Optical Music Recognition with Convolutional Sequence-to-Sequence Models. 18th International Society for Music Information Retrieval Conference. Suzhou, China 2017 (ismir.net [PDF]).

- ↑ Jorge Calvo-Zaragoza, David Rizo: End-to-End Neural Optical Music Recognition of Monophonic Scores. In: Applied Sciences. 8. Jahrgang, Nr. 4, 2018, doi:10.3390/app8040606 (mdpi.com).

- ↑ Arnau Baró, Pau Riba, Jorge Riba, Alicia Fornés: Optical Music Recognition by Recurrent Neural Networks. 14th International Conference on Document Analysis and Recognition. 2017, S. 25–26, doi:10.1109/ICDAR.2017.260.

- ↑ Alicia Fornés, Anjan Dutta, Albert Gordo, Josep Lladós: The 2012 Music Scores Competitions: Staff Removal and Writer Identification. In: Graphics Recognition. New Trends and Challenges. Springer, 2013, S. 173–186, doi:10.1007/978-3-642-36824-0_17.

- ↑ Website des SIMSSA Projektes. McGill University, abgerufen am 30. Juli 2019.

- ↑ The Liber Usualis project website. McGill University, abgerufen am 30. Juli 2019.

- ↑ The Cantus Ultimus project website. McGill University, abgerufen am 30. Juli 2019.

- ↑ The TROMPA project website. Trompa Konsortium, abgerufen am 30. Juli 2019.

- ↑ Pacha, Alexander: The OMR Datasets Project (Github Repository). Abgerufen am 30. Juli 2019.

- ↑ Alicia Fornés, Anjan Dutta, Albert Gordo, Josep Lladós: CVC-MUSCIMA: A Ground-truth of Handwritten Music Score Images for Writer Identification and Staff Removal. In: International Journal on Document Analysis and Recognition. 15. Jahrgang, Nr. 3, 2012, S. 243–251, doi:10.1007/s10032-011-0168-2.

- ↑ Jan jr. Hajič, Pavel Pecina, Pecina: The MUSCIMA++ Dataset for Handwritten Optical Music Recognition. 14th International Conference on Document Analysis and Recognition. Kyoto, Japan 2017, S. 39–46, doi:10.1109/ICDAR.2017.16.

- ↑ Lukas Tuggener, Ismail Elezi, Jürgen Elezi, Marcello Pelillo, Thilo Stadelmann: DeepScores – A Dataset for Segmentation, Detection and Classification of Tiny Objects. 24th International Conference on Pattern Recognition. Beijing, China 2018, doi:10.21256/zhaw-4255.

- ↑ Jorge Calvo-Zaragoza, David Rizo, Rizo: Camera-PrIMuS: Neural End-to-End Optical Music Recognition on Realistic Monophonic Scores. 19th International Society for Music Information Retrieval Conference. Paris, France 2018, S. 248–255 (ircam.fr [PDF]).

- ↑ Jorge Calvo-Zaragoza, Jose Oncina, Oncina: Recognition of Pen-Based Music Notation: The HOMUS Dataset. 22nd International Conference on Pattern Recognition. 2014, S. 3038–3043, doi:10.1109/ICPR.2014.524.

- ↑ Emilia Parada-Cabaleiro, Anton Batliner, Alice Batliner, Björn Schuller: The SEILS Dataset: Symbolically Encoded Scores in Modern-Early Notation for Computational Musicology. 18th International Society for Music Information Retrieval Conference. Suzhou, China 2017, S. 575–581 (smcnus.org [PDF]).

- ↑ Alexander Pacha, Horst Eidenberger, Eidenberger: Towards a Universal Music Symbol Classifier. 14th International Conference on Document Analysis and Recognition. Kyoto, Japan 2017, S. 35–36, doi:10.1109/ICDAR.2017.265.

- ↑ Aruspix

- ↑ Audiveris

- ↑ CANTOR

- ↑ Gamera

- ↑ Bertrand Coüasnon: DMOS: a generic document recognition method, application to an automatic generator of musical scores, mathematical formulae and table structures recognition systems. Sixth International Conference on Document Analysis and Recognition. 2001, S. 215–220, doi:10.1109/ICDAR.2001.953786.

- ↑ OpenOMR

- ↑ Rodan

- ↑ Informationen über die Genauigkeit von capella-scan

- ↑ a b PhotoScore Ultimate 7

- ↑ PlayScore Pro

- ↑ iSeeNotes

- ↑ NotateMe Now

- ↑ Info capella-scan

- ↑ FORTE Scan Light fortenotation.com ( vom 22. September 2013 im Internet Archive)Fehler bei Vorlage * Parametername unbekannt (Vorlage:Webarchiv): "datum"

- ↑ Scan Score

- ↑ MIDI-Connections SCAN 2.0 midi-connections.com ( vom 20. Dezember 2013 im Internet Archive)Fehler bei Vorlage * Parametername unbekannt (Vorlage:Webarchiv): "datum"

- ↑ Music Publisher Scanning Edition braeburn.co.uk ( vom 13. April 2013 im Internet Archive)Fehler bei Vorlage * Parametername unbekannt (Vorlage:Webarchiv): "datum"

- ↑ NoteScan

- ↑ OMeR

- ↑ PDFtoMusic

- ↑ ScorScan

- ↑ SharpEye

- ↑ VivaldiScan vivaldistudio.com ( vom 24. Dezember 2005 im Internet Archive)Fehler bei Vorlage * Parametername unbekannt (Vorlage:Webarchiv): "datum"

- ↑ SmartScore musitek.com ( vom 17. April 2012 im Internet Archive)Fehler bei Vorlage * Parametername unbekannt (Vorlage:Webarchiv): "datum"

Weblinks

- Website über Forschungsaktivitäten im Bereich der optischen Notenerkennung

- Github page for open-source projects on optical music recognition

- Bibliography on OMR-Research

- Recording of the ISMIR 2018 tutorial "Optical Music Recognition for Dummies"

- Optical Music Recognition (OMR): Programs and scientific papers

- OMR (Optical Music Recognition) Systems: Ausführlicher Überblick über OMR Systeme (Zuletzt aktualisiert am: 30 January 2007).

- Deutsche Notenscan-Übersichtsseite von Gerd Castan

- Bringing Sheet Music to Life: My Experiences with OMR (Andrew H. Bullen)