Wahrscheinlichkeitsdichtefunktion

In der Wahrscheinlichkeitstheorie ist die Wahrscheinlichkeitsdichtefunktion, oft kurz Dichtefunktion, Wahrscheinlichkeitsdichte oder nur Dichte (abgekürzt WDF oder engl. pdf von probability density function) genannt, ein Hilfsmittel zur Beschreibung einer stetigen Wahrscheinlichkeitsverteilung. Die Integration der Wahrscheinlichkeitsdichte über ein Intervall ergibt die Wahrscheinlichkeit dafür, dass eine Zufallsvariable mit dieser Dichte einen Wert zwischen und annimmt. Die Wahrscheinlichkeitsdichte kann Werte größer als 1 annehmen und sollte nicht mit der Wahrscheinlichkeit selbst verwechselt werden.

Formal handelt es sich um eine Dichte bezüglich des Lebesgue-Maßes.

Während im diskreten Fall Wahrscheinlichkeiten von Ereignissen durch Aufsummieren der Wahrscheinlichkeiten der einzelnen Elementarereignisse berechnet werden können (ein idealer Würfel zeigt beispielsweise jede Zahl mit einer Wahrscheinlichkeit von ), gilt dies nicht mehr für den stetigen Fall. Beispielsweise sind zwei Menschen kaum exakt gleich groß, sondern nur bis auf Haaresbreite oder weniger. In solchen Fällen sind Wahrscheinlichkeitsdichtefunktionen nützlich. Mit Hilfe dieser Funktionen lässt sich die Wahrscheinlichkeit für ein beliebiges Intervall – beispielsweise eine Körpergröße zwischen 1,80 m und 1,81 m – bestimmen, obwohl unendlich viele Werte in diesem Intervall liegen, von denen jeder einzelne die Wahrscheinlichkeit hat.

Definition

Es sei ein Wahrscheinlichkeitsmaß und sei eine reellwertige Zufallsvariable. Eine Funktion heißt Wahrscheinlichkeitsdichte der Zufallsvariable (oder genauer: der Verteilung von ), falls gilt

- bzw.

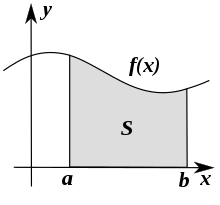

für alle reellen Zahlen . Für eine Zufallsvariable erhält man also die Wahrscheinlichkeit als die Fläche unter der Dichtefunktion über dem Intervall . Für zwei Zufallsvariablen und erhält man die Wahrscheinlichkeit

als das Volumen unter der Dichtefunktion über dem Rechteck .

Eigenschaften

Normierung und Eindeutigkeit

Die Fläche unter der Dichtefunktion hat den Inhalt (sicheres Ereignis):

Die Wahrscheinlichkeitsdichte ist bis auf Abweichungen in einer Nullmenge eindeutig bestimmt. Sie ist stets nicht-negativ und kann (im Gegensatz zu Wahrscheinlichkeiten) beliebig große Werte annehmen, wie aus dem Bild ersichtlich ist.

Umgekehrt gilt: Jede Funktion mit für alle und ist die Dichtefunktion einer eindeutig bestimmten Wahrscheinlichkeitsverteilung.

Analog zu dieser Eigenschaft gilt für ein Paar stetiger Zufallsvariablen für deren gemeinsame Dichte, mit :

Berechnung von Wahrscheinlichkeiten

Die Wahrscheinlichkeit für ein Intervall lässt sich mit der Wahrscheinlichkeitsdichte berechnen als

- .

Diese Formel gilt ebenso für die Intervalle , und , denn es liegt in der Natur von stetigen Zufallsvariablen, dass sie keinen konkreten Wert annehmen können. Daher beträgt die Wahrscheinlichkeit für das Annehmen eines konkreten Wertes (unmögliches Ereignis). Formal ausgedrückt gilt:

- und

Für komplexere Mengen kann die Wahrscheinlichkeit analog durch Integrieren über Teilintervalle ermittelt werden. Allgemein erhält die Wahrscheinlichkeit die Form

- .

Bedingung für die Existenz einer Wahrscheinlichkeitsdichte

besitzt eine Wahrscheinlichkeitsdichte genau dann, wenn die Verteilung von absolutstetig bezüglich des Lebesgue-Maßes ist, d. h., wenn

für jede Lebesgue-Nullmenge (Satz von Radon-Nikodým).

Zusammenhang von Verteilungsfunktion und Dichtefunktion

Die (kumulative) Verteilungsfunktion wird als Integral über die Dichtefunktion gebildet:

- .

Für Zufallsvariablen , die eine Dichtefunktion haben, ist stetig.

Umgekehrt gilt: Wenn die Verteilungsfunktion differenzierbar ist, ist ihre Ableitung eine Dichtefunktion der Verteilung:

- .

Dieser Zusammenhang gilt auch dann noch, wenn stetig ist und es höchstens abzählbar viele Stellen gibt, an denen nicht differenzierbar ist; welche Werte man an diesen Stellen für verwendet, ist unerheblich.

Allgemein existiert eine Dichtefunktion genau dann, wenn die Verteilungsfunktion absolut stetig ist. Diese Bedingung impliziert unter anderem, dass stetig ist und fast überall eine Ableitung besitzt, die mit der Dichte übereinstimmt.

Es ist jedoch zu beachten, dass es Verteilungen wie die Cantor-Verteilung gibt, die eine stetige, fast überall differenzierbare Verteilungsfunktion besitzen, aber dennoch keine Wahrscheinlichkeitsdichte. Fast überall differenzierbar sind Verteilungsfunktionen immer, aber die entsprechende Ableitung erfasst generell nur den absolutstetigen Anteil der Verteilung.

Dichten auf Teilintervallen

Die Wahrscheinlichkeitsdichte einer Zufallsvariablen , die nur Werte in einem Teilintervall der reellen Zahlen annimmt, kann so gewählt werden, dass sie außerhalb des Intervalls den Wert hat. Ein Beispiel ist die Exponentialverteilung mit . Alternativ kann die Wahrscheinlichkeitsdichte als eine Funktion betrachtet werden, d. h. als eine Dichte der Verteilung auf bezüglich des Lebesgue-Maßes auf .

Erwartungswerte

Mithilfe von Dichtefunktionen können auch Erwartungswerte berechnet werden. Ist eine Zufallsvariable mit Dichte , dann gilt für ihren Erwartungswert

- ,

falls das Integral existiert.

Nichtlineare Transformation

Im Falle der nichtlinearen Transformation gilt

- .

Varianzen

Die Varianz einer stetigen Zufallsvariablen ist definiert als die erwartete quadratische Abweichung zwischen und :

Beispiele

Durch für sowie für und für ist eine Dichtefunktion gegeben, denn ist auf ganz nichtnegativ und es gilt

- .

Für gilt:

Die Verteilungsfunktion lässt sich schreiben als

Ist eine Zufallsvariable mit der Dichte , so folgt daher beispielsweise

- .

Für den Erwartungswert von ergibt sich

- .

Weitere Beispiele für Wahrscheinlichkeitsdichten sind in der Liste univariater Wahrscheinlichkeitsverteilungen zu finden.

Mehrdimensionale Zufallsvariable

Wahrscheinlichkeitsdichten kann man auch für mehrdimensionale Zufallsvariablen, also für Zufallsvektoren definieren. Ist eine -wertige Zufallsvariable, so heißt eine Funktion Wahrscheinlichkeitsdichte (bezüglich des Lebesgue-Maßes) der Zufallsvariable , falls gilt

für alle Borelmengen .

Speziell folgt dann für -dimensionale Intervalle mit reellen Zahlen :

- .

Der Begriff der Verteilungsfunktion lässt sich ebenfalls auf mehrdimensionale Zufallsvariablen erweitern. Hier ist in der Notation das ein Vektor und das -Zeichen komponentenweise zu lesen. ist also hierbei eine Abbildung von in das Intervall [0,1] und es gilt

- .

Wenn n-mal stetig differenzierbar ist, erhält man eine Wahrscheinlichkeitsdichte durch partielle Differentiation:

Die Dichten der Komponentenvariablen lassen sich als Dichten der Randverteilungen durch Integration über die übrigen Variablen berechnen.

Des Weiteren gilt: Ist eine -wertige Zufallsvariable mit Dichte, so sind äquivalent:

- besitzt eine Dichte der Form , wobei die reelle Wahrscheinlichkeitsdichte von ist.

- Die Zufallsvariablen sind unabhängig.

Schätzung einer Wahrscheinlichkeitsdichte anhand diskreter Daten

Diskret erfasste, aber eigentlich stetige Daten (Beispielsweise die Körpergröße in Zentimetern) können als Häufigkeitsdichte repräsentiert werden. Das so erhaltene Histogramm ist eine stückweise konstante Schätzung der Dichtefunktion. Alternativ kann beispielsweise mit sogenannten Kerndichteschätzern die Dichtefunktion durch eine stetige Funktion geschätzt werden. Der dazu verwendete Kern sollte dem erwarteten Messfehler entsprechen.

Literatur

- Hans-Otto Georgii: Stochastik: Einführung in die Wahrscheinlichkeitstheorie und Statistik. 4. Auflage. de Gruyter Lehrbuch, Berlin 2009, ISBN 978-3-11-021526-7.

- Norbert Henze: Stochastik für Einsteiger. 7. Auflage. Vieweg Verlag, Wiesbaden 2008, ISBN 978-3-8348-0423-5.

- Achim Klenke: Wahrscheinlichkeitstheorie. 2. Auflage. Springer-Verlag, ISBN 978-3-540-76317-8.

- Lothar Sachs, Jürgen Hedderich: Angewandte Statistik: Methodensammlung mit R. 12. Auflage. Springer-Verlag, Berlin / Heidelberg 2006, ISBN 978-3-540-32160-6.

![{\displaystyle [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935)

![{\displaystyle P_{X}([a,b])=\int _{a}^{b}f(x)\,\mathrm {d} x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6ade35686299b008151dbcc47faff58d078a4df7)

![{\displaystyle P(X\in [a,b])=\int _{a}^{b}f(x)\,{\rm {d}}x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/214c3e938960851a7517c184bb16d1e703f07613)

![{\displaystyle (a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a6969e731af335df071e247ee7fb331cd1a57ae)

![{\displaystyle x\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/64a15936df283add394ab909aa7a5e24e7fb6bb2)

![{\displaystyle I=[a_{1},b_{1}]\times \dotsb \times [a_{n},b_{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c3e3c9526b37a5adcf397d440741549171f97235)