„Globales existenzielles Risiko“ – Versionsunterschied

| [gesichtete Version] | [gesichtete Version] |

K Chewbacca2205 verschob die Seite Benutzer:Versionen/Global catastrophic risk nach Globales existenzielles Risiko, ohne dabei eine Weiterleitung anzulegen Markierung: Begriffsklärungsseiten-Links |

Rücksetzung auf letzte deutsche Version Markierung: Manuelle Zurücksetzung |

||

| Zeile 1: | Zeile 1: | ||

[[Datei:Impact event.jpg|mini|300x300px|Künstlerische Impression eines großen [[Impakt]].Ein Asteroid verursachte das Aussterben der Nichtflugsaurier.<ref name="Schulte10">{{Cite journal |last=Schulte |first=P. |last2=Alegret |first2=L. |last3=Arenillas |first3=I. |last4=Arz |first4=J. A. |last5=Barton |first5=P. J. |last6=Bown |first6=P. R. |last7=Bralower |first7=T. J. |last8=Christeson |first8=G. L. |last9=Claeys |first9=P. |last10=Cockell |first10=C. S. |last11=Collins |first11=G. S. |last12=Deutsch |first12=A. |last13=Goldin |first13=T. J. |last14=Goto |first14=K. |last15=Grajales-Nishimura |first15=J. M. |last16=Grieve |first16=R. A. F. |last17=Gulick |first17=S. P. S. |last18=Johnson |first18=K. R. |last19=Kiessling |first19=W. |last20=Koeberl |first20=C. |last21=Kring |first21=D. A. |last22=MacLeod |first22=K. G. |last23=Matsui |first23=T. |last24=Melosh |first24=J. |last25=Montanari |first25=A. |last26=Morgan |first26=J. V. |last27=Neal |first27=C. R. |last28=Nichols |first28=D. J. |last29=Norris |first29=R. D. |last30=Pierazzo |first30=E. |title=The Chicxulub Asteroid Impact and Mass Extinction at the Cretaceous-Paleogene Boundary |language=en|work=[[Science (journal)|Science]] |issue=5970 |volume=327 |pages=1214–1218 |date=2010-03-05 |doi=10.1126/science.1177265 |pmid=20203042 |bibcode=2010Sci...327.1214S |url=https://doc.rero.ch/record/210367/files/PAL_E4389.pdf}}</ref> ]] |

|||

:''This is about the future of civilization, humans and the earth. For past civilizations, see [[societal collapse]].'' |

|||

Ein '''globales existenzielles Risiko''' (''global catastrophic risk'') oder Weltuntergangsszenario ist ein hypothetisches zukünftiges Ereignis, das das menschliche Wohlergehen in globalem Ausmaß<ref>{{Cite book |last=Bostrom |first=Nick |authorlink=Nick Bostrom |title=Global Catastrophic Risks |language=en|publisher=Oxford University Press |date=2008 |page=1 |url=http://www.global-catastrophic-risks.com/docs/Chap01.pdf}}</ref> beeinträchtigen und sogar die [[Zivilisation|moderne Zivilisation]] gefährden oder zerstören könnte.<ref name="world">{{Cite journal |vauthors=Ripple WJ, Wolf C, Newsome TM, Galetti M, Alamgir M, Crist E, Mahmoud MI, Laurance WF |title=World Scientists' Warning to Humanity: A Second Notice |language=en|work=BioScience |issue=12 |volume=67 |pages=1026–1028 |date=2017-11-13 |doi=10.1093/biosci/bix125 |accessdate=}}</ref> Ein Ereignis, das zum [[Ende der Menschheit|Aussterben der Menschheit]] führen oder das Potenzial der Menschheit dauerhaft und drastisch einschränken könnte, wird als „existenzielles Risiko“ bezeichnet.<ref name="types">{{Cite journal |last=Bostrom |first=Nick |author-link=Nick Bostrom |title=Existential Risks: Analyzing Human Extinction Scenarios and Related Hazards |language=en|work=[[Journal of Evolution and Technology]] |volume=9 |date=2002-03 |url=http://www.nickbostrom.com/existential/risks.html}}</ref> |

|||

'''Risks to civilization, humans and planet Earth''' are [[existential risk]]s that would imperil mankind as a whole and/or have major adverse consequences for the course of human [[civilization]], [[human extinction]] or even the [[end of planet Earth]].<ref name="types">{{cite journal| authorlink=Nick Bostrom| first=Nick| last=Bostrom| year=2001| url=http://www.nickbostrom.com/existential/risks.html| title=Existential Risks: Analyzing Human Extinction Scenarios and Related Hazards| journal=Journal of Evolution and Technology| volume=9| month=March| year=2002}}</ref> The concept finds expression in various [[idiom|idiomatic]] phrases such as "[[End of the World]]", "[[Doomsday]]", "[[wikt:TEOTWAWKI|TEOTWAWKI]]" and others. <!--[is it really pertinent to definte Future studies here?]The prediction of future events is known as [[futures studies]].--> |

|||

In den letzten zwei Jahrzehnten wurde eine Reihe von akademischen und gemeinnützigen Organisationen gegründet, die sich mit der Erforschung globaler katastrophaler und existenzieller Risiken befassen, potenzielle Abhilfemaßnahmen formulieren und diese Maßnahmen entweder befürworten oder umsetzen.<ref name=":32">{{Cite web |title=About FHI |language=en|url=https://www.fhi.ox.ac.uk/ |website=[[Future of Humanity Institute]] |access-date=2021-08-12}}</ref><ref name=":33">{{Cite web |title=About FHI |language=en|url=https://www.fhi.ox.ac.uk/ |website=[[Future of Humanity Institute]] |access-date=2021-08-12}}</ref><ref name=":42">{{Cite web |title=About us |language=en|url=https://www.cser.ac.uk/about-us/ |website=[[Centre for the Study of Existential Risk]] |access-date=2021-08-12}}</ref><ref name=":52">{{Cite web |title=The Future of Life Institute |language=en|url=http://thefutureoflife.org/ |website=[[Future of Life Institute]] |access-date=2014-05-05}}</ref> |

|||

==Types of risks== |

|||

== Definition und Klassifizierung == |

|||

Various risks exist for [[humanity]], but not all risks are equal. Risks can be roughly categorized into six types based on the scope of the risk (Personal, Regional, Global) and the intensity of the risk (Endurable or Terminal). This chart provides some examples. |

|||

[[Datei:X-risk-chart-en-01a.svg|mini|Ausmaß-Schweregrad-Raster aus [[Nick Bostrom|Bostroms]] Papier „Existential Risk Prevention as Global Priority“<ref name="priority">{{Cite journal |last=Bostrom |first=Nick |title=Existential Risk Prevention as Global Priority |work=Global Policy |issue=1 |volume=4 |pages=15–3 |year=2013 |doi=10.1111/1758-5899.12002 |url=http://www.existential-risk.org/concept.pdf}}</ref>]] |

|||

=== Definition von globalen Katastrophenrisiken === |

|||

{| border="1" cellspacing="0" cellpadding="2" class="wikitable" |

|||

Der Begriff „globales Katastrophenrisiko“ ist „nicht klar definiert“ und bezieht sich im Allgemeinen (lose) auf ein Risiko, das „das menschliche Wohlergehen in globalem Ausmaß ernsthaft beeinträchtigen“ könnte.<ref name="Bostrom & Cirkovic 20082">{{Cite book |last1=Bostrom |first1=Nick |last2=Cirkovic |first2=Milan |title=Global Catastrophic Risks |publisher=Oxford University Press |location=Oxford |date=2008 |page=1 |isbn=978-0-19-857050-9}}</ref> |

|||

!colspan="3" align="center"|'''Typology of risk''' <ref name="types" /> |

|||

|- |

|||

! |

|||

!Endurable |

|||

!Terminal |

|||

|- |

|||

|'''Global''' |

|||

|Thinning of the ozone layer |

|||

|Global nuclear war |

|||

|- |

|||

|'''Regional''' |

|||

|Economic recession |

|||

|Genocide |

|||

|- |

|||

|'''Personal''' |

|||

|Theft of car |

|||

|Terminal illness |

|||

|} |

|||

Die Menschheit hat schon früher große Katastrophen erlebt. Einige davon haben schwere Schäden verursacht, waren aber nur lokal begrenzt – z. B. hat der [[Pest|Schwarze Tod]] möglicherweise den Tod von einem Drittel der europäischen Bevölkerung verursacht, was 10 % der damaligen Weltbevölkerung entsprach. Andere waren zwar global, aber nicht so schwerwiegend, z. B. tötete die [[Spanische Grippe|Grippepandemie von 1918]] schätzungsweise 3-6 % der Weltbevölkerung. Die meisten globalen Katastrophenrisiken wären nicht so gravierend, dass sie die Mehrheit des Lebens auf der Erde auslöschen würden, aber selbst wenn dies der Fall wäre, würden sich das [[Ökosystem]] und die Menschheit schließlich wieder erholen (im Gegensatz zu existenziellen Risiken). |

|||

The risks discussed in this article are those in the Global-Terminal category. This type of risk is one where an adverse outcome would either annihilate intelligent life, or permanently and drastically curtail its potential. For an alternative classification system see [[Jamais Cascio]]'s [http://www.openthefuture.com/2006/12/an_eschatological_taxonomy.html An Eschatological Taxonomy]. A problem for this system is the sheer size of humanity; even in the event of catastrophic nuclear war, total collapse of the ice sheets or ocean currents, or the rise of a devastating epidemic, it is extremely likely that some people will survive, though conventional civilization may collapse. |

|||

In ähnlicher Weise werden in Catastrophe: Risk and Response (Risiko und Reaktion) stellt [[Richard Posner]] Ereignisse heraus, die einen „völligen Umsturz oder Ruin“ auf globaler und nicht auf „lokaler oder regionaler“ Ebene herbeiführen, und fasst sie zusammen. Posner hebt solche Ereignisse unter [[Kosten-Nutzen-Analyse|Kosten-Nutzen-Gesichtspunkten]] als besonders beachtenswert hervor, weil sie direkt oder indirekt das Überleben der Menschheit als Ganzes gefährden könnten. |

|||

==Future scenarios== |

|||

=== Definition der existenziellen Risiken === |

|||

There are many scenarios that have been suggested that could happen in the future. Some are certain to happen and will almost certainly end humanity, but may only happen on a very long timescale, or may happen sooner. Others are likely to happen on a shorter timescale, but will probably not completely destroy civilization. Still others are extremely unlikely, and may even be impossible. For example, [[Nick Bostrom]] writes:<ref name="unlikely">Nick Bostrom, section 4.7.</ref> |

|||

Existenzielle Risiken werden definiert als „Risiken, die die Zerstörung des langfristigen Potenzials der Menschheit bedrohen“.<ref name="Ord 20202">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |publisher=Hachette |location=New York |date=2020 |quote=This is an equivalent, though crisper statement of [[Nick Bostrom]]'s definition: "An existential risk is one that threatens the premature extinction of Earth-originating intelligent life or the permanent and drastic destruction of its potential for desirable future development." Source: Bostrom, Nick (2013). "Existential Risk Prevention as Global Priority". Global Policy. 4:15-31. |isbn=978-0-316-48491-6}}</ref> Der Eintritt eines existenziellen Risikos (einer existenziellen Katastrophe) würde entweder das völlige Aussterben der Menschheit bewirken oder unumkehrbar zu einem drastisch schlechteren Zustand führen.<ref name="priority2">{{Cite journal |last=Bostrom |first=Nick |title=Existential Risk Prevention as Global Priority |journal=Global Policy |issue=1 |volume=4 |pages=15–3 |year=2013 |doi=10.1111/1758-5899.12002 |url=http://www.existential-risk.org/concept.pdf |via=Existential Risk}}</ref> Existenzielle Risiken sind eine Unterkategorie globaler Katastrophenrisiken, bei denen der Schaden nicht nur global, sondern auch unheilbar und dauerhaft ist, so dass er sich nicht mehr erholen kann und somit sowohl die jetzige als auch alle künftigen Generationen betrifft. |

|||

:''Some foreseen hazards (hence not members of the current category) which have been excluded from the list of bangs on grounds that they seem too unlikely to cause a global terminal disaster are: solar flares, supernovae, black hole explosions or mergers, gamma-ray bursts, galactic center outbursts, supervolcanoes, buildup of air pollution, gradual loss of human fertility, and various religious doomsday scenarios.'' |

|||

==== Nicht-Aussterberisiken ==== |

|||

===Space=== |

|||

Das [[Aussterben]] ist zwar die offensichtlichste Art und Weise, wie das langfristige Potenzial der Menschheit zerstört werden könnte, aber es gibt auch noch andere Möglichkeiten, darunter der unwiederbringliche Zusammenbruch und die unwiederbringliche [[Dystopie]].<ref name="Ord 202023">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> Eine [[Katastrophe]], die schwerwiegend genug ist, um den dauerhaften, irreversiblen Zusammenbruch der menschlichen Zivilisation zu verursachen, wäre eine existenzielle Katastrophe, auch wenn sie nicht zum Aussterben führt.<ref name="Ord 202024">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> In ähnlicher Weise wäre eine solche Dystopie eine existenzielle Katastrophe, wenn die Menschheit unter ein totalitäres Regime fiele und es keine Chance auf Besserung gäbe. [[Bryan Caplan]] schreibt, dass „vielleicht eine Ewigkeit des Totalitarismus schlimmer wäre als das Aussterben“.<ref name=":72">Bryan Caplan (2008). "[https://books.google.com/books?id=sTkfAQAAQBAJ&pg=PA504 The totalitarian threat]". ''Global Catastrophic Risks'', eds. Bostrom & Cirkovic (Oxford University Press): 504–519. ISBN 978-0-19-857050-9</ref> ([[George Orwell]]s Roman [[1984 (Roman)|1984]] schlägt ein Beispiel vor.) Ein dystopisches Szenario weist die gleichen Hauptmerkmale auf wie die Auslöschung und der unwiederbringliche Zusammenbruch der Zivilisation – vor der Katastrophe hatte die Menschheit eine große Auswahl an Zukunftsperspektiven, aus denen sie wählen konnte; nach der Katastrophe ist die Menschheit für immer in einem schrecklichen Zustand gefangen.<ref name="Ord 202025">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> |

|||

== Mögliche Risikoquellen == |

|||

It is certain that events in space can cause [[life on Earth]] to come to an end. The certain events, however, will happen at an extremely long timescale measured in billions of years. Projections indicate that the [[Andromeda Galaxy]] is on a collision course with the Milky Way. Impact is predicted in about 3 billion years, and so Andromeda will approach at an average speed of about 140 kilometres (87 miles) per second; the two galaxies will probably merge to form a giant elliptical. This merging could eject the solar system in a more eccentric orbit{{Fact|date=February 2007}} and an unwanted position in the merged galaxy causing our planet to become uninhabitable (an actual collision is unnecessary). In about 5 billion years, [[stellar evolution]] predicts our [[sun]] will exhaust its core hydrogen and become a [[red giant]]. In so doing, it will become thousands of times more luminous.<ref>[http://hyperphysics.phy-astr.gsu.edu/hbase/astro/redgia.html Red Giants]</ref> Even in its current phase of stellar evolution, the sun is increasing in luminosity (at a very slow rate). Many scientists predict that in fewer than one billion years, the runaway [[greenhouse effect]] will make Earth unsuitable for life.{{Fact|date=October 2007}} |

|||

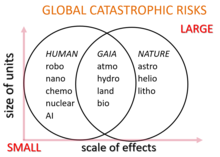

Potenzielle globale Katastrophenrisiken werden üblicherweise als anthropogene oder nicht-anthropogene Gefahren eingestuft. Beispiele für nicht-anthropogene Risiken sind ein [[Impakt|Asteroiden- oder Kometeneinschlag]], ein [[Supervulkan]]ausbruch, eine [[Pandemie|natürliche Pandemie]], ein [[Gammablitz|tödlicher Gammastrahlenausbruch]], ein geomagnetischer Sturm infolge eines koronalen Massenauswurfs, der elektronische Geräte zerstört, ein [[Klimawandel|natürlicher langfristiger Klimawandel]], [[Außerirdisches Leben|feindliches außerirdisches Leben]] oder die Umwandlung der [[Sonne]] in einen roten Riesenstern, der die Erde in Milliarden von Jahren verschlingt. |

|||

[[Datei:Global catastrophic risks.png|mini|Einteilung der globalen Katastrophenrisiken in drei Gruppen, je nachdem, ob sie größtenteils vom Menschen verursacht werden, ob der Mensch die Natur beeinflusst oder ob es sich um rein natürliche Risiken handelt]] |

|||

Anthropogene Risiken sind vom Menschen verursachte Risiken, die mit der Technologie, der Regierungsführung und dem Klimawandel zusammenhängen. Zu den technologischen Risiken gehören die Schaffung [[Künstliche Intelligenz|künstlicher Intelligenz]], die nicht mit den Zielen der Menschheit übereinstimmt, sowie Bio- und [[Nanotechnologie]]. Eine unzureichende oder bösartige [[Global Governance|globale Governance]] schafft Risiken im sozialen und politischen Bereich, wie z. B. einen globalen Krieg und einen [[Nuklearer Holocaust|nuklearen Holocaust]], [[biologische Kriegsführung]] und [[Bioterrorismus]] mit Hilfe genetisch veränderter Organismen, [[Cyber-Terrorismus|Cyberkriegsführung und Cyberterrorismus]], die [[kritische Infrastrukturen]] wie das Stromnetz zerstören, oder radiologische Kriegsführung mit Waffen wie großen [[Kernwaffentechnik|Kobaltbomben]]. Zu den globalen Katastrophenrisiken im Bereich der Steuerung des Erdsystems gehören die globale Erwärmung, die Umweltzerstörung, das Aussterben von Arten, Hungersnöte infolge ungleicher Ressourcenverteilung, Überbevölkerung, Missernten und eine nicht nachhaltige Landwirtschaft. |

|||

== Methodische Herausforderungen == |

|||

On an even longer time scale, the [[ultimate fate of the universe|universe may come to an end]]. The current [[age of the universe]] is estimated as being 13.7 billion years old. There are several competing theories as to the nature of our [[universe]] and how it will end, but in all cases, there will be no life possible. These scenarios take place on a considerably longer timescale than the expansion of the sun. |

|||

Die Erforschung des Wesens und der Abschwächung globaler Katastrophenrisiken und existenzieller Risiken unterliegt einer Reihe einzigartiger Herausforderungen und kann daher nicht ohne weiteres den üblichen Standards wissenschaftlicher Strenge unterworfen werden.<ref name="Ord 202026">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |language=en|publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> So ist es beispielsweise weder machbar noch ethisch vertretbar, diese Risiken experimentell zu untersuchen. [[Carl Sagan]] hat dies in Bezug auf den [[Atomkrieg]] zum Ausdruck gebracht: „Die langfristigen Folgen eines Atomkriegs zu verstehen, ist kein Problem, das sich experimentell überprüfen lässt“.<ref name="Sagan 19832">{{Cite magazine |last=Sagan |first=Carl |title=Nuclear War and Climatic Catastrophe: Some Policy Implications |language=en|magazine=Foreign Affairs |publisher=Council on Foreign Relations |date=1983 |doi=10.2307/20041818 |jstor=20041818 |url=https://www.foreignaffairs.com/articles/1983-12-01/nuclear-war-and-climatic-catastrophe-some-policy-implications |access-date=2020-08-04}}</ref> Darüber hinaus ändern sich viele Katastrophenrisiken schnell, wenn sich die Technologie weiterentwickelt und sich die Rahmenbedingungen, z. B. die geopolitischen Verhältnisse, ändern. Eine weitere Herausforderung ist die allgemeine Schwierigkeit, die Zukunft über lange Zeiträume genau vorherzusagen, insbesondere bei anthropogenen Risiken, die von komplexen politischen, wirtschaftlichen und sozialen Systemen des Menschen abhängen.<ref name="Ord 202027">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |language=en|publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> Zusätzlich zu den bekannten und greifbaren Risiken können unvorhersehbare Aussterbeereignisse durch einen sogenannten [[Schwarzer Schwan (Ereignis)|schwarzem Schwan]] auftreten, was ein zusätzliches methodisches Problem darstellt.<ref name="Ord 202028">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |language=en|publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> |

|||

=== Fehlender historischer Präzedenzfall === |

|||

==== Meteorite impact ==== |

|||

Die Menschheit hat noch nie eine existenzielle Katastrophe erlebt, und wenn eine solche eintreten sollte, wäre sie zwangsläufig beispiellos. Daher stellen existenzielle Risiken aufgrund der Selektionswirkung der Beobachtung eine besondere Herausforderung für die Vorhersage dar, mehr noch als andere langfristige Ereignisse. Anders als bei den meisten Ereignissen ist das Ausbleiben eines vollständigen Aussterbeereignisses in der Vergangenheit kein Beweis gegen die Wahrscheinlichkeit eines solchen Ereignisses in der Zukunft, da es in jeder Welt, die ein solches Aussterbeereignis erlebt hat, keine Beobachter gibt, so dass unabhängig von ihrer Häufigkeit keine Zivilisation in ihrer Geschichte existenzielle Risiken beobachtet hat. Diese anthropischen Probleme lassen sich zum Teil dadurch vermeiden, dass man Beweise betrachtet, die keine derartigen Selektionseffekte haben, wie z. B. Asteroideneinschlagskrater auf dem Mond, oder indem man die wahrscheinlichen Auswirkungen neuer Technologien direkt bewertet. |

|||

Um die Dynamik eines noch nie dagewesenen, nicht wieder gutzumachenden globalen [[Zivilisationskollaps|Zusammenbruchs der Zivilisation]] (eine Art existenzielles Risiko) zu verstehen, kann es lehrreich sein, die verschiedenen lokalen Zusammenbrüche von Zivilisationen zu studieren, die im Laufe der menschlichen Geschichte stattgefunden haben. So endeten beispielsweise Zivilisationen wie das Römische Reich mit dem Verlust der zentralisierten Regierungsgewalt und einem großen zivilisationsweiten Verlust an Infrastruktur und fortschrittlicher Technologie. Diese Beispiele zeigen jedoch, dass Gesellschaften gegenüber Katastrophen recht widerstandsfähig zu sein scheinen. So überlebte das mittelalterliche Europa den [[Schwarzer Tod|Schwarzen Tod]], ohne dass es zu einem zivilisatorischen Zusammenbruch kam, obwohl es 25 bis 50 Prozent seiner Bevölkerung verlor. |

|||

In the [[history of the Earth]], it is widely accepted that several large [[meteorite]]s have hit [[Earth]]. The [[Cretaceous-Tertiary extinction event|Cretaceous-Tertiary asteroid]], for example, is theorized to have caused the extinction of the [[dinosaur]]s. If such an object struck Earth it could have a serious impact on civilization. It's even possible that humanity would be completely destroyed: for this, the asteroid would need to be at least 1 km (0.6 miles) in diameter, but probably between 3–10 km (2–6 miles).<ref name="meteor">Nick Bostrom, section 4.10</ref> Asteroids with a 1 km diameter impact the Earth every 0.5 million years<ref name="meteor" /> on average. Larger asteroids are less common. The last large (>10 km) impact happened [[Cretaceous-Tertiary extinction event|65 million years ago]]. So-called [[Near-Earth asteroid]]s are regularly being observed. |

|||

=== Anreize und Koordinierung === |

|||

Some scientists believe there are patterns in the number of meteorites hitting Earth. An interesting explanation of such a pattern is given by the hypothetical star [[Nemesis (star)|Nemesis]]. This hypothesis states that a star named Nemesis regularly passes through a denser part of the [[Oort cloud]], causing meteorite rains to collide onto Earth. However, the very existence of this pattern is not widely accepted, and the existence of the Nemesis star is highly contested. |

|||

Es gibt wirtschaftliche Gründe, die erklären können, warum so wenig Anstrengungen zur Verringerung existenzieller Risiken unternommen werden. Da es sich um ein [[Globale öffentliche Güter|globales öffentliches Gut]] handelt, sollten wir davon ausgehen, dass es auf den Märkten unterversorgt ist. Selbst wenn eine große Nation in Maßnahmen zur Risikominderung investiert, wird diese Nation nur einen kleinen Teil des Nutzens daraus ziehen. Darüber hinaus ist die Verringerung existenzieller Risiken ein globales öffentliches Gut zwischen den Generationen, da der größte Teil des Nutzens aus der Verringerung existenzieller Risiken künftigen Generationen zugute käme, und obwohl diese künftigen Menschen theoretisch vielleicht bereit wären, erhebliche Summen für die Verringerung existenzieller Risiken zu zahlen, gibt es keinen Mechanismus für eine solche Transaktion. |

|||

=== Kognitive Verzerrungen === |

|||

A star passage that will cause an increase of meteorites is the arrival of a star called [[Gliese 710]]. This star is probably moving on a collision course with the [[Solar System]] and will likely be at a distance 1.1 [[light year]]s from the Sun in 1.4 million years. Some models predict that this will send large amounts of comets from the [[Oort cloud]] to the Earth.<ref>http://www.exitmundi.nl/Gliese710.htm</ref> Other models, such as the one by García-Sánchez, predict an increase of only 5%. |

|||

Zahlreiche kognitive Verzerrungen können die Beurteilung der Bedeutung existenzieller Risiken beeinflussen, wie z. B. die Unempfindlichkeit gegenüber dem Umfang, die hyperbolische Diskontierung, die Verfügbarkeitsheuristik, der Konjunktionstrugschluss, die Affektheuristik und der Overconfidence-Effekt. |

|||

Die mangelnde Sensibilität für das Ausmaß des Problems beeinflusst, wie schlimm die Menschen das Aussterben der menschlichen Rasse einschätzen. Wenn Menschen beispielsweise motiviert sind, Geld für altruistische Zwecke zu spenden, steigt die Menge, die sie bereit sind zu geben, nicht linear mit dem Ausmaß des Problems: Die Menschen sind ungefähr genauso bereit, den Tod von 200.000 oder 2.000 Vögeln zu verhindern.<ref>Desvousges, W.H., Johnson, F.R., Dunford, R.W., Boyle, K.J., Hudson, S.P., and Wilson, N. 1993, Measuring natural resource damages with contingent valuation: tests of validity and reliability. In Hausman, J.A. (ed), ''Contingent Valuation:A Critical Assessment'', pp. 91–159 (Amsterdam: North Holland).</ref> In ähnlicher Weise sind die Menschen oft mehr über die Bedrohung von Einzelpersonen besorgt als über die von größeren Gruppen.<ref name="Yudkowsky 20082">{{Cite journal |last=Yudkowsky |first=Eliezer |title=Cognitive Biases Potentially Affecting Judgment of Global Risks |language=en|journal=Global Catastrophic Risks |pages=91–119 |date=2008 |bibcode=2008gcr..book...86Y |url=https://intelligence.org/files/CognitiveBiases.pdf}}</ref> |

|||

==== Less likely cosmic threats ==== |

|||

[[Eliezer Yudkowsky]] stellt die Theorie auf, dass die Vernachlässigung von Handlungsspielräumen bei der öffentlichen Wahrnehmung existenzieller Risiken eine Rolle spielt:<ref>Yudkowsky, Eliezer. "[https://intelligence.org/files/CognitiveBiases.pdf Cognitive biases potentially affecting judgment of global risks]". Global catastrophic risks 1 (2008): 86. p.114</ref> |

|||

<!-- Commented out until specifically sourced --> |

|||

{{Zitat |

|||

<!-- I can't find anything on an event that might cause Kuiper Belt objects to break loose |

|||

|Text=Wesentlich größere Zahlen, wie 500 Millionen Tote, und vor allem qualitativ andere Szenarien, wie das Aussterben der gesamten menschlichen Spezies, scheinen eine andere Denkweise auszulösen... Menschen, die nicht im Traum daran denken würden, ein Kind zu verletzen, hören von der existenziellen Gefahr und sagen: „Nun, vielleicht verdient die menschliche Spezies nicht wirklich zu überleben.}} |

|||

*'''[[Kuiper Belt]]'''. Beyond [[Neptune (planet)|Neptune]] lies a vast reserve of large icy objects that could break loose and strike Earth. |

|||

Alle bisherigen Vorhersagen über das Aussterben der Menschheit haben sich als falsch erwiesen. Für einige lässt dies zukünftige Warnungen weniger glaubwürdig erscheinen. [[Nick Bostrom]] argumentiert, dass das Ausbleiben des menschlichen Aussterbens in der Vergangenheit ein schwacher Beweis dafür ist, dass es in der Zukunft kein menschliches Aussterben geben wird, und zwar aufgrund des Survivor Bias und anderer anthropischer Effekte.<ref>{{Cite web |title=We're Underestimating the Risk of Human Extinction |language=en|date=2012-03-06 |publisher=The Atlantic |url=https://www.theatlantic.com/technology/archive/2012/03/were-underestimating-the-risk-of-human-extinction/253821/ |access-date=2016-07-01}}</ref> |

|||

--> |

|||

<!-- For this one, I have found 'http://www.exitmundi.nl/gmc.htm', but no scientific citations. |

|||

Please don't re-add before you find one - exitmundi.nl does not look like a reliable source to me (Gerrit) |

|||

*'''[[Dark nebula]]'''. A giant molecular cloud chokes out Earth's atmosphere. |

|||

--> |

|||

<!-- I don't see how this one can happen. Discover Magazine writes: |

|||

''...persuasive evidence that our sun doesn't engage in such excess...'' |

|||

Is anyone disagreeing with Discover Magazine? |

|||

*'''[[Solar flare]]'''. Giant solar flare fries the Earth.-to do so it would have to possess tremendous energy, extremely unlikely. |

|||

--> |

|||

<!--Discover is a popular science magazine. It would better to have a professional-level source--> |

|||

A number of other scenarios have been suggested. Massive objects, e.g., a [[star]], large [[planet]] or [[black hole]], could be catastrophic if a close encounter occurred in the solar system. Another threat might come from [[Gamma ray bursts#Mass extinction on Earth|gamma ray bursts]]; some scientists believe this may have caused mass extinction 450 million years ago.<ref name="gammaray">[http://www.nasa.gov/vision/universe/starsgalaxies/gammaray_extinction.html Explosions in Space May Have Initiated Ancient Extinction on Earth], [[NASA]].</ref> Both are very unlikely.<ref name="unlikely" /> Still others see [[extraterrestrial life]] as a possible threat to mankind;<ref name="aliens">[http://www.findarticles.com/p/articles/mi_m1511/is_10_21/ai_65368918 Twenty ways the world could end suddenly], Discover Magazine</ref> although alien life has never been found, scientists such as [[Carl Sagan]] have postulated that the existence of extraterrestrial life is very likely. In 1969, the "[[Extra-Terrestrial Exposure Law]]" was added to the Code of Federal Regulations (Title 14, Section 1211) in response to the possibility of biological contamination resulting from the US Apollo Space Program. It was removed in 1991.<ref>[http://www.snopes.com/legal/et.htm Urban Legends Reference Pages: Legal Affairs (E.T. Make Bail)]</ref> Scientists consider such a scenario technically possible, but unlikely.<ref name="aliensunlikely">Nick Bostrom, section 7.2.</ref> |

|||

Der Soziobiologe [[Edward O. Wilson|E. O. Wilson]] argumentierte, dass: „Der Grund für diesen kurzsichtigen Nebel liegt nach Ansicht der Evolutionsbiologen darin, dass er bis auf die letzten paar Jahrtausende der zwei Millionen Jahre, die die Gattung Homo existiert, tatsächlich von Vorteil war... Es wurde viel Wert auf die nahe Zukunft und die frühe Fortpflanzung gelegt und wenig auf andere Dinge. Katastrophen von einem Ausmaß, wie sie nur alle paar Jahrhunderte vorkommen, wurden vergessen oder in einen Mythos verwandelt.“<ref>Is Humanity Suicidal? ''The New York Times Magazine'' May 30, 1993)</ref> |

|||

===Earth=== |

|||

== Vorgeschlagene Entschärfung == |

|||

In the history of the Earth, many [[ice age]]s have occurred. More ice ages will almost certainly come at an interval of 40,000–100,000 years. This would have a serious impact on civilization, because vast areas of land (mainly in [[North-America]], [[Europe]], and [[Asia]]) could become uninhabitable. It would still be possible to live in the tropical regions, but with possible loss of humidity/water. Currently, the world is technically existing in a warm period between such ice ages (the last ending c. 10000 years ago), and all civilization save a few hunter-gatherer populations has come into existence within that time. |

|||

=== Mehrschichtige Verteidigung === |

|||

A less predictable scenario is a global [[pandemic]]. For example, if [[HIV]] mutates and becomes as transmissible as the [[common cold]], the consequences would be disastrous, but probably not fatal to the human species,<ref name="pandemic">Nick Bostrom, section 4.9.</ref> as some people are immune to HIV.<ref>http://www.pbs.org/wgbh/evolution/library/10/4/l_104_06.html</ref> This particular scenario would also contradict the observable tendency for pathogens to become less fatal over time as a function of [[natural selection]]. A pathogen that quickly kills its hosts will not likely have enough time to spread to new ones, while one that kills its hosts more slowly or not at all will allow carriers more time to spread the infection, and thus likely outcompete a more lethal species or strain. A real-life example of this process can be found in the historical evolution of [[syphilis]] towards [http://www.qmul.ac.uk/news/newsrelease.php?news_id=9 a less virulent form]. Also as a virus mutates in a direction of being easily transmittable it will likely give up much of its virulence in the process. Though this is not to say that a highly destructive and highly transmissible disease is not possible. Of course, a pandemic resulting in human extinction need not arise naturally; the possibility of one caused by a deliberately-engineered pathogen cannot be ruled out. |

|||

Defense in depth ist ein nützlicher Rahmen für die Kategorisierung von Maßnahmen zur Risikominderung in drei Verteidigungsebenen: |

|||

# Prävention: Verringerung der Wahrscheinlichkeit, dass eine Katastrophe überhaupt erst eintritt. Beispiel: Maßnahmen zur Verhinderung des Ausbruchs neuer hoch ansteckender Krankheiten. |

|||

Another possibility is the [[megatsunami]]. A megatsunami could, for example, destroy the entire east coast of the [[USA|United States of America]] (see [[La Palma]]). The coastal areas of the entire world could be flooded in case of the collapse of the [[West Antarctic Ice Sheet]].<ref name="wais">[http://igloo.gsfc.nasa.gov/wais/ US West Antarctice Ice Sheet initiative]</ref> While none of these scenarios could possibly destroy humanity completely, they could regionally threaten civilization. |

|||

# Reaktion: Verhinderung der Ausweitung einer Katastrophe auf die globale Ebene. Beispiel: Maßnahmen zur Verhinderung der Eskalation eines kleinen nuklearen Konflikts zu einem umfassenden Atomkrieg. |

|||

# Widerstandsfähigkeit: Erhöhung der Widerstandsfähigkeit der Menschheit (gegen das Aussterben) angesichts globaler Katastrophen. Beispiel: Maßnahmen zur Erhöhung der Ernährungssicherheit während eines nuklearen Winters. |

|||

Das Aussterben der Menschheit ist am wahrscheinlichsten, wenn alle drei Schutzmechanismen schwach sind, d. h. „wenn wir Risiken nicht verhindern können, nicht erfolgreich darauf reagieren können und nicht widerstandsfähig dagegen sind“.<ref name=":22">{{Cite journal |last1=Cotton-Barratt |first1=Owen |last2=Daniel |first2=Max |last3=Sandberg |first3=Anders |title=Defence in Depth Against Human Extinction: Prevention, Response, Resilience, and Why They All Matter |journal=Global Policy |issue=3 |volume=11 |pages=271–282 |date=2020 |issn=1758-5899|doi=10.1111/1758-5899.12786 |pmid=32427180 |pmc=7228299}}</ref> |

|||

An [[ecological disaster]], such as world crop failure and collapse of [[ecosystem services]], could be induced by the present trends of [[overpopulation]], [[economic development]], and non-[[sustainable agriculture]]. Most of these scenarios involve one or more of the following: [[Holocene extinction event]], [[Water crisis|scarcity of water]] that could lead to approximately one half of the Earth's population being without safe [[drinking water]], [[pollinator decline]], [[overfishing]], massive [[deforestation]], [[desertification]], [[climate change]], or massive [[water pollution]] episodes. A very recent threat in this direction is [[colony collapse disorder]], a phenomenon that might foreshadow the imminent extinction of the [[Western honeybee]]. As the bee plays a vital role in [[pollination]], its extinction would severely disrupt the [[food chain]]. |

|||

Der beispiellose Charakter existenzieller Risiken stellt eine besondere Herausforderung für die Entwicklung von Maßnahmen zur Risikominderung dar, da die Menschheit nicht aus früheren Ereignissen lernen kann.<ref name="Ord 202022">{{Cite book |last=Ord |first=Toby |title=The Precipice: Existential Risk and the Future of Humanity |publisher=Hachette |location=New York |date=2020 |isbn=978-0-316-48491-6}}</ref> |

|||

The 20th century has seen a rapid increase in [[human population]] due to [[History of medicine#Modern medicine|medical advances]] and massive increase in agricultural productivity<ref>[http://news.bbc.co.uk/1/hi/world/south_asia/4994590.stm BBC NEWS | The end of India's green revolution?]</ref> made by the [[Green Revolution]].<ref>[http://www.foodfirst.org/media/opeds/2000/4-greenrev.html Food First/Institute for Food and Development Policy]</ref> Between 1950 and 1984, as the Green Revolution transformed agriculture around the globe, world grain production increased by 250%. The Green Revolution in agriculture helped food production to keep pace with worldwide [[population growth]]. The energy for the Green Revolution was provided by fossil fuels in the form of [[fertilizers]] (natural gas), [[pesticides]] (oil), and [[hydrocarbon]] fueled [[irrigation]].<ref>[http://wolf.readinglitho.co.uk/mainpages/agriculture.html How peak oil could lead to starvation]</ref> David Pimentel, professor of ecology and [[agriculture]] at [[Cornell University]], and Mario Giampietro, senior researcher at the National Research Institute on Food and Nutrition (INRAN), place in theirs study ''Food, Land, Population and the U.S. Economy'' the maximum [[U.S. population]] for a [[sustainability|sustainable economy]] at 200 million. To achieve a sustainable economy and avert disaster, the [[United States]] must reduce its population by at least one-third, and [[world population]] will have to be reduced by two-thirds, says study.<ref>[http://www.energybulletin.net/281.html Eating Fossil Fuels | EnergyBulletin.net]</ref> |

|||

=== Finanzierung === |

|||

The authors of this study believe that the mentioned agricultural crisis will only begin to impact us after 2020, and will not become critical until 2050. Considering the [[Hubbert peak theory|peak of global oil]] production (and subsequent decline of production) was December 2005, along with an oncoming peak of North American [[natural gas]] production will very likely precipitate this agricultural crisis much sooner than expected. Geologist [[Dale Allen Pfeiffer]] claims that coming decades could see spiraling [[food]] prices without relief and massive [[starvation]] on a global level such as never experienced before.<ref>[http://www.soilassociation.org/peakoil Peak Oil: the threat to our food security]</ref><ref>[http://europe.theoildrum.com/node/2225 Agriculture Meets Peak Oil]</ref> |

|||

Einige Forscher argumentieren, dass sowohl die Forschung als auch andere Initiativen im Zusammenhang mit existenziellen Risiken unterfinanziert sind. Nick Bostrom stellt fest, dass mehr Forschung über Star Trek, Snowboarding oder Mistkäfer betrieben wurde als über existenzielle Risiken. Bostroms Vergleiche wurden als „selbstherrlich“ kritisiert<ref name=":02">{{Cite news |title=Could science destroy the world? These scholars want to save us from a modern-day Frankenstein |last=Kupferschmidt |first=Kai |url=https://www.science.org/content/article/could-science-destroy-world-these-scholars-want-save-us-modern-day-frankenstein |work=Science |publisher=AAAS |date=2018-01-11 |access-date=2020-04-20}}</ref>. Im Jahr 2020 verfügte die Organisation des Biowaffenübereinkommens über ein Jahresbudget von 1,4 Millionen US-Dollar.<ref>{{Cite book |last=Toby Ord |author-link=Toby Ord |title=The precipice: Existential risk and the future of humanity |date=2020 |quote=The international body responsible for the continued prohibition of bioweapons (the Biological Weapons Convention) has an annual budget of $1.4 million - less than the average McDonald's restaurant |isbn=978-0-316-48489-3}}</ref> |

|||

=== Überlebensplanung === |

|||

An abrupt [[Pole shift theory|reorientation of Earth's axis of rotation]] could cause a new [[extinction event]].<ref>{{cite web | url=http://www.nytimes.com/2006/10/12/science/earth/12extinct.html?ex=1176609600&en=9fc4a5a53674ca70&ei=5087&excamp=mkt_at8 | title=Study Links Extinction Cycles to Changes in Earth’s Orbit and Tilt | publication=[[The New York Times]] |date=2006-10-12 | author=Wilford, John Noble}}</ref> |

|||

Einige Wissenschaftler schlagen vor, auf der Erde eine oder mehrere autarke, abgelegene und dauerhaft bewohnte Siedlungen zu errichten, die speziell für das Überleben einer globalen Katastrophe geschaffen werden. Der Wirtschaftswissenschaftler [[Robin Hanson]] vertritt die Auffassung, dass ein Zufluchtsort, der dauerhaft nur 100 Menschen beherbergt, die Überlebenschancen der Menschen bei einer Reihe von globalen Katastrophen erheblich verbessern würde.<ref>Hanson, Robin. "[https://mason.gmu.edu/~rhanson/collapse.pdf Catastrophe, social collapse, and human extinction]". Global catastrophic risks 1 (2008): 357.</ref> |

|||

Die Lagerung von Lebensmitteln ist weltweit vorgeschlagen worden, aber die Kosten wären hoch. Außerdem würde sie wahrscheinlich zu den Millionen von Todesfällen pro Jahr aufgrund von Unterernährung beitragen. Im Jahr 2022 hat ein Team unter der Leitung von David Denkenberger die Kosteneffizienz von widerstandsfähigen Lebensmitteln mit der Sicherheit von künstlicher allgemeiner Intelligenz (AGI) verglichen und festgestellt, dass die Arbeit an widerstandsfähigen Lebensmitteln mit einer Wahrscheinlichkeit von 98-99 % eine höhere marginale Wirkung hat.<ref>{{Cite journal |last1=Denkenberger |first1=David C. |last2=Sandberg |first2=Anders |last3=Tieman |first3=Ross John |last4=Pearce |first4=Joshua M. |title=Long term cost-effectiveness of resilient foods for global catastrophes compared to artificial general intelligence safety |journal=International Journal of Disaster Risk Reduction |volume=73 |pages=102798 |date=2022 |doi=10.1016/j.ijdrr.2022.102798 |bibcode=2022IJDRR..7302798D |url=https://www.sciencedirect.com/science/article/pii/S2212420922000176}}</ref> Einige Überlebenskünstler legen sich einen Vorrat an Lebensmitteln für mehrere Jahre an. |

|||

<!-- Is any source claiming that the magnetic pole shift will cause any deaths? Discover Magazine doesn't really do so |

|||

*It's likely that '''[[Earth's magnetic field|Magnetic pole shift]]s''' have happened in the past and will happen in the future. This might pose a problem for society, although it will not cause mass extinction. |

|||

--> |

|||

When the [[supervolcano]] at [[Yellowstone National Park|Yellowstone]] last erupted, 600,000 years ago, the magma and ash covered roughly all of the area of North America west of the Mississippi river. Another such eruption could threaten civilization. Such an eruption could also release large amounts of gases that could alter the balance of the planet's carbon dioxide and cause a runaway greenhouse effect, or enough pyroclastic debris and other material may be thrown into the atmosphere to partially block out the sun and cause a natural [[nuclear winter]], similar to 1816, the [[Year Without A Summer]]. |

|||

<!-- |

|||

commented out: need work |

|||

*'''[[Verneshot]]'''. |

|||

--> |

|||

Der [[Svalbard Global Seed Vault]] ist 120 m tief in einem Berg auf einer Insel in der [[Arktis]] vergraben. Er soll 2,5 Milliarden Samen aus mehr als 100 Ländern aufnehmen, um die Ernten der Welt zu schützen. Das umgebende Gestein hat eine Temperatur von −6 °C (Stand 2015), aber der Tresor wird mit Hilfe von Kühlschränken, die mit lokal gewonnener Kohle betrieben werden, auf −18 °C gehalten.<ref>{{Cite web |last=Suzanne Goldenberg |title=The doomsday vault: the seeds that could save a post-apocalyptic world |date=2015-05-20 |url=https://www.theguardian.com/science/2015/may/20/the-doomsday-vault-seeds-save-post-apocalyptic-world |website=[[The Guardian]] |access-date=2017-06-30}}</ref> |

|||

===Humanity=== |

|||

Wenn die Gesellschaft weiterhin funktioniert und die Biosphäre bewohnbar bleibt, könnte der Kalorienbedarf der derzeitigen menschlichen Bevölkerung theoretisch auch während einer längeren Abwesenheit von Sonnenlicht gedeckt werden, vorausgesetzt, man plant ausreichend voraus. Zu den vermuteten Lösungen gehören die Züchtung von Pilzen auf der toten Pflanzenbiomasse, die nach der Katastrophe zurückbleibt, die Umwandlung von Zellulose in Zucker oder die Verfütterung von Erdgas an Methan-verdauende Bakterien.<ref>{{Cite journal |last1=Denkenberger |first1=David C. |last2=Pearce |first2=Joshua M. |title=Feeding everyone: Solving the food crisis in event of global catastrophes that kill crops or obscure the sun |journal=Futures |volume=72 |pages=57–68 |date=September 2015 |doi=10.1016/j.futures.2014.11.008 |url=https://hal.archives-ouvertes.fr/hal-02113583/file/Feeding_Everyone_Solving_the_Food_Crisis.pdf |s2cid=153917693}}</ref> |

|||

Some threats for humanity come from humanity itself. The scenario that has been explored most is a [[nuclear warfare#current concerns|nuclear war]] or [[Doomsday device|another weapon]] with similar possibilities. It is difficult to predict whether it would exterminate humanity, but very certainly could alter civilization, in particular if there was a [[nuclear winter]] event.<ref name="nuclearwinter">Nick Bostrom, section 4.2.</ref> |

|||

=== Globale katastrophale Risiken und globale Governance === |

|||

Another category of disasters are [[technological singularity|unforeseen consequences of technology]]. |

|||

Eine unzureichende globale Governance schafft Risiken im sozialen und politischen Bereich, aber die Governance-Mechanismen entwickeln sich langsamer als der technologische und soziale Wandel. Regierungen, der Privatsektor und die breite Öffentlichkeit sind besorgt über das Fehlen von Governance-Mechanismen, die einen effizienten Umgang mit Risiken sowie Verhandlungen und Rechtsprechung zwischen unterschiedlichen und widersprüchlichen Interessen ermöglichen. Dies wird durch das Verständnis der Verflechtung globaler Systemrisiken noch unterstrichen.<ref>{{Cite web |title=Global Challenges Foundation {{!}} Understanding Global Systemic Risk |url=https://globalchallenges.org/en/our-work/quarterly-reports/resetting-the-frame/understanding-global-systemic-risk |archive-url=https://web.archive.org/web/20170816005747/https://globalchallenges.org/en/our-work/quarterly-reports/resetting-the-frame/understanding-global-systemic-risk |archive-date=August 16, 2017 |url-status=dead |website=globalchallenges.org |access-date=August 15, 2017}}</ref> In Ermangelung oder in Erwartung einer globalen Governance können die nationalen Regierungen individuell handeln, um globale Katastrophen besser zu verstehen, abzumildern und sich darauf vorzubereiten.<ref>{{Cite web |title=Global Catastrophic Risk Policy |url=https://www.gcrpolicy.com/ |website=gcrpolicy.com |access-date=2019-08-11}}</ref> |

|||

It has been suggested that [[Artificial Intelligence#Hypothetical consequences of AI|learning computers]] take unforeseen actions or that [[Robot#possible dangers|robots]] would out-compete humanity.<ref name="billjoy">[[Bill Joy]], [http://www.wired.com/wired/archive/8.04/joy_pr.html Why the future doesn't need us]. In:[[Wired magazine|Wired]] magazine. See also [[technological singularity]].</ref> |

|||

[[Biotechnology]] could lead to the creation of a [[pandemic]], [[Nanotechnology]] could lead to [[grey goo]] - in both cases, either deliberately or by accident.<ref name="drexler">[[Eric Drexler]], [[Engines of Creation]], ISBN 0-385-19973-2, [http://www.foresight.org/EOC/ available online]</ref> |

|||

It has also been suggested that physical scientists might accidentally create a device that could destroy the earth and the solar system.<ref name="physicsaccident">Nick Bostrum, section 4.8</ref> In [[string theory]], there are some unknown variables. If those turn out to have an unfortunate value, the universe may not be stable and alter completely, destroying everything in it,<ref name="quantumtunneling">Malcolm Perry, ''Quantum Tunneling towards an exploding Universe?'' in: [[Nature]], [[24 April]] [[1986]]. [http://www.uhh.hawaii.edu/~dixon/quantum_tunneling.pdf available online].</ref> either at random or by an accidental experiment. This is called [[Quantum Vacuum Collapse]] by some.<ref name="qvc">[http://www.exitmundi.nl/vacuum.htm The day the Quantum Vacuum Collapsed]</ref> Another kind of accident is the ''[[Ice-9 Type Transition]]'', in which our planet including everything on it becomes a strange matter planet in a chain reaction. Some do not view this as a credible scenario.<ref name="ice9">Frank Wilczek, in an e-mail, [http://lists.nau.edu/cgi-bin/wa?A2=ind9907&L=phys-l&F=&S=&P=29937| This available online].</ref> |

|||

=== Klima-Notfallpläne === |

|||

It has been suggested that runaway [[global warming]] might cause the climate on Earth to become like [[Venus]], which would make it uninhabitable. In less extreme scenarios it could cause the end of civilization.<ref name="runaway">Isaac M. Held, Brian J. Soden, ''Water Vapor Feedback and Global Warming'', In: Annu. Rev. Energy Environ 2000. [http://www.gfdl.noaa.gov/~gth/netscape/2000/annrev00.pdf available online]. Page 449.</ref> |

|||

2018 rief der [[Club of Rome]] zu mehr Klimaschutz auf und veröffentlichte seinen Klima-Notfallplan, der zehn Aktionspunkte zur Begrenzung des Anstiegs der globalen Durchschnittstemperatur auf 1,5 Grad Celsius vorschlägt<ref>{{Cite web |last=[[Club of Rome]] |title=The Climate Emergency Plan |year=2018 |url=https://clubofrome.org/publication/the-climate-emergency-plan/ |access-date=2020-08-17}}</ref>. Außerdem veröffentlichte der Club 2019 den umfassenderen Planetary Emergency Plan.<ref>{{Cite web |last=[[Club of Rome]] |title=The Planetary Emergency Plan |year=2019 |url=https://clubofrome.org/publication/the-planetary-emergency-plan/ |access-date=2020-08-17}}</ref> |

|||

Es gibt Anhaltspunkte dafür, dass die kollektive Auseinandersetzung mit den emotionalen Erfahrungen, die bei der Betrachtung der Anfälligkeit der menschlichen Spezies im Kontext des Klimawandels auftreten, eine Anpassung an diese Erfahrungen ermöglicht. Wenn die kollektive Auseinandersetzung mit emotionalen Erfahrungen und deren Verarbeitung förderlich ist, kann dies zu einem Wachstum der Widerstandsfähigkeit, der psychologischen Flexibilität, der Toleranz gegenüber emotionalen Erfahrungen und des gemeinschaftlichen Engagements führen.<ref>{{Cite journal |last1=Kieft |first1=J. |last2=Bendell |first2=J |title=The responsibility of communicating difficult truths about climate influenced societal disruption and collapse: an introduction to psychological research |journal=Institute for Leadership and Sustainability (IFLAS) Occasional Papers |volume=7 |pages=1–39 |year=2021 |url=https://insight.cumbria.ac.uk/id/eprint/5950}}</ref> |

|||

[[James Lovelock]], creator of the [[Gaia hypothesis]], in his book ''[[The Revenge of Gaia]]'' (2006), has suggested that the elimination of [[rain forest]]s, and the falling planetary [[biodiversity]] is removing the [[homeostasis|homeostatic]] [[negative feedback]] mechanisms that maintain climate stability by reducing the effects of [[greenhouse gas]] emissions (particularly [[carbon dioxide]]). With the heating of the oceans, the extension of the [[thermocline]] layer into [[Arctic]] and [[Antarctic]] waters is preventing the overturning and nutrient enrichment necessary for [[algal blooms]] of [[phytoplankton]] on which the [[ecosystem]]s of these areas depend. With the loss of phytoplankton and tropical rain forests, two of the main [[carbon dioxide sink]]s for reducing [[global warming]], he suggests a runaway [[positive feedback]] effect could cause tropical [[desert]]s to cover most of the worlds tropical regions, and the disappearance of polar ice caps, posing a serious challenge to global civilization. |

|||

=== Kolonisierung des Weltraums === |

|||

Using [[scenario analysis]], the [[Global scenario group]] (GSG), a coalition of international scientists convened by [[Paul Raskin]], developed a series of possible futures for the world as it enters a [[Planetary Phase of Civilization]]. One scenario involves the complete breakdown of civilization as the effects of [[climate change]] become more pronounced, competition for scarce resources increases, and the rift between the poor and the wealthy widens. The GSG’s other scenarios, such as [[Policy Reform]], [[Eco-Communalism]], and [[Great Transition]] avoid this societal collapse and eventually result in environmental and social [[sustainability]]. They claim the outcome is dependent on [[human choice]]<ref>[http://www.gtinitiative.org/documents/PDFFINALS/16WorldLines.pdf World Lines: Pathways, Pivots, and the Global Future]. [[Paul Raskin]]. 2006. Boston:[http://www.tellus.org Tellus Institute] </ref> and the possible formation of a [[global citizens movement]] which could influence the trajectory of global development.<ref> [http://www.gtinitiative.org/documents/PDFFINALS/15Movements.pdf Dawn of the Cosmopolitan: The Hope of a Global Citizens Movement] Orion Kriegman. 2006. Boston:[http://www.tellus.org Tellus Institute]</ref> |

|||

Die Besiedlung des Weltraums ist eine vorgeschlagene Alternative, um die Chancen zu verbessern, ein Aussterbeszenario zu überleben.<ref name="physorg201008092">{{Internetquelle |url=http://www.physorg.com/news200591777.html |titel=Mankind must abandon earth or face extinction: Hawking |hrsg=physorg.com |datum=2010-08-09 |abruf=2012-01-23}}</ref> Lösungen dieses Ausmaßes könnten eine Technik im Megamaßstab erfordern. |

|||

Der [[Astrophysiker]] [[Stephen Hawking]] sprach sich dafür aus, andere Planeten innerhalb des [[Sonnensystem]]s zu kolonisieren, sobald die Technologie weit genug fortgeschritten ist, um die Überlebenschancen der Menschheit bei planetenweiten Ereignissen wie einem globalen thermonuklearen Krieg zu verbessern.<ref>{{Cite news |title=Hawking: Humans at risk of lethal 'own goal' |last=Shukman |first=David |url=https://www.bbc.com/news/science-environment-35344664 |work=BBC News |date=2016-01-19 |access-date=2016-07-01}}</ref> |

|||

Other scenarios that have been named are: |

|||

Der Milliardär [[Elon Musk]] schreibt, dass die Menschheit zu einer multiplanetaren Spezies werden muss, um nicht auszusterben.<ref>{{Cite web |last=Ginsberg |first=Leah |title=Elon Musk thinks life on earth will go extinct, and is putting most of his fortune toward colonizing Mars |date=2017-06-16 |url=https://www.cnbc.com/2017/06/16/elon-musk-colonize-mars-before-extinction-event-on-earth.html |website=CNBC}}</ref> Mit seinem Unternehmen [[SpaceX]] entwickelt Musk eine Technologie, die er für die Besiedlung des [[Mars (Planet)|Mars]] einsetzen will. |

|||

; [[Antibiotic resistance]] : Natural selection would create super bacteria that are resistant to antibiotics, devastating the world population and causing a global collapse of civilization.{{Fact|date=February 2007}} |

|||

; [[Demography]] : Demographic trends create a "baby bust" that threatens the order of civilization.<ref name="babybust">[[Phillip Longman]] [http://www.foreignaffairs.org/20040501faessay83307/phillip-longman/the-global-baby-bust.html "The Global Baby Bust"] in [[Foreign Affairs]] magazine.</ref> |

|||

; [[Mutual assured destruction]] : A full scale [[Nuclear war]] could kill billions, and the resulting [[nuclear winter]] would effectively crush any form of civilization. |

|||

; [[Dysgenics]] : The ideas of [[dysgenics]] suggest that the average individual in a civilization may eventually become weaker, because the most intelligent reproduce least leaving the population less able to perform higher functions. |

|||

; [[Finance]] : Markets fail worldwide, resulting in economic collapse: mass unemployment, rioting, famine, death, and cannibalism.{{Fact|date=February 2007}} (This scenario happened, [[Great Depression|to some extent]], in the [[1930s]] and [[1940s]], [[Causes of World War II|helping to cause a major war]] that has, so far, been the only [[Hiroshima and Nagasaki|war to involve nuclear weapons]]. That war (along with its [[Second Sino-Japanese War|its immediate precursor in Asia]]) also involved [[Nanjing massacre|major atrocities]] and [[Holocaust|genocide]]. Such a scenario, in an age of [[ICBM]]s and [[hydrogen bomb]]s, might be even worse in the future.) |

|||

; [[Overpopulation]] : World population may increase to such an extent in the future that it would lead to lack of space for habitation, except on the Moon and other planets.{{Fact|date=February 2007}} |

|||

; [[Peak oil#Implications of a world peak|Peak oil]] : Oil becomes scarce before an economically viable replacement is devised, leading to global chaos and discomfort.<ref name="peakoil">[[James Howard Kunstler]] [http://www.rollingstone.com/news/story/_/id/7203633?rnd=1128183871020&has-player=true&version=6.0.12.1059 "The Long Emergency"], in [[Rolling Stone Magazine]]</ref> |

|||

; [[Experimental accident]] : The unlikely creation of a hypothetical [[gravitational singularity|microsingularity]] or exotic matter in particle acceleration experiments, or some unanticipated experimental accident, resulting in destruction of the planet or a large scale disaster. An (unrealised) example was that the first test of an atomic weapon might lead to ignition of the atmosphere and global destruction (see [[Trinity test]]). |

|||

=== |

=== Verschiebung der Erde === |

||

In einigen Milliarden Jahren wird sich die Sonne zu einem [[Roter Riese|Roten Riesen]] ausdehnen und die Erde verschlucken. Dies kann vermieden werden, indem die Erde weiter von der Sonne entfernt wird, so dass die Temperatur in etwa konstant bleibt. Dies kann erreicht werden, indem man die Bahnen von Kometen und Asteroiden so verändert, dass sie nahe an der Erde vorbeiziehen, so dass sie der Erdbahn Energie zuführen.<ref>{{cite journal |last1=Korycansky |first1=Donald G. |last2=Laughlin |first2=Gregory |last3=Adams |first3=Fred C. |title=Astronomical engineering: a strategy for modifying planetary orbits |journal=Astrophysics and Space Science |issue=4 |volume=275 |pages=349–366 |year=2001 |arxiv=astro-ph/0102126 |doi=10.1023/A:1002790227314 |bibcode=2001Ap&SS.275..349K |hdl=2027.42/41972 |s2cid=5550304}}</ref> Da sich die Sonne nur langsam ausdehnt, würde etwa eine solche Begegnung alle 6.000 Jahre ausreichen. |

|||

:''See main article [[Apocalyptic and post-apocalyptic fiction]] |

|||

=== Zweifler und Gegner === |

|||

==Historical futurist scenarios== |

|||

Der Psychologe [[Steven Pinker]] hat das existenzielle Risiko als „nutzlose Kategorie“ bezeichnet, die von realen Bedrohungen wie dem Klimawandel und dem Atomkrieg ablenken kann.<ref name=":03">{{Cite news |title=Could science destroy the world? These scholars want to save us from a modern-day Frankenstein |last=Kupferschmidt |first=Kai |url=https://www.science.org/content/article/could-science-destroy-world-these-scholars-want-save-us-modern-day-frankenstein |work=Science |publisher=AAAS |date=2018-01-11 |access-date=2020-04-20}}</ref> |

|||

Every generation has faced its own fears of an unknown future; the historical record of prior end of civilization scenarios is plentiful. Some of these include the following. |

|||

== Organisationen == |

|||

Many [[fiction]]al (and [[non-fiction]]al) stories from the era of the [[Cold War]] were based on the belief that a [[nuclear war]] was inevitable, and that this would result in the destruction of all life on the planet Earth (see [[World War III]] for a list). |

|||

Das [[Bulletin of the Atomic Scientists]] (gegründet 1945) ist eine der ältesten globalen Risikoorganisationen und wurde gegründet, nachdem die Öffentlichkeit nach dem Zweiten Weltkrieg durch die Möglichkeit eines Atomkriegs alarmiert wurde. Sie untersucht Risiken im Zusammenhang mit Atomkrieg und Kernenergie und ist bekannt für die 1947 eingeführte [[Weltuntergangsuhr]]. Das [[Foresight Institute]] (gegründet 1986) untersucht die Risiken der Nanotechnologie und deren Nutzen. Es war eine der ersten Organisationen, die sich mit den unbeabsichtigten Folgen einer ansonsten harmlosen Technologie beschäftigte, die auf globaler Ebene aus dem Ruder läuft. Gegründet wurde es von [[Eric Drexler|K. Eric Drexler]], der „[[graue Schmiere]]“ postulierte.<ref>{{Cite journal |last=Giles |first=Jim |title=Nanotech takes small step towards burying 'grey goo' |journal=Nature |issue=6992 |volume=429 |pages=591 |year=2004 |doi=10.1038/429591b |pmid=15190320 |bibcode=2004Natur.429..591G |doi-access=free}}</ref> |

|||

Nach dem Jahr 2000 gründete eine wachsende Zahl von Wissenschaftlern, Philosophen und Tech-Milliardären Organisationen, die sich mit der Erforschung globaler Risiken sowohl innerhalb als auch außerhalb der akademischen Welt beschäftigen.<ref>{{Cite web |last=Sophie McBain |title=Apocalypse soon: the scientists preparing for the end times |date=2014-09-25 |url=https://www.newstatesman.com/sci-tech/2014/09/apocalypse-soon-scientists-preparing-end-times |website=[[New Statesman]] |access-date=2015-06-05}}</ref> |

|||

The [[Year 2000 problem|Y2K bug]] was supposed to wreak havoc on [[computer system]]s. See also [[Millennialism]]. |

|||

Zu den [[Nichtregierungsorganisation|unabhängigen Nichtregierungsorganisationen]] (NGOs) gehört das Machine Intelligence Research Institute (gegründet 2000), das sich zum Ziel gesetzt hat, das Risiko einer durch [[künstliche Intelligenz]] verursachten Katastrophe zu verringern; zu den Spendern gehören [[Peter Thiel]] und Jed McCaleb.<ref>{{Cite journal |last=Angela Chen |title=Is Artificial Intelligence a Threat? |journal=The Chronicle of Higher Education |date=2014-09-11 |url=https://chronicle.com/article/Is-Artificial-Intelligence-a/148763/ |access-date=2015-06-05}}</ref> |

|||

[[Sir Isaac Newton]] (1642-1727), who was involved in alchemy and many other things in addition to science and mathematics, studied old texts and surmised that the end of the world would happen no earlier than [[2060]], although he was reluctant to put an exact date on it.<ref>[http://www.isaac-newton.org/newton_2060.htm "Isaac Newton, the Apocalypse and 2060 A.D."], by Stephen D. Snobelen, University of King’s College, Halifax</ref> |

|||

Die [[Nuclear Threat Initiative]] (gegründet 2001) versucht, die globale Bedrohung durch nukleare, biologische und chemische Bedrohungen zu verringern und die Schäden nach einem Ereignis einzudämmen<ref name=":63">{{Cite web |title=Nuclear Threat Initiative |url=https://www.nti.org/ |website=[[Nuclear Threat Initiative]] |access-date=2015-06-05}}</ref>. Sie unterhält einen Index für die Sicherheit von Kernmaterial.<ref>{{Cite web |title=About the Lifeboat Foundation |publisher=The Lifeboat Foundation |url=https://lifeboat.com/ |access-date=2013-04-26}}</ref> |

|||

Many mistakenly believe that the [[Maya civilization]]'s [[Maya calendar|long count calendar]] ends abruptly on [[December 21]] [[2012]]. This misconception is due to the Maya practice of abbreviating their dates to five decimal places.On monuments where the full date is shown the end of the last creation is said to happen much farther in the future; however, the Mayas did believe that there will be a baktun ending in 2012. A baktun marks the end of a 400 year period and was a significant event on the Maya calendar. In the [[Aztec calendar]], 2012 marks the end of a 26,000 year planetary cycle.This cycle is known as the [[Great Year]] and most likely refers to the [[precession of the equinoxes]]. |

|||

Die Lifeboat Foundation (gegründet 2009) finanziert Forschungsarbeiten zur Verhinderung einer technologischen Katastrophe. Der Großteil der Forschungsgelder fließt in Projekte an Universitäten.<ref>{{Cite web |last=Ashlee |first=Vance |author-link=Ashlee Vance |title=The Lifeboat Foundation: Battling Asteroids, Nanobots and A.I. |date=2010-07-20 |url=https://bits.blogs.nytimes.com/2010/07/20/the-lifeboat-foundation-battling-asteroids-nanobots-and-a-i/ |website=[[New York Times]] |access-date=2015-06-05}}</ref> |

|||

==Notes== |

|||

{{reflist|2}} |

|||

Das Global Catastrophic Risk Institute (seit 2011) ist eine gemeinnützige, überparteiliche Denkfabrik mit Sitz in den USA, die von Seth Baum und Tony Barrett gegründet wurde. Das GCRI betreibt Forschungs- und Politikarbeit zu verschiedenen Risiken, darunter künstliche Intelligenz, Atomkrieg, Klimawandel und Asteroideneinschläge. Die Global Challenges Foundation (gegründet 2012) mit Sitz in Stockholm, gegründet von Laszlo Szombatfalvy, veröffentlicht jährlich einen Bericht über den Stand der globalen Risiken. Das Future of Life Institute (gegründet 2014) setzt sich für die Verringerung extremer, weitreichender Risiken durch transformative Technologien ein und steuert die Entwicklung und den Einsatz dieser Technologien zum Nutzen aller Lebewesen durch die Vergabe von Zuschüssen, politische Lobbyarbeit in den Vereinigten Staaten, der Europäischen Union und den Vereinten Nationen sowie durch Bildungsarbeit. |

|||

==References== |

|||

*Corey S. Powell (2000). [http://www.findarticles.com/p/articles/mi_m1511/is_10_21/ai_65368918 "Twenty ways the world could end suddenly"], ''[[Discover Magazine]]'' |

|||

*[[Martin Rees]] (2004). ''[[Our Final Hour|OUR FINAL HOUR: A Scientist's warning: How Terror, Error, and Environmental Disaster Threaten Humankind's Future in This Century — On Earth and Beyond]]''. ISBN 0-465-06863-4 |

|||

*[[Jean-Francois Rischard]] (2003). ''High Noon 20 Global Problems, 20 Years to Solve Them''. ISBN 0-465-07010-8 |

|||

*[[Edward O. Wilson]] (2003). ''The Future of Life''. ISBN 0-679-76811-4 |

|||

Elon Musk, Vitalik Buterin und Jaan Tallinn sind einige der größten Spender. Das Center on Long-Term Risk (gegründet 2016), früher bekannt als Foundational Research Institute, ist eine britische Organisation, die sich auf die Verringerung der Risiken astronomischen Leids (S-Risiken) durch neue Technologien konzentriert.<ref name="cltr2">{{Cite web |title=About Us |publisher=Center on Long-Term Risk |url=https://longtermrisk.org/about-us |access-date=2020-05-17 |quote=We currently focus on efforts to reduce the worst risks of astronomical suffering (s-risks) from emerging technologies, with a focus on transformative artificial intelligence.}}</ref> |

|||

==Further reading== |

|||

*[[Derrick Jensen]] (2006) ''[[Endgame (Derrick Jensen books)|Endgame]]''. ISBN 1-58322-730-X |

|||

*[[Jared Diamond]] (2005). ''[[Collapse: How Societies Choose to Fail or Succeed]]''. ISBN 0-670-03337-5 |

|||

*[[John Leslie (philosopher)|John Leslie]] (1996). ''The End of the World''. ISBN 0-415-14043-9 |

|||

Zu den universitären Organisationen gehört das [[Future of Humanity Institute]] (gegründet 2005), das sich mit Fragen der langfristigen Zukunft der Menschheit und insbesondere mit existenziellen Risiken befasst.<ref name=":34">{{Cite web |title=About FHI |url=https://www.fhi.ox.ac.uk/ |website=[[Future of Humanity Institute]] |access-date=2021-08-12}}</ref> Es wurde von [[Nick Bostrom]] gegründet und hat seinen Sitz an der [[University of Oxford|Universität Oxford]].<ref name=":35">{{Cite web |title=About FHI |url=https://www.fhi.ox.ac.uk/ |website=[[Future of Humanity Institute]] |access-date=2021-08-12}}</ref> |

|||

==See also== |

|||

*[[Societal collapse]] |

|||

*[[Planetary Phase of Civilization]] |

|||

*[[Global warming]] |

|||

*[[Cradle of Humanity]] |

|||

{{Doomsday}} |

|||

Das Centre for the Study of Existential Risk (gegründet 2012) ist eine Organisation mit Sitz an der [[University of Cambridge|Universität Cambridge]], die vier große technologische Risiken untersucht: künstliche Intelligenz, Biotechnologie, globale Erwärmung und Kriegsführung.<ref name=":43">{{Cite web |title=About us |url=https://www.cser.ac.uk/about-us/ |website=[[Centre for the Study of Existential Risk]] |access-date=2021-08-12}}</ref> Alle sind vom Menschen verursachte Risiken, wie [[Huw Price]] gegenüber der Nachrichtenagentur AFP erklärte: „Es scheint eine vernünftige Vorhersage zu sein, dass irgendwann in diesem oder im nächsten Jahrhundert die Intelligenz den Zwängen der Biologie entkommen wird“. Er fügte hinzu, dass wir dann „nicht mehr die Klügsten sind“ und Gefahr laufen, der Gnade von „Maschinen ausgeliefert zu sein, die nicht böswillig sind, sondern Maschinen, deren Interessen uns nicht einschließen“.<ref>{{Cite web |last=Hui |first=Sylvia |title=Cambridge to study technology's risks to humans |date=2012-11-25 |publisher=Associated Press |url=http://bigstory.ap.org/article/cambridge-study-technologys-risk-humans |archive-url=https://web.archive.org/web/20121201021050/http://bigstory.ap.org/article/cambridge-study-technologys-risk-humans |archive-date=2012-12-01 |url-status=dead |access-date=2012-01-30}}</ref> Stephen Hawking war als Berater tätig. |

|||

==External links== |

|||

*[http://abcnews.go.com/2020/story?id=2319986 Last Days On Earth] (TV documentary) ABC News 2-hour Special Edition of 20/20 on 7 real end-of-the-world scenarios (Wed. Aug 30 2006) |

|||

*[http://www.guardian.co.uk/life/feature/story/0,13026,1458536,00.html "What a way to go"] from ''[[The Guardian]]''. Ten scientists name the biggest danger to Earth and assesses the chances of it happening. April 14, 2005. |

|||

*[http://www.bbc.co.uk/bbcthree/tv/end_day.shtml End Day] The theories of the end of world into a television programme presented by BBC television. |

|||

*[http://www.frankfuredi.com/articles/misanthropy-20060418.shtml "Confronting the New Misanthropy"], by [[Frank Furedi]] in ''[[Spiked (magazine)|Spiked]]'', April 18 2006 |

|||

Die Millennium Alliance for Humanity and the Biosphere ist eine an der [[Stanford University]] ansässige Organisation, die sich mit vielen Fragen im Zusammenhang mit der globalen Katastrophe befasst, indem sie Mitglieder der akademischen Geisteswissenschaften zusammenbringt.<ref>{{Cite book |last=Scott Barrett |title=Environment and Development Economics: Essays in Honour of Sir Partha Dasgupta |publisher=Oxford University Press |year=2014 |page=112 |isbn=978-0-19-967785-6 |url=https://books.google.com/books?id=_26VAwAAQBAJ&pg=PA112 |access-date=June 5, 2015}}</ref> Sie wurde u. a. von [[Paul Ehrlich]] gegründet.<ref>{{Cite book |last=Guruprasad Madhavan |title=Practicing Sustainability |publisher=Springer Science & Business Media |year=2012 |page=43 |isbn=978-1-4614-4348-3 |url=https://books.google.com/books?id=BQ6bxpMr5yMC&pg=PA43 |access-date=June 5, 2015}}</ref> An der Stanford University gibt es auch das Center for International Security and Cooperation, das sich mit der politischen Zusammenarbeit zur Verringerung des globalen Katastrophenrisikos befasst. |

|||

[[:Category:Futurology]] |

|||

Das Center for Security and Emerging Technology wurde im Januar 2019 an der Georgetown's Walsh School of Foreign Service gegründet und wird sich auf die politische Forschung zu neuen Technologien konzentrieren, wobei der Schwerpunkt zunächst auf künstlicher Intelligenz liegt. Es erhielt einen Zuschuss von 55 Mio. USD von Good Ventures, wie von Open Philanthropy vorgeschlagen.<ref name="CSET2">{{Cite news |title=Georgetown launches think tank on security and emerging technology |last=Anderson |first=Nick |url=https://www.washingtonpost.com/local/education/georgetown-launches-think-tank-on-security-and-emerging-technology/2019/02/27/d6dabc62-391f-11e9-a2cd-307b06d0257b_story.html |newspaper=Washington Post |date=2019-02-28 |access-date=2019-03-12}}</ref> |

|||

[[es:Fin de la civilización]] |

|||

[[fi:Maailmanloppu]] |

|||

Andere Risikobewertungsgruppen sind in Regierungsorganisationen angesiedelt oder gehören zu diesen. Die [[Weltgesundheitsorganisation]] (WHO) verfügt über eine Abteilung namens Global Alert and Response (GAR), die globale epidemische Krisen überwacht und darauf reagiert.<ref>{{Cite web |title=Global Alert and Response (GAR) |url=https://www.who.int/csr/en/ |archive-url=https://web.archive.org/web/20030216050054/http://www.who.int/csr/en/ |archive-date=2003-02-16 |url-status=dead |website=[[World Health Organization]] |access-date=2015-06-05}}</ref> GAR hilft den Mitgliedsstaaten bei der Ausbildung und der Koordinierung der Reaktion auf Epidemien. Die [[United States Agency for International Development]] (USAID) hat ihr Emerging Pandemic Threats Program, das darauf abzielt, natürlich entstandene Pandemien an ihrem Ursprung zu verhindern und einzudämmen.<ref>{{Cite web |title=USAID Emerging Pandemic Threats Program |publisher=[[USAID]] |url=http://avianflu.aed.org/eptprogram |archive-url=https://web.archive.org/web/20141022095429/http://avianflu.aed.org/eptprogram/ |archive-date=2014-10-22 |url-status=dead |access-date=2015-06-05}}</ref> Das Lawrence Livermore National Laboratory hat eine Abteilung mit der Bezeichnung Global Security Principal Directorate, die im Auftrag der Regierung Themen wie Biosicherheit und Terrorismusbekämpfung erforscht.<ref>{{Cite web |title=Global Security |publisher=[[Lawrence Livermore National Laboratory]] |url=https://www-gs.llnl.gov/ |access-date=2015-06-05}}</ref> |

|||

== Weblinks == |

|||

{{Commonscat|Existential risk|Globales existenzielles Risiko|audio=1|video=1}} |

|||

== Einzelnachweise == |

|||

<references responsive /> |

|||

[[Kategorie:Risiko]] |

|||

Version vom 14. August 2023, 09:17 Uhr

Ein globales existenzielles Risiko (global catastrophic risk) oder Weltuntergangsszenario ist ein hypothetisches zukünftiges Ereignis, das das menschliche Wohlergehen in globalem Ausmaß[2] beeinträchtigen und sogar die moderne Zivilisation gefährden oder zerstören könnte.[3] Ein Ereignis, das zum Aussterben der Menschheit führen oder das Potenzial der Menschheit dauerhaft und drastisch einschränken könnte, wird als „existenzielles Risiko“ bezeichnet.[4]

In den letzten zwei Jahrzehnten wurde eine Reihe von akademischen und gemeinnützigen Organisationen gegründet, die sich mit der Erforschung globaler katastrophaler und existenzieller Risiken befassen, potenzielle Abhilfemaßnahmen formulieren und diese Maßnahmen entweder befürworten oder umsetzen.[5][6][7][8]

Definition und Klassifizierung

Definition von globalen Katastrophenrisiken

Der Begriff „globales Katastrophenrisiko“ ist „nicht klar definiert“ und bezieht sich im Allgemeinen (lose) auf ein Risiko, das „das menschliche Wohlergehen in globalem Ausmaß ernsthaft beeinträchtigen“ könnte.[10]

Die Menschheit hat schon früher große Katastrophen erlebt. Einige davon haben schwere Schäden verursacht, waren aber nur lokal begrenzt – z. B. hat der Schwarze Tod möglicherweise den Tod von einem Drittel der europäischen Bevölkerung verursacht, was 10 % der damaligen Weltbevölkerung entsprach. Andere waren zwar global, aber nicht so schwerwiegend, z. B. tötete die Grippepandemie von 1918 schätzungsweise 3-6 % der Weltbevölkerung. Die meisten globalen Katastrophenrisiken wären nicht so gravierend, dass sie die Mehrheit des Lebens auf der Erde auslöschen würden, aber selbst wenn dies der Fall wäre, würden sich das Ökosystem und die Menschheit schließlich wieder erholen (im Gegensatz zu existenziellen Risiken).

In ähnlicher Weise werden in Catastrophe: Risk and Response (Risiko und Reaktion) stellt Richard Posner Ereignisse heraus, die einen „völligen Umsturz oder Ruin“ auf globaler und nicht auf „lokaler oder regionaler“ Ebene herbeiführen, und fasst sie zusammen. Posner hebt solche Ereignisse unter Kosten-Nutzen-Gesichtspunkten als besonders beachtenswert hervor, weil sie direkt oder indirekt das Überleben der Menschheit als Ganzes gefährden könnten.

Definition der existenziellen Risiken

Existenzielle Risiken werden definiert als „Risiken, die die Zerstörung des langfristigen Potenzials der Menschheit bedrohen“.[11] Der Eintritt eines existenziellen Risikos (einer existenziellen Katastrophe) würde entweder das völlige Aussterben der Menschheit bewirken oder unumkehrbar zu einem drastisch schlechteren Zustand führen.[12] Existenzielle Risiken sind eine Unterkategorie globaler Katastrophenrisiken, bei denen der Schaden nicht nur global, sondern auch unheilbar und dauerhaft ist, so dass er sich nicht mehr erholen kann und somit sowohl die jetzige als auch alle künftigen Generationen betrifft.

Nicht-Aussterberisiken

Das Aussterben ist zwar die offensichtlichste Art und Weise, wie das langfristige Potenzial der Menschheit zerstört werden könnte, aber es gibt auch noch andere Möglichkeiten, darunter der unwiederbringliche Zusammenbruch und die unwiederbringliche Dystopie.[13] Eine Katastrophe, die schwerwiegend genug ist, um den dauerhaften, irreversiblen Zusammenbruch der menschlichen Zivilisation zu verursachen, wäre eine existenzielle Katastrophe, auch wenn sie nicht zum Aussterben führt.[14] In ähnlicher Weise wäre eine solche Dystopie eine existenzielle Katastrophe, wenn die Menschheit unter ein totalitäres Regime fiele und es keine Chance auf Besserung gäbe. Bryan Caplan schreibt, dass „vielleicht eine Ewigkeit des Totalitarismus schlimmer wäre als das Aussterben“.[15] (George Orwells Roman 1984 schlägt ein Beispiel vor.) Ein dystopisches Szenario weist die gleichen Hauptmerkmale auf wie die Auslöschung und der unwiederbringliche Zusammenbruch der Zivilisation – vor der Katastrophe hatte die Menschheit eine große Auswahl an Zukunftsperspektiven, aus denen sie wählen konnte; nach der Katastrophe ist die Menschheit für immer in einem schrecklichen Zustand gefangen.[16]

Mögliche Risikoquellen

Potenzielle globale Katastrophenrisiken werden üblicherweise als anthropogene oder nicht-anthropogene Gefahren eingestuft. Beispiele für nicht-anthropogene Risiken sind ein Asteroiden- oder Kometeneinschlag, ein Supervulkanausbruch, eine natürliche Pandemie, ein tödlicher Gammastrahlenausbruch, ein geomagnetischer Sturm infolge eines koronalen Massenauswurfs, der elektronische Geräte zerstört, ein natürlicher langfristiger Klimawandel, feindliches außerirdisches Leben oder die Umwandlung der Sonne in einen roten Riesenstern, der die Erde in Milliarden von Jahren verschlingt.