Supercomputer

Als Supercomputer oder Superrechner werden die schnellsten Rechner ihrer Zeit bezeichnet. Dabei ist es unerheblich, auf welcher Bauweise der Rechner beruht. Ein typisches Merkmal eines modernen Supercomputers ist seine große Anzahl an Prozessoren, die auf gemeinsame Peripheriegeräte und einen teilweise gemeinsamen Hauptspeicher zugreifen können. Supercomputer werden häufig für Computersimulationen im Bereich des Hochleistungsrechnens eingesetzt.

Aufbau

Da sich nicht beliebig schnelle Prozessoren bauen lassen, sind alle Hochleistungsrechner Parallelrechner. Ein Parallelrechner ist ein Computer, in dem Operationen gleichzeitig auf mehrere CPUs verteilt werden, um die Arbeitsgeschwindigkeit zu erhöhen. Für die optimale Nutzung eines Supercomputers muss die Programmierung deshalb möglichst genau auf die einzelnen, parallel arbeitenden Prozessoren abgestimmt werden.

Supercomputer sind (wie auch heutzutage jeder handelsübliche Computer, im unteren Preissegment) Vektorrechner. Dominierend sind x86-64 von Intel (Xeon) und AMD (Opteron), IBM BlueGene/Q und Sparc64.

Ursprünglich wurde die herausragende Rechenleistung durch maximale Ausnutzung der verfügbaren Technik erzielt, indem Konstruktionen gewählt wurden, die für größere Serienproduktion zu teuer waren (z. B. Flüssigkeitskühlung, exotische Bauelemente und Materialien, kompakter Aufbau für kurze Signalwege), die Zahl der Prozessoren war eher gering. Seit geraumer Zeit etablieren sich vermehrt sogenannte Cluster, bei denen eine große Anzahl von (meist preiswerten) Einzelrechnern zu einem großen Rechner vernetzt werden. Im Vergleich zu einem Vektorrechner besitzen die Knoten in einem Cluster eigene Peripherie und ausschließlich einen eigenen, lokalen Hauptspeicher. Cluster verwenden Standardkomponenten, deshalb bieten sie zunächst Kostenvorteile gegenüber Vektorrechnern. Sie erfordern aber einen weit höheren Programmieraufwand. Es ist abzuwägen, ob die eingesetzten Programme sich dafür eignen, auf viele Prozessoren verteilt zu werden. Verwendete Programmiersprachen sind unter anderem Fortran und C.

Eng verbunden mit dem Begriff Supercomputer ist die Firma Cray. Sie ist benannt nach ihrem Gründer Seymour Cray und stellte ihren ersten Supercomputer in den 1970er Jahren her. Der erste offiziell installierte Supercomputer Cray-1 schaffte 1976 130 MegaFLOPS. Zum Vergleich: eine normale CPU von 2008 (Intel Core i7-965 3,2 GHz, 4 Kerne) schafft 33.000 MegaFLOPS, eine aktuelle Highendconsumergrafikkarte von 2013 (Geforce GTX Titan) theoretische 4.500.000 MegaFLOPS.[2]

Einsatzzweck

Die Herstellungskosten eines Supercomputers aus der TOP10 bewegen sich derzeit in einem sehr hohen zweistelligen, oftmals bereits dreistelligen Euro-Millionenbetrag.

Die heutigen Supercomputer werden überwiegend zu Simulationszwecken eingesetzt. Je realitätsnäher eine Simulation komplexer Zusammenhänge wird, desto mehr Rechenleistung wird in der Regel benötigt. Ein Vorteil der Supercomputer ist, dass sie durch ihre extrem schnelle und damit große Rechenleistung immer mehr Interdependenzen berücksichtigen können. Dies erlaubt das Einbeziehen weiterreichender, oftmals auch unscheinbarer Neben- oder Randbedingungen zur eigentlichen Simulation und gewährleistet dadurch ein immer aussagekräftigeres Gesamtergebnis.

Die derzeitigen Haupteinsatzgebiete der Supercomputer umfassen dabei die Bereiche Biologie, Chemie, Geologie, Luft- und Raumfahrt, Medizin, Wettervorhersage, Klimaforschung, Militär und Physik.

Im militärischen Bereich haben Supercomputer es z. B. ermöglicht, neue Atombombenentwicklungen durch Simulation, ohne Stützdaten durch weitere unterirdische Atombombenversuche, durchzuführen. Die Bereiche kennzeichnen sich dadurch, dass es sich um sehr komplexe Systeme bzw. Teilsysteme handelt, die in weitreichendem Maße miteinander verknüpft sind. So haben Veränderungen in dem einen Teilsystem meist mehr oder minder starke Auswirkungen auf benachbarte oder angeschlossene Systeme. Durch den Einsatz von Supercomputern wird es immer leichter möglich, viele solcher Konsequenzen zu berücksichtigen oder sogar zu prognostizieren, wodurch bereits weit im Vorfeld etwaige Gegenmaßnahmen getroffen werden könnten. Dies gilt z. B. bei Simulationen zum Klimawandel, der Vorhersagen von Erdbeben oder Vulkanausbrüchen sowie in der Medizin bei der Simulation neuer Wirkstoffe auf den Organismus. Solche Simulationen sind logischerweise, ganz unabhängig von der Rechenleistung, nur so genau, wie es die programmierten Parameter bzw. Modelle zur Berechnung zulassen. Die enormen Investitionssummen in die stetige Steigerung der FLOPS und damit die Entwicklung von immer schnelleren Supercomputern werden vor allem mit den Nutzenvorteilen und dem eventuellen „Wissensvorsprung“ für die Menschheit gerechtfertigt, weniger aus den Aspekten des allgemeinen technischen Fortschritts.

Betriebssysteme

Da Linux sehr flexibel angepasst und optimiert werden kann, hat es sich auch bei Supercomputern stark verbreitet. In der TOP500-Liste der schnellsten Computersysteme (Stand Juni 2012) werden insgesamt 462 ausschließlich unter Linux betriebene Systeme und 11 teilweise (CNK/SLES 9) unter Linux betriebene Systeme aufgelistet. Damit laufen 92,4 % der Systeme vollständig und 94,6 % zumindest teilweise unter Linux. Fast alle anderen Systeme werden unter Unix oder Unix-artigen Systemen betrieben. Der im Desktop-Bereich größte Konkurrent Microsoft Windows spielt im Bereich der Höchstleistungsrechner mit 2 Systemen (Platz 94 und 156) kaum eine Rolle (0,4 %). Im Juni 2011 waren es noch 4 Systeme (darunter Platz 40), die unter Windows betrieben wurden.

Ausgewählte Superrechner

Aktuelle Superrechner

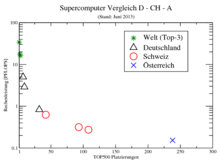

Die schnellsten Superrechner nach Leistung werden heutzutage halbjährlich in der TOP500-Liste aufgeführt. Als Bewertungsgrundlage dient der Linpack-Benchmark. Die schnellsten Superrechner nach Energieeffizienz bzw. MFLOPS/W werden seit November 2007 in der Green500-Liste geführt.[3]

Diese Green500-Liste vom November 2014 weist länderweise gemittelte Effizienzen von 1895 MFLOPS/W (Italien) bis hinunter zu 168 MFLOPS/W (Malaysia) auf.

Ausgewählte aktuelle Superrechner (weltweit)

| Name | Standort | TeraFLOPS | Konfiguration | Energiebedarf | Zweck |

|---|---|---|---|---|---|

| Sunway TaihuLight | National Supercomputing Center, Wuxi, Jiangsu | 93.000,00 | 40.960 Sunway SW26010 (260 Kerne, 1,45 GHz), 1,31 PB RAM, 40 Serverschränke mit jeweils 4 x 256 Nodes, insgesamt 10.649.600 Kerne | 15.370 kW | |

| Tianhe-2[4] | National University for Defense Technology, Changsha, China finaler Standort: National Supercomputer Center (Guangzhou, China) |

33.862,00 | 32.000 Intel Xeon E5-2692 CPUs (Ivy Bridge, 12 Kerne, 2,2 GHz) + 48.000 Intel Xeon Phi 31S1P Co-Prozessoren (57 Kerne, 1,1 GHz), 1,4 PB RAM | 17.808 kW | Chemische und physikalische Berechnungen (z. B. Untersuchungen von Erdöl und Flugzeugentwicklung) |

| Titan | Oak Ridge National Laboratory (Tennessee, USA) | 17.590,00 | Cray XK7, 18.688 AMD Opteron 6274 CPUs (16 Kerne, 2,20 GHz) + 18.688 Nvidia Tesla K20 GPGPUs, 693,5 TB RAM | 8.209 kW | Physikalische Berechnungen |

| Sequoia[5] | Lawrence Livermore National Laboratory (Kalifornien, USA) | 16.324,75 | IBM BlueGene/Q, 98.304 Power BQC-Prozessoren (16 Kerne, 1,60 GHz), 1,6 PB RAM | 7.890 kW | Simulation von Kernwaffentests |

| K computer | Advanced Institute for Computational Science (Japan) | 10.510,00 | 88.128 SPARC64-VIII 8-Core-Prozessoren (2,00 GHz), 1.377 TB RAM | 12.660 kW | Chemische und physikalische Berechnungen |

| Mira | Argonne National Laboratory (Illinois, USA) | 8.162,38 | IBM BlueGene/Q, 49.152 Power BQC-Prozessoren (16 Kerne, 1,60 GHz) | 3.945 kW | Entwicklung neuer Energiequellen, Technologien und Materialien, Bioinformatik |

| Hazel Hen[6] | Höchstleistungsrechenzentrum Stuttgart | 7.420,00 | Cray Aries Netzwerk; 7712 Nodes mit je 24 Kernen (Intel Xeon E5-2680 v3, 30M Cache, 2,50 GHz) | 3.200 kW | |

| JUQUEEN[7] | Forschungszentrum Jülich (Deutschland) | 5.900,00 | IBM BlueGene/Q, 28.672 Power BQC-Prozessoren (16 Kerne, 1,60 GHz), 448 TB RAM | 2.301 kW | Materialwissenschaften, theoretische Chemie, Elementarteilchenphysik, Umwelt, Astrophysik |

| SuperMUC IBM[8][9] | Leibniz-Rechenzentrum (LRZ) (Garching bei München, Deutschland) | 2.897,00 | 18.432 Xeon E5-2680 CPUs (8 Kerne, 2,7 GHz) + 820 Xeon E7-4870 CPUs (10 Kerne, 2,4 GHz), 340 TB RAM | 3.423 kW | Kosmologie über die Entstehung des Universums, Seismologie und Erdbebenvorhersage |

| Stampede | Texas Advanced Computing Center (Texas, USA) | 2.660,00 | Xeon E5-2680 CPUs (8 Kerne, 2,7 GHz) + Xeon E7-4870 CPUs, 185 TB RAM | 4.510 kW | Chemische und physikalische, biologische (z. B. Proteinstrukturanalyse), geologische (z. B. Erdbebenvorhersage), medizinische Berechnungen (z. B. Krebswachstum) |

| Tianhe-1A | National Supercomputer Center (Tianjin, China) | 2.256,60 | 14.336 Intel 6-Core-Xeon X5670 CPUs (2,93 GHz) + 7.168 Nvidia Tesla M2050 GPGPUs, 224 TB RAM | 4.040 kW | Chemische und physikalische Berechnungen (z. B. Untersuchungen von Erdöl und Flugzeugentwicklung) |

| Dawning Nebulae | National Supercomputing Center (Shenzhen, China) | 1.271,00 | Hybridsystem aus 55.680 Intel Xeon-Prozessoren (2,66 GHz) + 64.960 Nvidia Tesla GPGPU (1,15 GHz), 224 TB RAM | 2.580 kW | Meteorologie, Finanzwirtschaft u. a. |

| IBM Roadrunner | Los Alamos National Laboratory (New Mexico, USA) | 1.105,00 | 6.000 AMD Dual-Core-Prozessoren (3,2 GHz), 13.000 IBM Cell-Prozessoren (1,8 GHz), 103 TB RAM | 4.040 kW | Physikalische Simulationen (z. B. Atomwaffensimulationen) |

| HERMIT[10][8] | Höchstleistungsrechenzentrum Stuttgart (Deutschland) | 1.045,00 | Stufe 1: 7.104 AMD Opteron CPUs (Opteron 6276, 16 Kerne, 2,3 GHz), 126 TB RAM (CRAY XE6) | Wissenschaftliche und kommerzielle Anwendungen | |

| N. n. | Universität Bielefeld (Deutschland) | 529,70 | 208x Nvidia Tesla M2075-GPGPUs + 192x Nvidia GTX-580-GPUs + 152x Dual Quadcore Intel Xeon 5600 CPUs, 9,1 TB RAM | Fakultät für Physik: Numerische Simulationen, physikalische Berechnungen[11][12] | |

| SGI-Altix | NASA (USA) | 487,00 | 51.200 4-Core-Xeon, 3 GHz, 274,5 TB RAM | 3.897 kW | Weltraumforschung |

| BlueGene/L | Lawrence Livermore National Laboratory Livermore (USA) | 478,20 | 212.992 PowerPC 440 Prozessoren 700 MHz, 73.728 GB RAM | 924 kW | Physikalische Simulationen |

| Blue Gene Watson | IBM Thomas J. Watson Research Center (USA) | 91,29 | 40.960 PowerPC 440 Prozessoren, 10.240 GB RAM | 448 kW | Forschungsabteilung von IBM, aber auch Anwendungen aus Wissenschaft und Wirtschaft |

| ASC Purple | Lawrence Livermore National Laboratory Livermore (USA) | 75,76 | 12.208 Power5 CPUs, 48.832 GB RAM | 7.500 kW | Physikalische Simulationen (z. B. Atomwaffensimulationen) |

| MareNostrum | Universitat Politècnica de Catalunya (Spanien) | 63,63 | 10.240 PowerPC 970MP 2,3 GHz, 20,4 TB RAM | 1.015 kW | Klima- und Genforschung, Pharmazie |

| Columbia | NASA Ames Research Center (Silicon Valley, Kalifornien, USA) | 51,87 | 10.160 Intel Itanium 2 Prozessoren (Madison Kern), 9 TB RAM | Klimamodellierung, astrophysikalische Simulationen |

Ausgewählte aktuelle Superrechner (deutschlandweit)

| Name | Standort | TeraFLOPS (peak) | Konfiguration | TB RAM | Energiebedarf | Zweck |

|---|---|---|---|---|---|---|

| Hazel Hen[6] | Höchstleistungsrechenzentrum Stuttgart | 7.420,00 | Cray Aries Netzwerk; 7712 Nodes mit je 24 Kernen (Intel Xeon E5-2680 v3, 30M Cache, 2,50 GHz) | 987 | ~3.200 kW | |

| JUQUEEN[7] | Forschungszentrum Jülich (Deutschland) | 5.900,00 | IBM BlueGene/Q, 28.672 Power BQC-Prozessoren (16 Kerne, 1,60 GHz) | 448 | 2.301 kW | Materialwissenschaften, theoretische Chemie, Elementarteilchenphysik, Umwelt, Astrophysik |

| SuperMUC IBM[8][13] | Leibniz-Rechenzentrum (LRZ) (Garching bei München, Deutschland) | 2.897,00 | 18.432 Xeon E5-2680 CPUs (8 Kerne, 2,7 GHz), 820 Xeon E7-4870 CPUs (10 Kerne, 2,4 GHz) | 340 | 3.423 kW | Kosmologie über die Entstehung des Universums, Seismologie und Erdbebenvorhersage |

| HRSK-II [14][15] | Zentrum für Informationsdienste und Hochleistungsrechnen, TU Dresden | 1.600,00 | 43.866 CPU Kerne, Intel Haswell-EP-CPUs (Xeon E5 2680v3), 216 Nvidia Tesla-GPUs | 130 | Wissenschaftliche Anwendungen | |

| HLRE-3 "Mistral"[16][17] | Deutsches Klimarechenzentrum Hamburg | 1.400,00 | 1. Ausbaustufe (Juli 2015): 1.500 Knoten bullx B700 DLC, 36.000 Kerne (Haswell), 20 PB Lustre-Festplattensystem, 12 Visualisierungsknoten (je 2 NVidia Tesla K80 GPUs), Warmwasserkühlung | 120 | Klimamodellierung | |

| HERMIT[10][8] | Höchstleistungsrechenzentrum Stuttgart | 1.045,00 | Stufe 1: 7.104 AMD Opteron CPUs (Opteron 6276, 16 Kerne, 2,3 GHz) (CRAY XE6) | 126 | 1.850 kW | Wissenschaftliche und kommerzielle Anwendungen |

| Lichtenberg-Hochleistungsrechner[18] | Technische Universität Darmstadt | 951.34 | Phase 1: 704 Knoten á 2 Intel Xeon (8 Cores), 4 Knoten á 8 Intel Xeon (8 Cores), 70 Knoten á 2 Intel Xeon.

Phase 2: 596 Knoten á 2 Intel Xeon (12 Cores), 4 Knoten á 4 Intel Xeon (15 Cores), 32 Knoten á 2 Intel Xeon. |

76 | Wissenschaftliche Anwendungen | |

| N. n. | Universität Bielefeld | 529,70 | 208x Nvidia Tesla M2075-GPGPU, 192x Nvidia GTX-580-GPU, 152x Dual Quadcore Intel Xeon 5600 CPUs | 9,1 | Fakultät für Physik: Numerische Simulationen, physikalische Berechnungen | |

| Mogon | Johannes Gutenberg-Universität Mainz | 283,90 | 33.792 Opteron 6272 | 84 | 467 kW | Naturwissenschaften, Physik, Mathematik, Biologie, Medizin |

| JUROPA | Forschungszentrum Jülich | 274,80 | 26.304 Intel XEON (Nehalem-EP) 4-Core, 2,93 GHz Prozessoren | 52 | 1.549 kW | Materialwissenschaften, theoretische Chemie, Elementarteilchenphysik, Umwelt, Astrophysik |

| HLRN-II[19] (SGI Altix ICE/XE) | Zuse-Institut Berlin, Regionales Rechenzentrum für Niedersachsen | 250,00 | 21.248 Cores Intel Xeon Harpertown 3,0 GHz und Nehalem-EP 2,93 GHz | 76 |

Physik, Chemie, Umwelt- und Meeresforschung, Ingenieurwissenschaften | |

| OCuLUS[20] | Paderborn Center for Parallel Computing, Universität Paderborn | 200,00 | 614 Knoten Dual Intel E5-2670 (9856 Cores) und 64 GB RAM | 45 | Ingenieurwissenschaften, Naturwissenschaften | |

| HLRE 2[21] | Deutsches Klimarechenzentrum Hamburg | 144,00 | 8064 IBM Power6 Dual Core CPUs, 6 Petabyte Disk | 20 | Klimamodellierung | |

| Komplex MPI 2 | RWTH Aachen | 103,60 | 176 Knoten mit insgesamt 1.408 Intel Xeon 2,3 GHz 8-Core-Prozessoren | 22 | Wissenschaftliche Anwendungen | |

| HPC-FF | Forschungszentrum Jülich | 101,00 | 2160 Intel Core i7 (Nehalem-EP) 4-Core, 2,93 GHz Prozessoren | 24 | europäische Fusionsforschung | |

| HLRB II | LRZ Garching | 56,52 | 9.728 CPUs 1,6 GHz Intel Itanium 2 (Montecito Dual Core) | 39 | Naturwissenschaften, Astrophysik und Materialforschung | |

| NEC SX-9 | Deutscher Wetterdienst (Offenbach) | 49,15 | 480 Vektor-CPUs SX-9 | 15 | Numerische Wettervorhersage und Klimasimulationen | |

| HP XC4000 | Höchstleistungsrechner-Kompetenzzentrum Baden-Württemberg (hkz-bw), Karlsruhe | 30,8 | 6.192 AMD Opteron Dual Core 2,4 GHz | 12 | Physikalische Simulationen | |

| PALMA | Universität Münster | 30,22 | 3528 Intel Xeon Cores | 45,9 | Physikalische Simulationen, mathematische Modellierung | |

| FLOW[22] | Carl von Ossietzky Universität Oldenburg | 24,3 | 372 x Intel Xeon Processor X5650 ("Westmere-EP", 6 cores, 2.66 GHz, 12 MB Cache, Max. Mem. Speed 1333 MHz, QPI 6.4 GT/s, TDP 95 W) | 6,0 | Windenergieforschung | |

| ClusterVision HPC[23] | Technische Universität Bergakademie Freiberg | 22,61 | 1728 Cores Intel Xeon X5670 (2,93 GHz) + 280 Cores AMD Opteron 6276, (2,3GHz) | 0,5 | Ingenieurwissenschaften, Quantenchemie, Strömungsmechanik, Geophysik | |

| SGI Altix 4700 | TU Dresden | 13,10 | 2048 Cores Intel Itanium II Montecito 1,6 GHz | 7 | Naturwissenschaften, Biologie | |

| NEC SX8/576M72 | Höchstleistungsrechenzentrum Stuttgart (HLRS) | 8,92 | 576 CPUs NEC SX-8, 2 GHz | 10 | Ingenieurwissenschaftliche Anwendungen, Physik, Chemie, Lebenswissenschaften, Nutzung durch Industrie | |

| CHiC[24] Cluster (IBM x3455) | TU Chemnitz | 8,21 | 2152 Cores aus 1076 Dual Core 64 bit AMD Opteron 2218 (2,6 GHz) | Modellierung und numerische Simulationen |

Die geschichtlich Schnellsten ihrer Zeit

Nachfolgende Tabelle listet einige der schnellsten Superrechner ihrer jeweiligen Zeit auf:

| Jahr | Supercomputer | Spitzengeschwindigkeit bis 1959 in OPS ab 1960 in FLOPS |

Ort |

|---|---|---|---|

| 1906 | Babbage Analytical Engine, Mill | 0,3 | RW Munro, Woodford Green, Essex, England |

| 1928 | IBM 301[25] | 1,7 | verschiedene Orte weltweit |

| 1931 | IBM Columbia Difference Tabulator[26] | 2,5 | Columbia University |

| 1940 | Zuse Z2 | 3,0 | Berlin, Deutschland |

| 1941 | Zuse Z3 | 5,3 | Berlin, Deutschland |

| 1942 | Atanasoff-Berry Computer (ABC) | 30,0 | Iowa State University, Ames (Iowa), USA |

| TRE Heath Robinson | 200,0 | Bletchley Park, Milton Keynes, England | |

| 1.000,0 | entspricht 1 kilo-OPS | ||

| 1943 | Flowers Colossus | 5.000,0 | Bletchley Park, Milton Keynes, England |

| 1946 | UPenn ENIAC (vor den Modifikationen von 1948+) |

50.000,0 | Aberdeen Proving Ground, Maryland, USA |

| 1954 | IBM NORC | 67.000,0 | U.S. Naval Proving Ground, Dahlgren, Virginia, USA |

| 1956 | MIT TX-0 | 83.000,0 | Massachusetts Inst. of Technology, Lexington, Massachusetts, USA |

| 1958 | IBM SAGE | 400.000,0 | 25 U.S. Air Force-Stützpunkte in den USA und ein Ort in Kanada (52 Computer) |

| 1960 | UNIVAC LARC | 500.000,0 | Lawrence Livermore National Laboratory, Kalifornien, USA |

| 1.000.000,0 | entspricht 1 MFLOPS, 1 Mega-FLOPS | ||

| 1961 | IBM 7030 „Stretch“ | 1.200.000,0 | Los Alamos National Laboratory, New Mexico, USA |

| 1964 | CDC 6600 | 3.000.000,0 | Lawrence Livermore National Laboratory, Kalifornien, USA |

| 1969 | CDC 7600 | 36.000.000,0 | |

| 1974 | CDC STAR-100 | 100.000.000,0 | |

| 1975 | Burroughs ILLIAC IV | 150.000.000,0 | NASA Ames Research Center, Kalifornien, USA |

| 1976 | Cray-1 | 250.000.000,0 | Los Alamos National Laboratory, New Mexico, USA (weltweit über 80 Mal verkauft) |

| 1981 | CDC Cyber 205 | 400.000.000,0 | verschiedene Orte weltweit |

| 1983 | Cray X-MP/4 | 941.000.000,0 | Los Alamos National Laboratory; Lawrence Livermore National Laboratory; Battelle; Boeing |

| 1.000.000.000,0 | entspricht 1 GFLOPS, 1 Giga-FLOPS | ||

| 1984 | M-13 | 2.400.000.000,0 | Scientific Research Institute of Computer Complexes, Moskau, UdSSR |

| 1985 | Cray-2/8 | 3.900.000.000,0 | Lawrence Livermore National Laboratory, Kalifornien, USA |

| 1989 | ETA10-G/8 | 10.300.000.000,0 | Florida State University, Florida, USA |

| 1990 | NEC SX-3/44R | 23.200.000.000,0 | NEC Fuchu Plant, Fuchū, Japan |

| 1993 | Thinking Machines CM-5/1024 | 65.500.000.000,0 | Los Alamos National Laboratory; National Security Agency |

| Fujitsu Numerical Wind Tunnel | 124.500.000.000,0 | National Aerospace Laboratory, Tokio, Japan | |

| Intel Paragon XP/S 140 | 143.400.000.000,0 | Sandia National Laboratories, New Mexico, USA | |

| 1994 | Fujitsu Numerical Wind Tunnel | 170.400.000.000,0 | National Aerospace Laboratory, Tokio, Japan |

| 1996 | Hitachi SR2201/1024 | 220.400.000.000,0 | Universität Tokio, Japan |

| 1996 | Hitachi/Tsukuba CP-PACS/2048 | 368.200.000.000,0 | Center for Computational Physics, University of Tsukuba, Tsukuba, Japan |

| 1.000.000.000.000,0 | entspricht 1 TFLOPS, 1 Tera-FLOPS | ||

| 1997 | Intel ASCI Red/9152 | 1.338.000.000.000,0 | Sandia National Laboratories, New Mexico, USA |

| 1999 | Intel ASCI Red/9632 | 2.379.600.000.000,0 | |

| 2000 | IBM ASCI White | 7.226.000.000.000,0 | Lawrence Livermore National Laboratory, Kalifornien, USA |

| 2002 | NEC Earth Simulator | 35.860.000.000.000,0 | Earth Simulator Center, Yokohama-shi, Japan |

| 2004 | SGI Project Columbia | 42.700.000.000.000,0 | Project Columbia, NASA Advanced Supercomputing Facility, USA |

| IBM BlueGene/L | 70.720.000.000.000,0 | U.S. Department of Energy/IBM, USA | |

| 2005 | IBM BlueGene/L | 136.800.000.000.000,0 | U.S. Department of Energy/U.S. National Nuclear Security Administration, Lawrence Livermore National Laboratory, Kalifornien, USA |

| 1.000.000.000.000.000,0 | entspricht 1 PFLOPS, 1 Peta-FLOPS | ||

| 2008 | IBM Roadrunner | 1.105.000.000.000.000,0 | U.S. Department of Energy/U.S. National Nuclear Security Administration, Los Alamos National Laboratory |

| 2010 | Tianhe-1A | 2.507.000.000.000.000,0 | National Supercomputer Center in Tianjin, China |

| 2011 | K Computer | 10.510.000.000.000.000,0 | Advanced Institute for Computational Science, Japan |

| 2012 | Sequoia | 16.324.750.000.000.000,0 | Lawrence Livermore National Laboratory, Kalifornien, USA |

| 2012 | Titan | 17.590.000.000.000.000,0 | Oak Ridge National Laboratory, Tennessee, USA |

| 2013 | Tianhe-2 | 33.863.000.000.000.000,0 | National Supercomputer Center in Guangzhou, China |

| 2016 | Sunway TaihuLight[27] | 93.000.000.000.000.000,0 | China |

Diese Grafik macht das nochmal sehr deutlich (bitte die logarithmische y-Achse beachten).

Sonstige Leistungen

Meilensteine

- 1997: Deep Blue 2 (Hochleistungsrechner von IBM) schlägt als erster Computer einen Schachweltmeister in einem offiziellen Zweikampf.

- 2002: Yasumasa Kanada bestimmt die Kreiszahl Pi mit einem Hitachi SR8000 der Universität Tokio auf 1,24 Billionen Stellen genau.

- 2007: Intels Desktopprozessor Core 2 Quad Q6600 schafft ca. 38,40 GFLOPS und hat damit Supercomputerniveau der frühen 1990er Jahre.[28]

- 2014: NVIDIAs GPU-Prozessor Tesla K80 erzielt eine Leistung von ca. 8,7 TeraFLOPS und hat damit das Supercomputerniveau der frühen 2000er Jahre. Er schlägt somit den Supercomputer des Jahres 2000, den IBM ASCI White, welcher damals eine Leistung von 7,226 TeraFLOPS bot.[29]

Vergleiche

- Die über 1.000.000 aktiven Rechner der Berkeley Open Infrastructure for Network Computing erbringen derzeit (Stand: Februar 2014) eine Spitzenrechenleistung zwischen 8 und 21 PetaFLOPS, die je nach Tag schwanken kann.[30][31][32]

- Sämtliche Berechnungen aller Computer weltweit von 1960 bis 1970 könnte der Earth Simulator in etwa 35 Minuten durchführen.

- Wenn jeder der rund 7 Milliarden Menschen auf der Welt mit einem Taschenrechner ohne jede Unterbrechung in jeder Sekunde eine Rechnung absolvierte, müsste die gesamte Menschheit 538 Jahre arbeiten, um das zu erledigen, was der Tianhe-2 in einer Stunde bewältigen könnte.

- Mit seiner Performance könnte der K computer die Meter eines Lichtjahres binnen etwa einer Sekunde „zählen“.

Korrelatoren im Vergleich

- Der Korrelator des Atacama Large Millimeter/submillimeter Array (ALMA) führt derzeit (Dezember 2012) 17 PetaFLOPS aus.[33][34]

- Die Rechenleistung des WIDAR Korrelator am Expanded Very Large Arrays (EVLA) ist (Juni 2010) mit 40 PetaFLOPS angegeben.[35][36]

- Der geplante Korrelator des Square Kilometre Array (SKA) (Bauzeit 2016 bis 2023) soll 4 ExaFLOPS (4000 PetaFLOPS) (Informationsstand Juni 2010) ausführen können.[35]

Siehe auch

Literatur

- Christoph Pöppe: Supercomputing: Rekorde; Innovation; Perspektive. In: Spektrum-d.-Wiss. Nr. 2. Dossier, Heidelberg 2007, ISBN 978-3-938639-52-8.

- Shlomi Dolev: Optical supercomputing. Springer, Berlin 2008, ISBN 3-540-85672-2.

- William J. Kaufmann, et al.: Supercomputing and the transformation of science. Scientific American Lib., New York 1993, ISBN 0-7167-5038-4.

- Paul B. Schneck: Supercomputer architecture. Kluwer, Boston 1987, ISBN 0-89838-238-6.

- Aad J. van der Steen: Evaluating supercomputers – strategies for exploiting, evaluating and benchmarking computers with advanced architectures. Chapman and Hall, London 1990, ISBN 0-412-37860-4.

Weblinks

- TOP500 Liste der leistungsstärksten Supercomputer (englisch)

- TOP500 Liste der energieeffizientesten Supercomputer (englisch)

- The International Conference for High Performance Computing and Communications (englisch)

- The International Supercomputing Conference (englisch)

Einzelnachweise

- ↑ a b List Statistics

- ↑ Test: Intel Core i7 mit Nehalem-Quad-Core tecchannel.de

- ↑ The Green 500 List

- ↑ Jack Dongarra: Trip Report to China and Tianhe-2 Supercomputer, 3 Juni 2013 (PDF; 8,2 MB)

- ↑ asc.llnl.gov ASC Sequoia

- ↑ a b Cray XC40 Hazel Hen. Höchstleistungsrechenzentrum Stuttgart, abgerufen am 5. November 2015.

- ↑ a b JUQUEEN Forschungszentrum Jülich

- ↑ a b c d Supercomputer: USA holen Spitzenposition zurück. Heise Online, 18. Juni 2012

- ↑ SuperMUC Petascale System. lrz.de

- ↑ a b HLRS HERMIT Webseite

- ↑ Technische Daten

- ↑ sysGen-Projektreferenz (PDF; 291 kB) Universität Bielefeld, Fakultät für Physik

- ↑ LRZ: SuperMUC Nr. 4 der Top500-Liste

- ↑ http://www.heise.de/newsticker/meldung/Supercomputer-an-der-TU-Dresden-nimmt-offiziell-den-Betrieb-auf-2650076.html

- ↑ http://www.heise.de/ct/ausgabe/2015-13-Neuer-Petaflops-Rechner-an-der-TU-Dresden-2665018.html

- ↑ [1]

- ↑ https://www.dkrz.de/about/aufgaben/dkrz-geschichte/rechnerhistorie-1

- ↑ HHLR: Lichtenberg Hochleistungsrechner. Abgerufen am 4. August 2016.

- ↑ HLRN-II

- ↑ OCuLUS

- ↑ https://www.dkrz.de/about/aufgaben/dkrz-geschichte/rechnerhistorie-1

- ↑ [2]

- ↑ ClusterVision HPC

- ↑ CHiC

- ↑ IBM 301 Accounting Machine

- ↑ The Columbia Difference Tabulator – 1931

- ↑ http://www.heise.de/newsticker/meldung/Supercomputer-China-ueberholt-die-USA-3241342.html

- ↑ intel.com

- ↑ computerbase.de

- ↑ Host-Übersicht auf boincstats.com

- ↑ Übersicht BOINC-Leistung auf boincstats.com

- ↑ Übersicht BOINC-Leistung auf allprojectstats.com

- ↑ Powerful Supercomputer Makes ALMA a Telescope

- ↑ Höchstgelegener Supercomputer der Welt gleicht Astronomiedaten ab. Heise online

- ↑ a b Cross-Correlators & New Correlators – Implementation & choice of architecture. (PDF; 9,4 MB) National Radio Astronomy Observatory, S. 27

- ↑ The Expanded Very Large Array Project – The ‚WIDAR‘ Correlator. (PDF; 13,2 MB) National Radio Astronomy Observatory, S. 10